Conclusão principal: Criado em 1966 por Joseph Weizenbaum no MIT, o ELIZA ilustrou o efeito ELIZA: os humanos percepcionam inteligência onde existe apenas simulação. Esta lição crucial para o sector da banca e dos seguros exige uma transparência absoluta sobre os limites dos chatbots, evitando qualquer confusão sobre a sua capacidade de processar dados sensíveis ou de compreender contextos complexos.

Para as instituições financeiras, a confiança depende de uma transparência absoluta no que diz respeito às tecnologias de IA. O chatbot eliza, o primeiro programa de conversação criado em 1966 no MIT, revelou o efeito ELIZA: uma tendência humana para atribuir inteligência real a sistemas incapazes de a possuir. Descobre como este estudo de referência orienta a conceção ética dos chatbots da banca e dos seguros, alinhando claramente as expectativas dos clientes com as capacidades reais, evitando riscos de desconfiança e assegurando o cumprimento de normas regulamentares rigorosas e a ética profissional para uma relação sustentável com os clientes.

Chatbot ELIZA: as origens da inteligência artificial conversacional

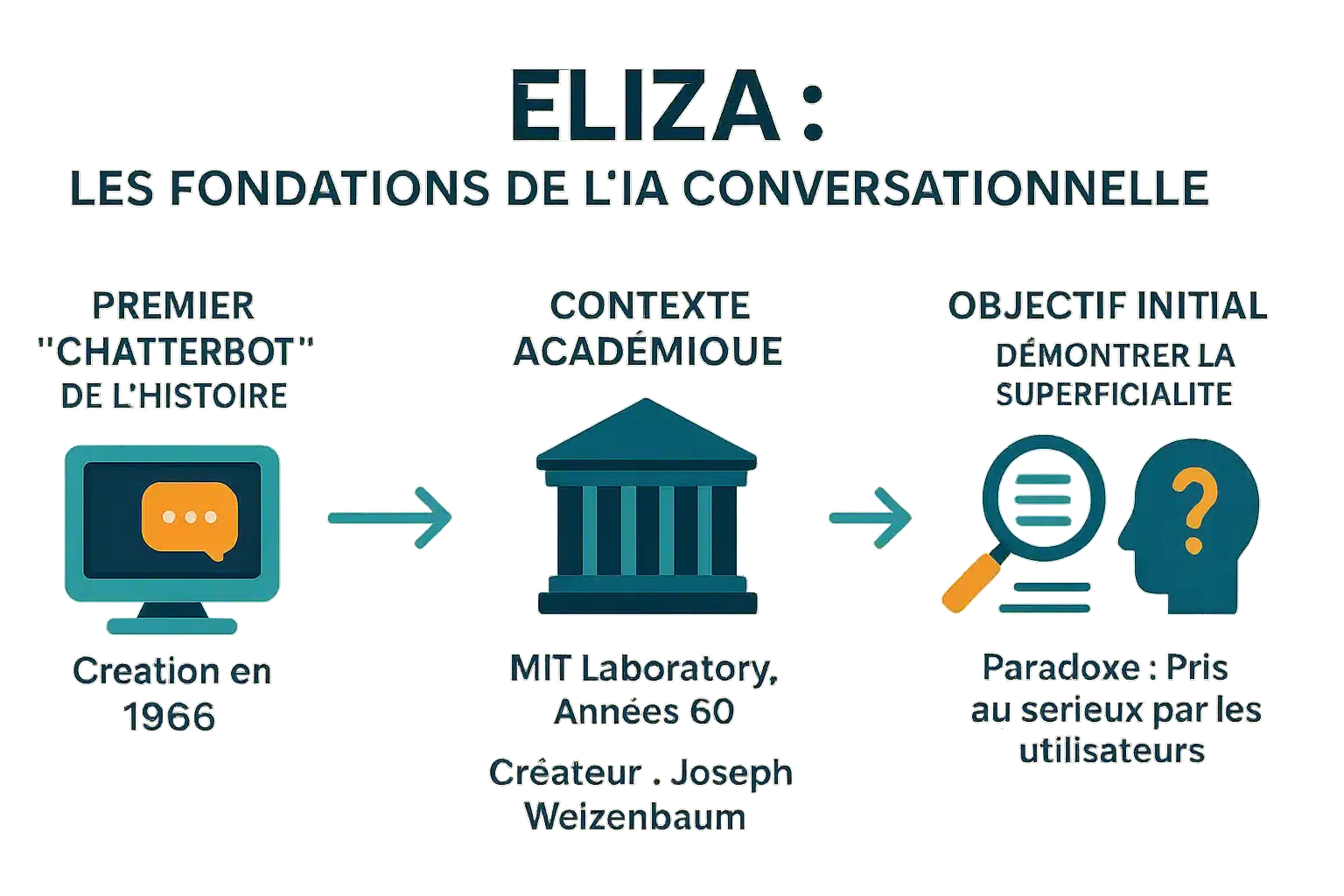

O primeiro “chatterbot” da história

Criada em 1966 por Joseph Weizenbaum no MIT, ELIZA é o primeiro chatbot da história. O seu nome foi inspirado em Eliza Doolittle (“Pygmalion”), simbolizando a evolução através da interação. Transforma frases como “Estou assustado” em “Porque estás assustado? através do reconhecimento e substituição de palavras-chave. Este mecanismo, sem qualquer compreensão real, influenciou os assistentes modernos e demonstrou que mesmo os programas simples podiam enganar os utilizadores.

Um criador e um contexto: o MIT nos anos 60

Desenvolvido no MIT entre 1964 e 1967, o ELIZA utilizava MAD-SLIP e scripts Lisp. O script DOCTOR simula um psicoterapeuta Rogeriano, reformulando o que é dito sem qualquer base externa. Redescoberto em 2021 depois de ter estado perdido durante décadas, o seu código fonte permite reconstruir conversas antigas e estudar as técnicas da época.

O objetivo inicial: uma demonstração de superficialidade

O objetivo de Weizenbaum era demonstrar a superficialidade das trocas homem-máquina. Não procurava uma verdadeira IA, mas revelar como os humanos projectam inteligência em máquinas simples. Os utilizadores, incluindo a sua secretária, partilharam informações pessoais, acreditando que estavam a falar com um ser humano. O efeito ELIZA, um importante fenómeno psicológico, sublinha esta tendência para a antropomorfização. Em ‘Computer Power and Human Reason’, adverte contra esta confusão. O efeito ELIZA continua a inspirar os chatbots modernos. Um estudo recente, realizado em 2023, mostrou que superou o GPT-3.5 num teste de Turing, sem superar o GPT-4 ou os humanos.

Como funciona o ELIZA: uma ilusão de compreensão

Criada em 1966 por Weizenbaum, a ELIZA demonstrou a superficialidade das trocas homem-máquina. Apesar da sua simplicidade, provocou uma reação inesperada: os utilizadores partilharam dados pessoais, acreditando numa verdadeira empatia. Este “efeito ELIZA” levou Weizenbaum a alertar para os riscos antropomórficos em “Computer Power and Human Reason”. O seu código, redescoberto em 2021, está no GNU Emacs.

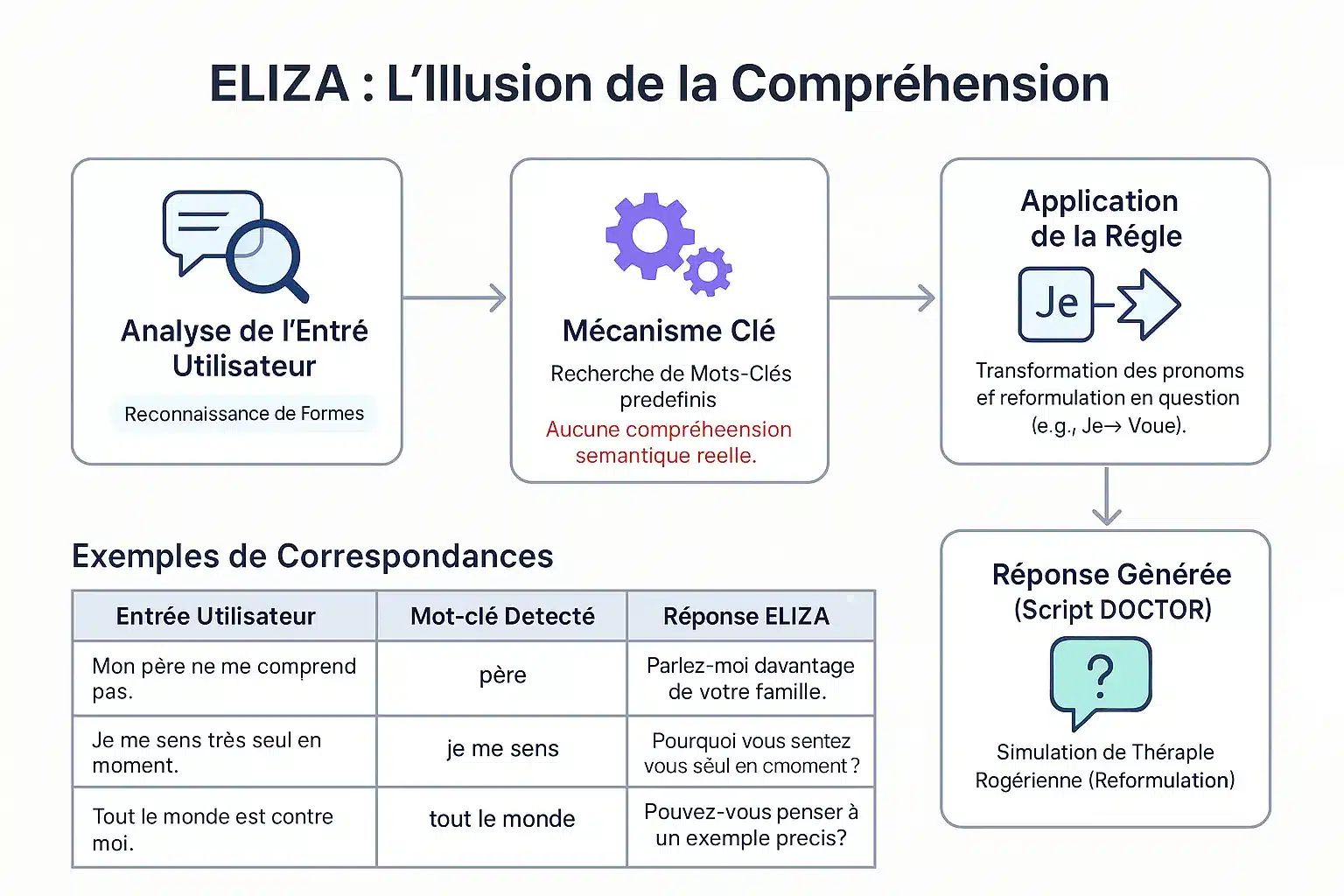

O método de correspondência de padrões

O ELIZA identifica as palavras-chave através de um conjunto de chaves. Em função da sua prioridade, decompõe e remonta as frases. Exemplo: “eu” → “tu” para reformular em perguntas. “O meu pai não me compreende” → “Fala da tua família”. Não há compreensão real: um mecanismo padrão que simula uma escuta empática.

O famoso guião “DOCTOR” e a terapia Rogeriana

O guião DOCTOR, inspirado na terapia Rogeriana, reflecte o que o paciente diz sem dar conselhos. Exemplo: “Sinto-me só” → “Porquê só?”. Weizenbaum escolheu este contexto para evitar uma base externa. Esta simplicidade revelou a propensão humana para antropomorfizar as máquinas. ELIZA lançou as bases dos chatbots modernos. Um estudo de 2023 mostra que superou o GPT-3.5 num teste de Turing, mas não o GPT-4 ou os humanos.

| Entrada | Palavra-chave | Resposta |

|---|---|---|

| O meu pai não me compreende. | O teu pai | Fala da tua família. |

| Sinto-me só. | Eu sinto-te | Porque te sentes só? |

| Todos estão contra mim. | Toda a gente | Dá um exemplo concreto. |

| Acho que preciso de ajuda. | Acho que sim | Achas que precisas de ajuda? |

O efeito ELIZA: quando os humanos projectam inteligência nas máquinas

Definição de um fenómeno psicológico importante

O efeito ELIZA refere-se à tendência para atribuir compreensão humana a símbolos gerados por computador. Um distribuidor que exibe “OBRIGADO” é visto como uma gratidão genuína, apesar de estar pré-programado.

Observado já em 1966 com ELIZA, o primeiro chatbot de Joseph Weizenbaum no MIT, este fenómeno mostrava que os utilizadores projectavam emoções e compreensão nas suas respostas simples, apesar da sua simplicidade. O efeito é o resultado da dissonância cognitiva.

Os utilizadores estão conscientes do programa mecânico, mas agem como se o compreendessem. Esta ilusão, após breves interações, alerta-nos para os limites da IA e para o risco de excesso de confiança.

Antropomorfismo e a reação de Weizenbaum

Joseph Weizenbaum criou o ELIZA em 1966 para demonstrar a superficialidade da interação homem-máquina. Ficou surpreendido com o facto de os utilizadores desenvolverem “pensamentos delirantes ” após breves interações. A sua secretária recusou-se a deixá-lo observar as suas trocas, preferindo partilhar os seus problemas com o programa.

Esta reação levou-o a criticar a IA, salientando que as máquinas não têm capacidade de julgamento humano. Em “Computer Power and Human Reason” (Poder do Computador e Razão Humana), descreveu como obsceno confiar juízos de valor a máquinas, em particular no domínio da psicologia ou da justiça, porque só os seres humanos têm responsabilidade moral. O seu trabalho inspira o debate ético.

O efeito ELIZA põe em evidência a nossa tendência para antropomorfizar as máquinas, atribuindo-lhes uma inteligência e uma empatia que elas não possuem, um fenómeno que ainda hoje nos acompanha.

As caraterísticas desta ilusão

Estas manifestações revelam uma dissonância cognitiva entre os conhecimentos técnicos e o comportamento dos utilizadores. As principais são :

- Atribuição de consciência ou intencionalidade mesmo a respostas pré-programadas.

- Projecta emoções nas respostas, apesar da sua simplicidade.

- Partilha informações pessoais sem reservas, acredita na escuta empática.

- A sensação de ser ouvido e compreendido por uma máquina.

Esta ilusão é reforçada por interfaces que encorajam a antropomorfização (nomes, diálogo). Algumas pessoas desenvolvem laços emocionais, ou mesmo apaixonam-se por chatbots, acreditando numa relação real. É preciso distinguir entre a IA fraca (sem consciência) e a IA forte. Os profissionais devem promover a transparência para evitar abusos.

O legado da ELIZA: uma pedra angular para a IA moderna

A ELIZA, criada em 1966 por Joseph Weizenbaum, revelou uma falha na perceção da IA. O seu funcionamento baseado no reconhecimento de palavras-chave ilustrou os limites da IA primitiva, uma lição essencial para as instituições financeiras, onde a transparência dos sistemas automatizados protege os clientes contra interpretações erradas.

O precursor da IA de conversação

Desenvolvida no MIT em 1966, a ELIZA simulava um psicoterapeuta utilizando um guião DOCTOR. Por exemplo, uma frase como “Estou stressado” era transformada em “Porque é que te sentes stressado? Apesar da sua falta de compreensão real, enganava os utilizadores, criando a ilusão de um diálogo humano.

O efeito ELIZA demonstrou a propensão humana para antropomorfizar as máquinas, um fenómeno que ainda é relevante nos assistentes virtuais modernos. Este precursor do teste de Turing destacou os desafios da simulação de conversação, ao mesmo tempo que inspirou os chatbots actuais.

Limitações técnicas e avisos do projetista

ELIZA carece de memória contextual e de compreensão do significado. As suas respostas dependiam inteiramente de regras predefinidas. No seu livro Computer Power and Human Reason, Weizenbaum sublinhou a distinção fundamental entre o cálculo mecânico e o julgamento humano.

Apesar do seu carácter revolucionário, o ELIZA não era mais do que um espelho inteligente das palavras do utilizador, revelando as suas limitações face à complexidade e evidenciando o fosso entre a simulação e a compreensão.

Esta crítica continua a ser crucial para o banco: na concessão de empréstimos ou na deteção de fraudes, a IA deve ser sempre supervisionada por especialistas humanos para evitar decisões erradas e manter a responsabilidade legal.

A ressurreição do código original: uma atualização arqueológica

Em 2021, o código fonte do ELIZA foi encontrado nos arquivos do MIT e publicado como código aberto. Em 2024, uma equipa restaurou-o num emulador IBM 7094, reproduzindo fielmente as interações originais.

Este restauro histórico oferece-te um vislumbre dos primeiros tempos da IA conversacional. O código, acessível em GNU Emacs, é utilizado em currículos universitários para ensinar os fundamentos da IA e recebeu um prémio Legacy Peabody Award em 2021.

Para os sectores financeiros, o ELIZA recorda-nos que a IA carece de uma verdadeira compreensão. Uma transparência clara sobre as suas capacidades limita os riscos de uma partilha excessiva de dados pessoais e reforça a confiança dos clientes nos serviços digitais.

ELIZA hoje: uma lição fundamental para a era da IA

Mais do que um artefacto: um estudo de caso intemporal

ELIZA, criada em 1966 por Joseph Weizenbaum no MIT, foi um marco na história da IA. Este chatbot utilizava padrões e regras simples para simular uma conversa. O script “DOCTOR” imitava um psicoterapeuta Rogeriano, reformulando afirmações em perguntas. No entanto, não compreendia a linguagem, apenas palavras-chave. Esta limitação foi intencional para demonstrar a superficialidade da interação homem-máquina.

No entanto, os utilizadores apercebem-se frequentemente de uma compreensão humana. Este “efeito ELIZA” revela a nossa tendência para antropomorfizar as máquinas. Atualmente, face aos LLM, esta distinção entre simulação e inteligência autêntica é vital. As instituições financeiras devem

Implicações para as empresas e para a gestão da confiança

Nos sectores da banca e dos seguros, a gestão das expectativas dos clientes é crucial. Os chatbots devem ser transparentes quanto à sua natureza: não compreendem a linguagem, apenas simulam respostas.

- Define claramente as capacidades e limitações dos chatbots para os clientes.

- Evita exagerar a empatia ou a compreensão dos agentes automatizados.

- Tem em conta o impacto psicológico da interação homem-máquina ao conceber os percursos dos clientes.

- Assegurar a responsabilidade ética na implantação de tecnologias simuladas.

Estes princípios permitem-nos construir relações duradouras com os clientes, baseadas na transparência e na confiança. Num sector em que a confiança é essencial, esta vigilância é indispensável para evitar decepções e manter a reputação.

ELIZA, apesar da sua idade, ilustra o ponto essencial: uma simulação não é compreensão. Para os bancos e as companhias de seguros, a transparência sobre os limites dos chatbots é crucial. Evita sobrevalorizar a sua empatia, respeitando a ética e a confiança dos clientes. Uma lição intemporal face à IA moderna.

FAQ

O que é o efeito ELIZA e o que significa para as instituições financeiras?

O efeito ELIZA refere-se à tendência dos utilizadores para atribuírem compreensão e inteligência humanas aos sistemas automatizados, mesmo quando estes não possuem essas capacidades. No sector bancário, este efeito pode levar a uma confiança excessiva nos chatbots, correndo-se o risco de mal-entendidos sobre as suas reais limitações. As instituições devem, por isso, esclarecer sistematicamente as capacidades e restrições destas ferramentas, de forma a preservar a transparência e a segurança das interações com os clientes.

O que foi o chatbot ELIZA e o seu papel histórico?

Criada em 1966 por Joseph Weizenbaum no MIT, a ELIZA é considerada o primeiro chatbot da história. Utilizava um método de correspondência de padrões para gerar respostas com base em regras predefinidas. Embora inicialmente concebido para simular uma terapia Rogeriana, o ELIZA revelou os limites da compreensão das máquinas, sublinhando a importância da transparência na interação homem-máquina, um princípio fundamental para os serviços bancários modernos.