Belangrijkste les: ELIZA werd in 1966 gecreëerd door Joseph Weizenbaum aan het MIT en illustreerde het ELIZA-effect: mensen nemen intelligentie waar waar waar alleen simulatie is. Deze cruciale les voor de bank- en verzekeringssector vereist absolute transparantie over de grenzen van chatbots, zodat er geen verwarring ontstaat over hun vermogen om gevoelige gegevens te verwerken of complexe contexten te begrijpen.

Voor financiële instellingen is vertrouwen afhankelijk van absolute transparantie als het gaat om AI-technologieën. De eliza-chatbot, het eerste conversatieprogramma dat in 1966 bij MIT werd gemaakt, onthulde het ELIZA-effect: de menselijke neiging om echte intelligentie toe te schrijven aan systemen die deze niet bezitten. Ontdek hoe dit baanbrekende onderzoek de leidraad vormt voor het ethische ontwerp van chatbots voor banken en verzekeringen, waarbij de verwachtingen van de klant duidelijk worden afgestemd op de werkelijke capaciteiten, risico’s van wantrouwen worden voorkomen en naleving van strenge wettelijke normen en beroepsethiek wordt gewaarborgd voor een duurzame klantrelatie.

ELIZA chatbot: de oorsprong van conversationele kunstmatige intelligentie

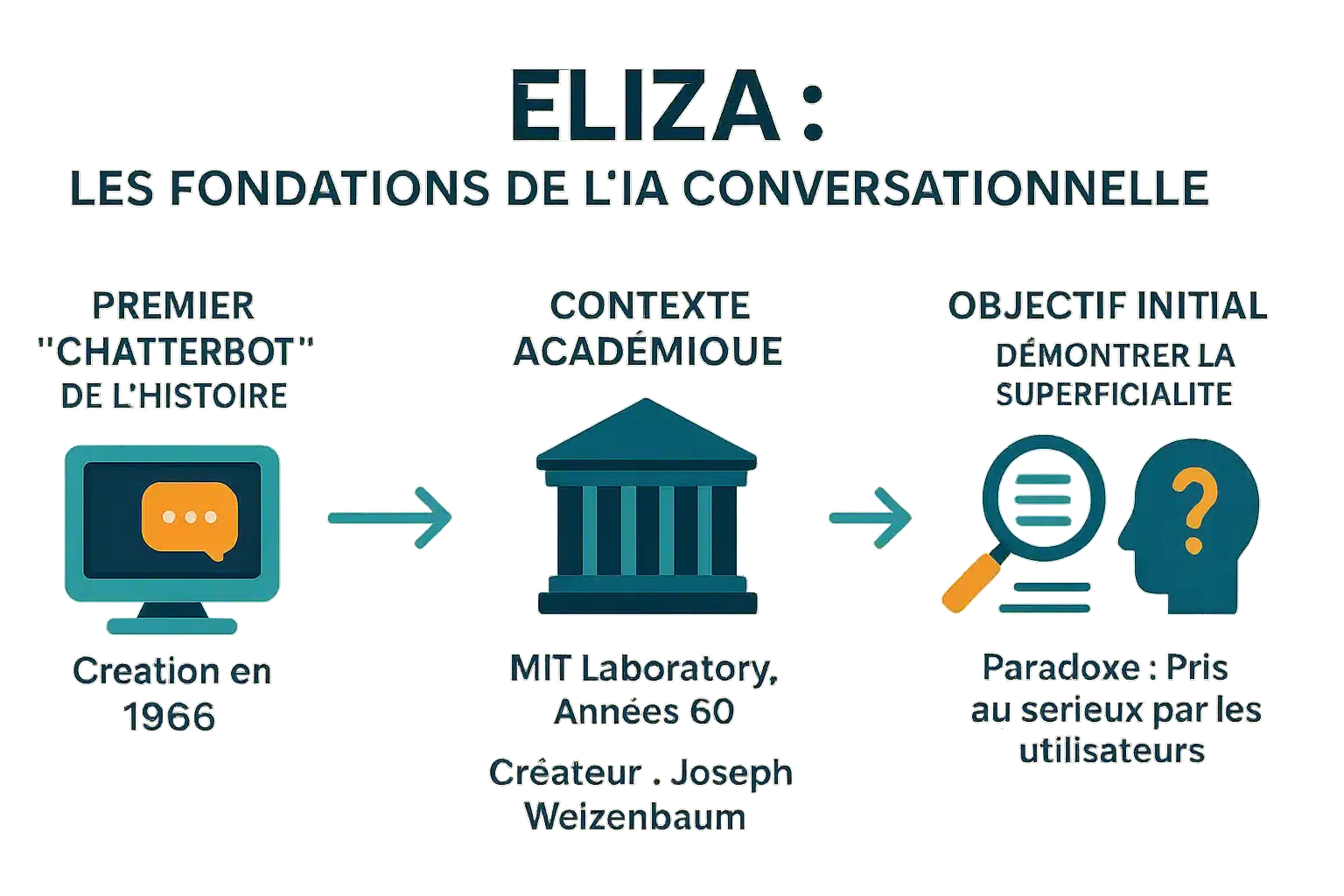

De eerste “chatterbot” in de geschiedenis

ELIZA werd in 1966 gecreëerd door Joseph Weizenbaum aan het MIT en is de eerste chatbot in de geschiedenis. De naam is geïnspireerd op Eliza Doolittle (‘Pygmalion’) en symboliseert evolutie door interactie. Het veranderde zinnen als ‘Ik ben bang’ in ‘Waarom ben je bang? via trefwoordherkenning en -vervanging. Dit mechanisme, zonder echt begrip, beïnvloedde moderne assistenten en liet zien dat zelfs eenvoudige programma’s gebruikers kunnen misleiden.

Een maker en een context: MIT in de jaren 1960

ELIZA werd tussen 1964 en 1967 bij MIT ontwikkeld en maakte gebruik van MAD-SLIP en Lisp-scripts. Het DOCTOR-script simuleert een Rogeriaanse psychotherapeut, die herformuleert wat er wordt gezegd zonder enige externe basis. De broncode werd in 2021 herontdekt nadat deze tientallen jaren verloren was gegaan en maakt het mogelijk om oude gesprekken te reconstrueren en de technieken van die tijd te bestuderen.

Het oorspronkelijke doel: een demonstratie van oppervlakkigheid

Het doel van Weizenbaum was om de oppervlakkigheid van uitwisselingen tussen mens en machine aan te tonen. Hij was niet op zoek naar echte AI, maar wilde laten zien hoe mensen intelligentie projecteren op eenvoudige machines. Gebruikers, waaronder zijn secretaresse, deelden persoonlijke informatie in de overtuiging dat ze met een mens praatten. Het ELIZA-effect, een belangrijk psychologisch fenomeen, onderstreept deze neiging tot antropomorfiseren. In ‘Computer Power and Human Reason’ waarschuwde hij voor deze verwarring. ELIZA inspireert nog steeds moderne chatbots. Een recent onderzoek in 2023 toonde aan dat het beter presteerde dan GPT-3.5 in een Turingtest, zonder beter te presteren dan GPT-4 of mensen.

Hoe ELIZA werkt: een illusie van begrip

ELIZA werd in 1966 gemaakt door Weizenbaum en toonde de oppervlakkigheid aan van uitwisselingen tussen mens en machine. Ondanks de eenvoud lokte het een onverwachte reactie uit: gebruikers deelden persoonlijke details en geloofden in oprechte empathie. Dit “ELIZA-effect” leidde ertoe dat Weizenbaum waarschuwde voor de

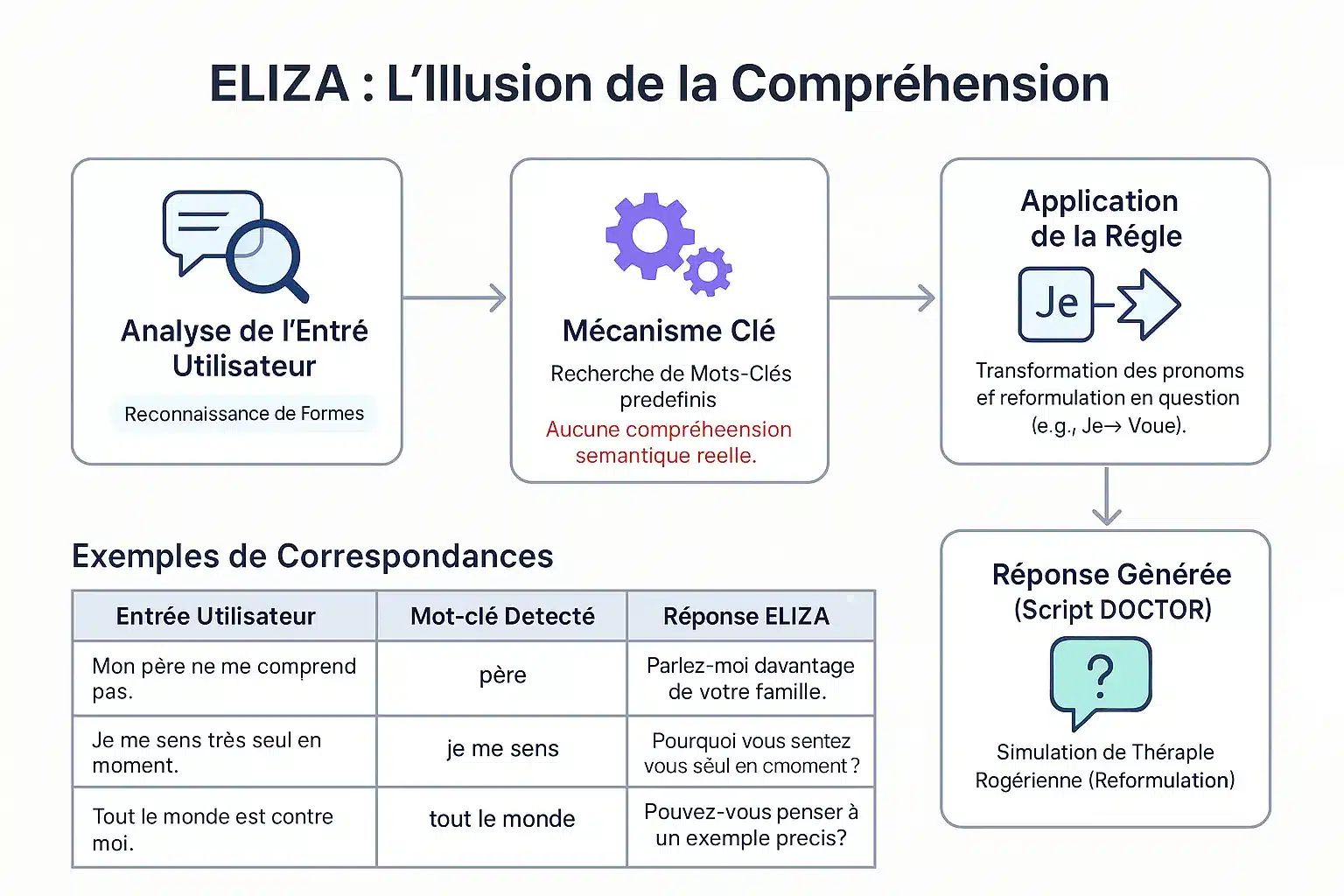

De patroonherkenningsmethode

ELIZA identificeert trefwoorden via een keystack. Afhankelijk van hun prioriteit worden zinnen afgebroken en opnieuw samengesteld. Voorbeeld: “Ik” → “jij” om te herformuleren in vragen. “Mijn vader begrijpt me niet” → “Praat over je familie.” Geen echt begrip: een patroonmechanisme simuleert empathisch luisteren.

Het beroemde “DOCTOR”-schrift en de Rogeriaanse therapie

Het DOCTOR-script, geïnspireerd door de Rogeriaanse therapie, weerspiegelt wat de patiënt zegt zonder advies. Voorbeeld: “Ik voel me eenzaam” → “Waarom eenzaam?”. Weizenbaum koos deze context om een externe basis te vermijden. Deze eenvoud onthulde de menselijke neiging om machines te antropomorfiseren. ELIZA legde de basis voor moderne chatbots. Een onderzoek uit 2023 toont aan dat het beter presteerde dan GPT-3.5 in een Turingtest, maar niet beter dan GPT-4 of mensen.

| Entry | Trefwoord | Reactie |

|---|---|---|

| Mijn vader begrijpt me niet. | vader | Praat over je familie. |

| Ik voel me eenzaam. | Ik voel | Waarom voel je je eenzaam? |

| Iedereen is tegen mij. | iedereen | Geef een specifiek voorbeeld. |

| Ik denk dat ik hulp nodig heb. | Ik denk | Denk je dat je hulp nodig hebt? |

Het ELIZA-effect: wanneer mensen intelligentie projecteren op machines

Definitie van een belangrijk psychologisch fenomeen

Het ELIZA-effect verwijst naar de neiging om menselijk begrip toe te schrijven aan door de computer gegenereerde symbolen. Een automaat die “DANK JE WEL” weergeeft wordt gezien als oprechte dankbaarheid, ondanks het feit dat hij voorgeprogrammeerd is.

Dit fenomeen werd al in 1966 waargenomen met ELIZA, de eerste chatbot van Joseph Weizenbaum aan het MIT, en toonde aan dat gebruikers emoties en begrip projecteerden op de eenvoudige antwoorden, ondanks de eenvoud. Het effect is het resultaat van cognitieve dissonantie.

Gebruikers zijn zich bewust van het mechanische programma, maar doen alsof ze het begrijpen. Deze illusie, na korte interacties, waarschuwt ons voor de grenzen van AI en het risico van overmoed.

Antropomorfisme en de reactie van Weizenbaum

Joseph Weizenbaum creëerde ELIZA in 1966 om de oppervlakkigheid van mens-machine-interactie aan te tonen. Hij was verbaasd dat gebruikers “waanideeën ” ontwikkelden na korte interacties. Zijn secretaresse weigerde hem hun uitwisselingen te laten observeren en deelde liever haar problemen met het programma.

Deze reactie bracht hem ertoe AI te bekritiseren, erop wijzend dat machines geen menselijk beoordelingsvermogen hebben. In ‘Computer Power and Human Reason’ beschreef hij het als obsceen om oordelen aan machines toe te vertrouwen, vooral op het gebied van psychologie of rechtspraak, omdat alleen mensen morele verantwoordelijkheid dragen. Zijn werk inspireert tot ethisch debat.

Het ELIZA-effect benadrukt onze neiging om machines te antropomorfiseren door ze een intelligentie en empathie toe te schrijven die ze niet bezitten, een fenomeen dat vandaag de dag nog steeds sterk aanwezig is.

De kenmerken van deze illusie

Deze manifestaties onthullen een cognitieve dissonantie tussen technische kennis en gebruikersgedrag. De belangrijkste zijn :

- Toekenning van bewustzijn of intentionaliteit, zelfs aan voorgeprogrammeerde reacties.

- Emoties projecteren op de antwoorden ondanks hun eenvoud.

- Persoonlijke informatie delen zonder voorbehoud, geloven in empathisch luisteren.

- Het gevoel te worden gehoord en begrepen door een machine.

Deze illusie wordt versterkt door interfaces die antropomorfisering aanmoedigen (namen, dialoog). Sommige mensen ontwikkelen emotionele banden of worden zelfs verliefd op chatbots en geloven in een echte relatie. We moeten onderscheid maken tussen zwakke AI (zonder geweten) en sterke AI. Professionals moeten transparantie bevorderen om misbruik te voorkomen.

ELIZA’s nalatenschap: een hoeksteen voor moderne AI

ELIZA, in 1966 gecreëerd door Joseph Weizenbaum, onthulde een fout in de perceptie van AI. De werking op basis van trefwoordherkenning illustreerde de grenzen van primitieve AI, een essentiële les voor financiële instellingen waar de transparantie van geautomatiseerde systemen klanten beschermt tegen verkeerde interpretaties.

De voorloper van conversationele AI

ELIZA werd in 1966 bij MIT ontwikkeld en simuleerde een psychotherapeut met behulp van een DOCTOR-script. Een zin als “Ik ben gestrest” werd bijvoorbeeld veranderd in “Waarom voel je je gestrest? Ondanks het gebrek aan echt begrip, hield het gebruikers voor de gek en creëerde het een illusie van menselijke dialoog.

Het ELIZA-effect toonde de menselijke neiging aan om machines te antropomorfiseren, een fenomeen dat nog steeds relevant is bij moderne virtuele assistenten. Deze voorloper van de Turingtest benadrukte de uitdagingen van conversatiesimulatie en inspireerde de chatbots van vandaag.

Technische beperkingen en waarschuwingen van de ontwerper

Het ontbrak ELIZA aan contextueel geheugen en betekenisbegrip. De antwoorden waren volledig afhankelijk van vooraf gedefinieerde regels. In zijn boek Computer Power and Human Reason benadrukte Weizenbaum het fundamentele onderscheid tussen mechanische berekening en menselijk beoordelingsvermogen.

Ondanks het revolutionaire karakter was ELIZA niet meer dan een intelligente spiegel van de woorden van de gebruiker, die zijn beperkingen ten opzichte van complexiteit onthulde en de kloof tussen simulatie en begrip benadrukte.

Deze kritiek blijft cruciaal voor de bank: bij het verstrekken van leningen of het opsporen van fraude moet AI altijd onder toezicht staan van menselijke experts om verkeerde beslissingen te voorkomen en juridische verantwoordelijkheid te behouden.

De wederopstanding van de originele code: een archeologische update

In 2021 werd de broncode van ELIZA gevonden in de archieven van MIT en gepubliceerd als open source. In 2024 restaureerde een team het programma op een IBM 7094 emulator, waarbij de originele interacties natuurgetrouw werden gereproduceerd.

Deze historische restauratie biedt een kijkje in de begindagen van conversationele AI. De code, die toegankelijk is in GNU Emacs, wordt gebruikt in universitaire curricula om de grondslagen van AI te onderwijzen en ontving in 2021 een Legacy Peabody Award.

Voor de financiële sectoren herinnert ELIZA ons eraan dat AI niet echt begrepen wordt. Duidelijke transparantie over de mogelijkheden beperkt de risico’s van overmatig delen van persoonlijke gegevens en versterkt het vertrouwen van klanten in digitale diensten.

ELIZA vandaag: een fundamentele les voor het AI-tijdperk

Meer dan een artefact: een tijdloze casestudy

ELIZA, in 1966 gemaakt door Joseph Weizenbaum aan het MIT, was een mijlpaal in de geschiedenis van AI. Deze chatbot gebruikte eenvoudige patronen en regels om een gesprek te simuleren. Het “DOCTOR”-script imiteerde een Rogeriaanse psychotherapeut en herformuleerde uitspraken in vragen. Hij begreep de taal echter niet, alleen de sleutelwoorden. Deze beperking was opzettelijk om de oppervlakkigheid van mens-machine interactie aan te tonen.

Toch ervoeren gebruikers vaak een menselijk begrip. Dit “ELIZA-effect” onthult onze neiging om machines te antropomorfiseren. Vandaag de dag, met het oog op LLM’s, is dit onderscheid tussen simulatie en authentieke intelligentie van vitaal belang. Financiële instellingen moeten onrealistische verwachtingen vermijden door de werkelijke capaciteiten van de tools te verduidelijken. Het negeren van deze les kan de geloofwaardigheid van digitale diensten en klantrelaties schaden.

Implicaties voor bedrijven en vertrouwensbeheer

In de bank- en verzekeringssector is het cruciaal om de verwachtingen van de klant te managen. Chatbots moeten transparant zijn over hun aard: ze begrijpen geen taal, maar simuleren alleen reacties. Teveel begrip of empathie verkopen kan leiden tot verlies van vertrouwen. Dankzij de technologische vooruitgang zijn de verschillende soorten kunstmatige intelligentie geëvolueerd, maar de psychologische problemen blijven bestaan.

- Definieer duidelijk de mogelijkheden en beperkingen van chatbots voor klanten.

- Overdrijf niet met de empathie of het begrip van geautomatiseerde agenten.

- Houd rekening met de psychologische impact van mens-machine-interactie bij het ontwerpen van klanttrajecten.

- Zorgen voor ethische verantwoordelijkheid bij de inzet van gesimuleerde technologieën.

Deze principes stellen ons in staat om duurzame klantrelaties op te bouwen op basis van transparantie en vertrouwen. In een sector waar vertrouwen essentieel is, is deze waakzaamheid essentieel om teleurstellingen te voorkomen en de reputatie hoog te houden.

ELIZA illustreert, ondanks zijn leeftijd, het essentiële punt: een simulatie is geen begrip. Voor banken en verzekeringsmaatschappijen is transparantie over de grenzen van chatbots cruciaal. Overschat hun empathie niet en respecteer tegelijkertijd de ethiek en het vertrouwen van de klant. Een tijdloze les in het licht van moderne AI.

FAQ

Wat is het ELIZA-effect en wat betekent het voor financiële instellingen?

Het ELIZA-effect verwijst naar de neiging van gebruikers om menselijk begrip en intelligentie toe te schrijven aan geautomatiseerde systemen, zelfs als ze deze capaciteiten niet bezitten. In de banksector kan dit effect leiden tot overmatig vertrouwen in chatbots, met het risico op misverstanden over hun werkelijke beperkingen. Instellingen moeten daarom systematisch de mogelijkheden en beperkingen van deze tools verduidelijken om de transparantie en veiligheid van klantinteracties te behouden.

Wat was de ELIZA chatbot en zijn historische rol?

ELIZA werd in 1966 gemaakt door Joseph Weizenbaum aan het MIT en wordt beschouwd als de eerste chatbot in de geschiedenis. Hij gebruikte een patroonmatchingmethode om antwoorden te genereren op basis van vooraf gedefinieerde regels. Hoewel ELIZA in eerste instantie was ontworpen om een Rogeriaanse therapie te simuleren, onthulde het de grenzen van machinebegrip en onderstreepte het het belang van transparantie in mens-machine-interactie, een belangrijk principe voor moderne bankdiensten.