Idea clave: Creada en 1966 por Joseph Weizenbaum en el MIT, ELIZA ilustró el efecto ELIZA: los humanos perciben inteligencia donde sólo hay simulación. Esta lección crucial para el sector bancario y de seguros exige una transparencia absoluta sobre los límites de los chatbots, evitando cualquier confusión sobre su capacidad para procesar datos sensibles o comprender contextos complejos.

Para las instituciones financieras, la confianza depende de una transparencia absoluta cuando se trata de tecnologías de IA. El chatbot eliza, el primer programa conversacional creado en 1966 en el MIT, reveló el efecto ELIZA: la tendencia humana a atribuir inteligencia real a sistemas incapaces de poseerla. Descubre cómo este estudio histórico guía el diseño ético de los chatbots de banca y seguros, alineando claramente las expectativas del cliente con las capacidades reales, previniendo los riesgos de desconfianza y garantizando el cumplimiento de las estrictas normas reguladoras y la ética profesional para una relación sostenible con el cliente.

Chatbot ELIZA: los orígenes de la inteligencia artificial conversacional

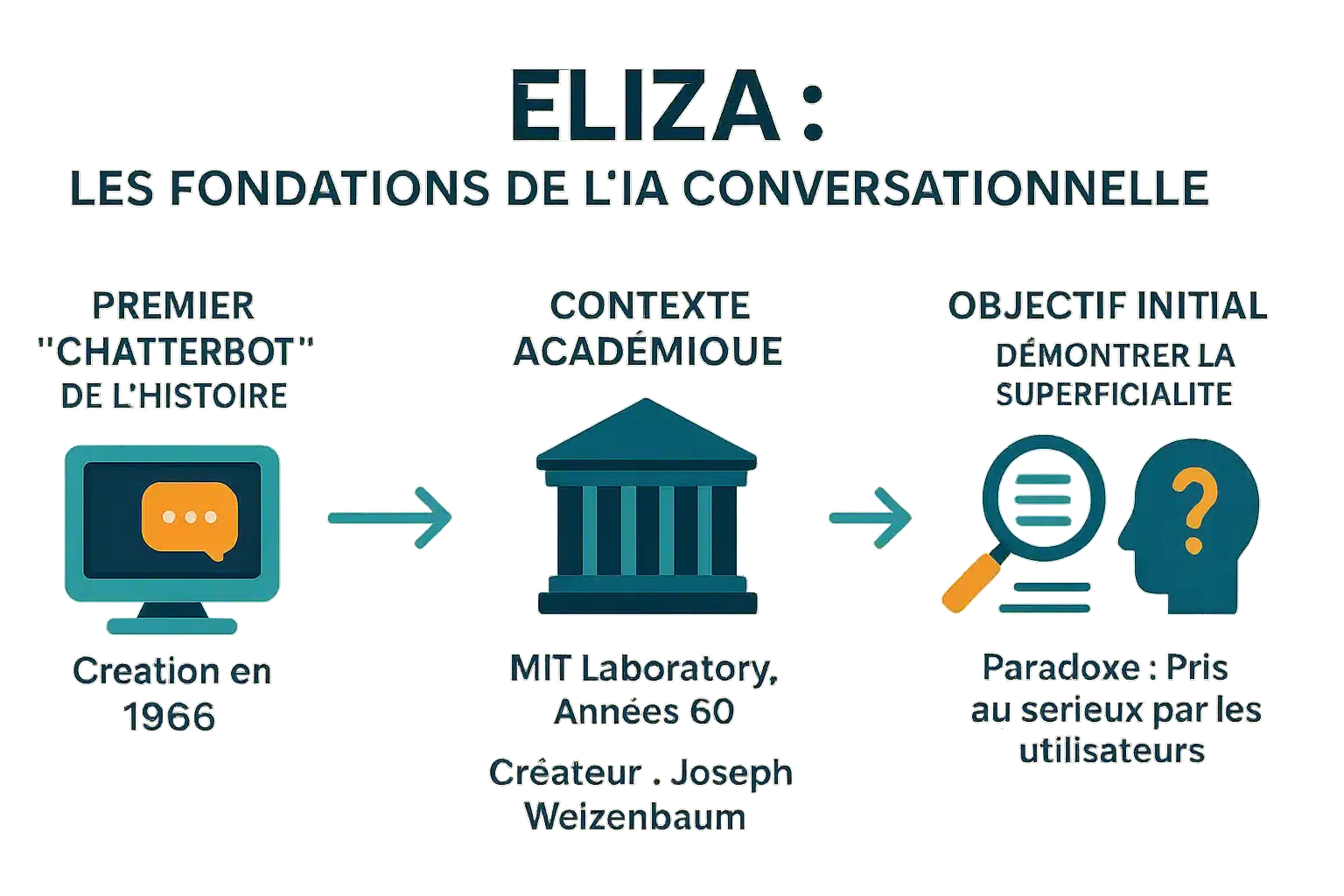

El primer «chatterbot» de la historia

Creada en 1966 por Joseph Weizenbaum en el MIT, ELIZA es el primer chatbot de la historia. Su nombre se inspiró en Eliza Doolittle («Pigmalión»), simbolizando la evolución a través de la interacción. Transformaba frases como «Tengo miedo» en «¿Por qué tienes miedo? mediante el reconocimiento y la sustitución de palabras clave. Este mecanismo, sin ninguna comprensión real, influyó en los asistentes modernos y demostró que incluso los programas sencillos podían engañar a los usuarios.

Un creador y un contexto: el MIT en los años 60

Desarrollado en el MIT entre 1964 y 1967, ELIZA utilizaba scripts MAD-SLIP y Lisp. El script DOCTOR simula a un psicoterapeuta rogeriano, reformulando lo que se dice sin ninguna base externa. Redescubierto en 2021 tras décadas perdido, su código fuente permite reconstruir conversaciones antiguas y estudiar las técnicas de la época.

El objetivo inicial: una demostración de superficialidad

El objetivo de Weizenbaum era demostrar la superficialidad de los intercambios entre humanos y máquinas. No buscaba una IA real, sino revelar cómo los humanos proyectan inteligencia en máquinas sencillas. Los usuarios, incluida su secretaria, compartían información personal, creyendo que hablaban con un humano. El efecto ELIZA, un importante fenómeno psicológico, subraya esta tendencia a la antropomorfización. En «El poder del ordenador y la razón humana», advirtió contra esta confusión. ELIZA sigue inspirando a los chatbots modernos. Un estudio reciente de 2023 demostró que superaba al GPT-3.5 en una prueba de Turing, sin superar al GPT-4 ni a los humanos.

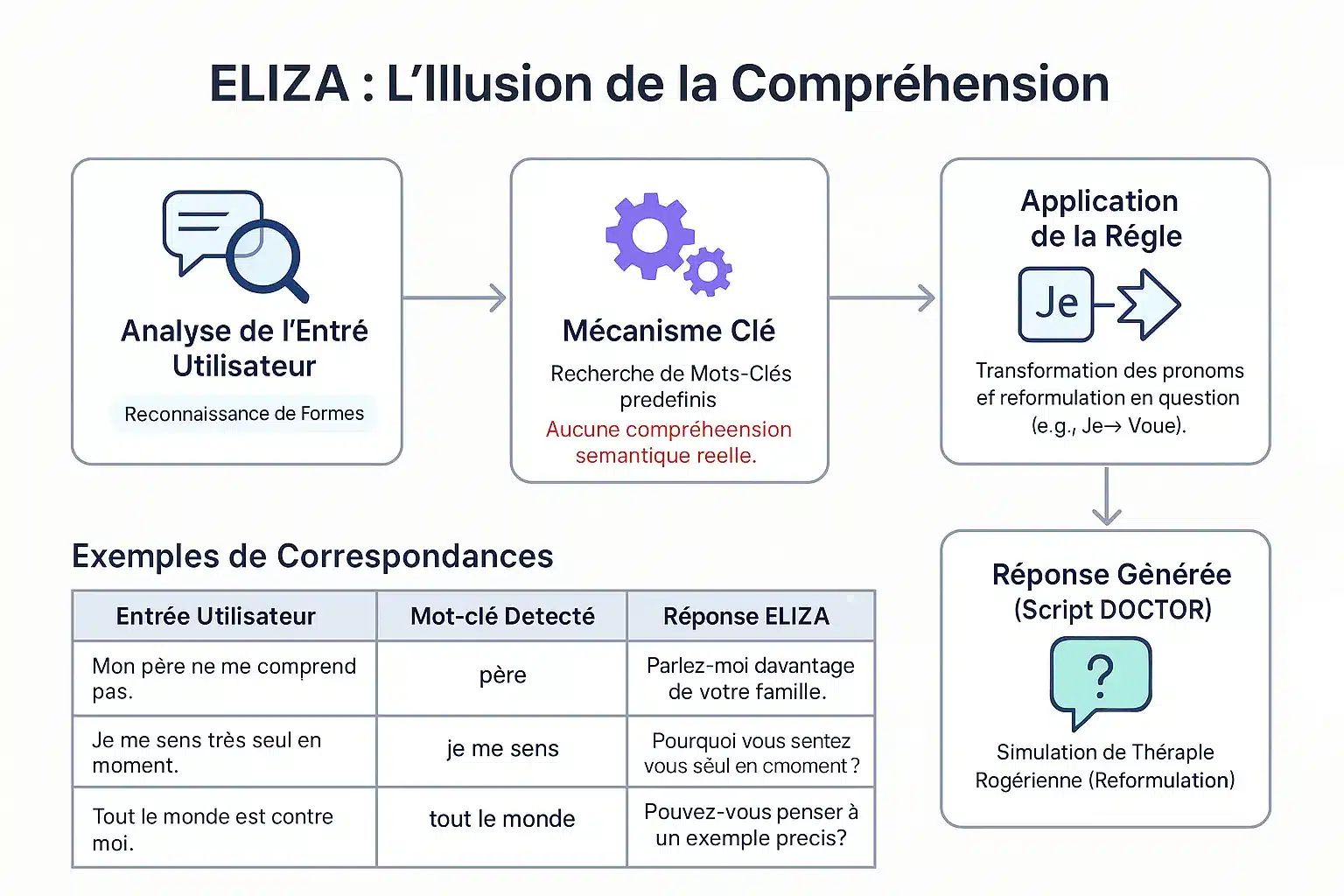

Cómo funciona ELIZA: una ilusión de comprensión

Creada en 1966 por Weizenbaum, ELIZA demostraba la superficialidad de los intercambios entre humanos y máquinas. A pesar de su simplicidad, provocó una reacción inesperada: los usuarios compartieron detalles personales, creyendo en una empatía genuina. Este «efecto ELIZA» llevó a Weizenbaum a advertir de los

El método de concordancia de patrones

ELIZA identifica las palabras clave mediante una pila de claves. En función de su prioridad, descompone y recompone las frases. Ejemplo: «Yo» → «tú» para reformular en preguntas. «Mi padre no me entiende» → «Háblame de tu familia». No hay comprensión real: un mecanismo de patrones simula la escucha empática.

El famoso guión «DOCTOR» y la terapia Rogeriana

El guión DOCTOR, inspirado en la terapia rogeriana, refleja lo que dice el paciente sin aconsejarle. Ejemplo: «Me siento solo» → «¿Por qué solo?». Weizenbaum eligió este contexto para evitar una base externa. Esta simplicidad revelaba la propensión humana a antropomorfizar las máquinas. ELIZA sentó las bases de los chatbots modernos. Un estudio de 2023 muestra que superó al GPT-3.5 en una prueba de Turing, pero no al GPT-4 ni a los humanos.

| Entrada | Palabra clave | Respuesta |

|---|---|---|

| Mi padre no me entiende. | padre | Habla de tu familia. |

| Me siento solo. | Me siento | ¿Por qué te sientes solo? |

| Todo el mundo está contra mí. | todo el mundo | Pon un ejemplo concreto. |

| Creo que necesito ayuda. | Creo que | ¿Crees que necesitas ayuda? |

El efecto ELIZA: cuando los humanos proyectan inteligencia en las máquinas

Definición de un fenómeno psicológico importante

El efecto ELIZA se refiere a la tendencia a atribuir comprensión humana a símbolos generados por ordenador. Un dispensador que muestra «GRACIAS» se percibe como gratitud genuina, a pesar de estar preprogramado.

Observado ya en 1966 con ELIZA, el primer chatbot de Joseph Weizenbaum en el MIT, este fenómeno demostró que los usuarios proyectaban emociones y comprensión en sus sencillas respuestas, a pesar de su simplicidad. El efecto es el resultado de la disonancia cognitiva.

Los usuarios son conscientes del programa mecánico, pero actúan como si lo entendieran. Esta ilusión, tras breves interacciones, nos alerta sobre los límites de la IA y el riesgo de un exceso de confianza.

El antropomorfismo y la reacción de Weizenbaum

Joseph Weizenbaum creó ELIZA en 1966 para demostrar la superficialidad de la interacción hombre-máquina. Le sorprendió que los usuarios desarrollaran

Esta reacción le llevó a criticar la IA, señalando que las máquinas carecen de juicio humano. En «El poder del ordenador y la razón humana», calificó de obsceno confiar juicios a las máquinas, sobre todo en psicología o justicia, porque sólo los seres humanos tienen responsabilidad moral. Su obra inspira el debate ético.

El efecto ELIZA pone de manifiesto nuestra tendencia a antropomorfizar las máquinas, atribuyéndoles una inteligencia y una empatía que no poseen, un fenómeno que sigue muy presente hoy en día.

Las características de esta ilusión

Estas manifestaciones revelan una disonancia cognitiva entre los conocimientos técnicos y el comportamiento de los usuarios. Las principales son :

- Atribución de conciencia o intencionalidad incluso a las respuestas preprogramadas.

- Proyectar emociones en las respuestas a pesar de su simplicidad.

- Compartir información personal sin reservas, creer en la escucha empática.

- La sensación de ser escuchado y comprendido por una máquina.

Esta ilusión se ve reforzada por interfaces que fomentan la antropomorfización (nombres, diálogo). Algunas personas desarrollan vínculos emocionales, o incluso se enamoran de los chatbots, creyendo en una relación real. Hay que distinguir entre la IA débil (sin conciencia) y la IA fuerte. Los profesionales deben fomentar la transparencia para evitar abusos.

El legado de ELIZA: una piedra angular para la IA moderna

ELIZA, creada en 1966 por Joseph Weizenbaum, reveló un fallo en la percepción de la IA. Su funcionamiento basado en el reconocimiento de palabras clave ilustró los límites de la IA primitiva, una lección esencial para las instituciones financieras en las que la transparencia de los sistemas automatizados protege a los clientes contra interpretaciones erróneas.

El precursor de la IA conversacional

Desarrollada en el MIT en 1966, ELIZA simulaba a un psicoterapeuta utilizando un guión DOCTOR. Por ejemplo, una frase como «Estoy estresado» se transformaba en «¿Por qué te sientes estresado? A pesar de su falta de comprensión real, engañaba a los usuarios, creando una ilusión de diálogo humano.

El efecto ELIZA demostró la propensión humana a antropomorfizar las máquinas, un fenómeno que sigue siendo relevante con los asistentes virtuales modernos. Este precursor del test de Turing puso de manifiesto los retos de la simulación conversacional, al tiempo que inspiró los chatbots actuales.

Limitaciones técnicas y advertencias del diseñador

ELIZA carecía de memoria contextual y de comprensión del significado. Sus respuestas dependían totalmente de reglas predefinidas. En su libro Computer Power and Human Reason, Weizenbaum subrayó la distinción fundamental entre el cálculo mecánico y el juicio humano.

A pesar de su carácter revolucionario, ELIZA no era más que un espejo inteligente de las palabras del usuario, que revelaba sus limitaciones ante la complejidad y ponía de manifiesto el abismo existente entre la simulación y la comprensión.

Esta crítica sigue siendo crucial para el banco: en la concesión de préstamos o la detección de fraudes, la IA debe estar siempre supervisada por expertos humanos para evitar decisiones erróneas y mantener la responsabilidad legal.

La resurrección del código original: una actualización arqueológica

En 2021, se encontró el código fuente de ELIZA en los archivos del MIT y se publicó como código abierto. En 2024, un equipo lo restauró en un emulador IBM 7094, reproduciendo fielmente las interacciones originales.

Esta restauración histórica ofrece una visión de los primeros días de la IA conversacional. El código, accesible en GNU Emacs, se utiliza en los planes de estudios universitarios para enseñar los fundamentos de la IA y recibió un Premio Legacy Peabody en 2021.

Para los sectores financieros, ELIZA nos recuerda que la IA carece de comprensión real. Una transparencia clara sobre sus capacidades limita los riesgos de compartir excesivamente los datos personales y refuerza la confianza de los clientes en los servicios digitales.

ELIZA hoy: una lección fundamental para la era de la IA

Más que un artefacto: un estudio de caso intemporal

ELIZA, creada en 1966 por Joseph Weizenbaum en el MIT, fue un hito en la historia de la IA. Este chatbot utilizaba patrones y reglas simples para simular una conversación. El script «DOCTOR» imitaba a un psicoterapeuta rogeriano, reformulando enunciados en preguntas. Sin embargo,

Sin embargo, los usuarios a menudo percibían una comprensión humana. Este «efecto ELIZA» revela nuestra tendencia a antropomorfizar las máquinas. Hoy, ante los LLM, esta distinción entre simulación e inteligencia auténtica es vital. Las instituciones financieras deben

Implicaciones para las empresas y la gestión de la confianza

En los sectores de la banca y los seguros, gestionar las expectativas de los clientes es crucial. Los chatbots deben ser transparentes sobre su naturaleza: no entienden el lenguaje, sólo simulan respuestas.

- Define claramente las capacidades y limitaciones de los chatbots para los clientes.

- Evita exagerar la empatía o comprensión de los agentes automatizados.

- Ten en cuenta el impacto psicológico de la interacción hombre-máquina al diseñar los recorridos del cliente.

- Garantizar la responsabilidad ética en el despliegue de tecnologías simuladas.

Estos principios nos permiten construir relaciones duraderas con los clientes, basadas en la transparencia y la confianza. En un sector en el que la confianza es esencial, esta vigilancia es fundamental para evitar decepciones y mantener la reputación.

ELIZA, a pesar de su antigüedad, ilustra lo esencial: una simulación no es comprensión. Para los bancos y las compañías de seguros,

PREGUNTAS FRECUENTES

¿Qué es el efecto ELIZA y qué significa para las instituciones financieras?

El efecto ELIZA se refiere a la tendencia de los usuarios a atribuir comprensión e inteligencia humanas a los sistemas automatizados, incluso cuando no poseen estas capacidades. En el sector bancario, este efecto puede llevar a una confianza excesiva en los chatbots, con el riesgo de malentendidos sobre sus limitaciones reales. Por tanto, las instituciones deben aclarar sistemáticamente las capacidades y restricciones de estas herramientas para preservar la transparencia y la seguridad de las interacciones con los clientes.

¿Qué era el chatbot ELIZA y su papel histórico?

Creado en 1966 por Joseph Weizenbaum en el MIT, ELIZA está considerado el primer chatbot de la historia. Utilizaba un método de concordancia de patrones para generar respuestas basadas en reglas predefinidas. Aunque inicialmente se diseñó para simular una terapia rogeriana, ELIZA reveló los límites de la comprensión de las máquinas, subrayando la importancia de la transparencia en la interacción hombre-máquina, un principio clave para los servicios bancarios modernos.