Das Wichtigste in Kürze: ELIZA wurde 1966 von Joseph Weizenbaum am MIT entwickelt und veranschaulichte den ELIZA-Effekt: Menschen nehmen Intelligenz wahr, wo es sich nur um eine Simulation handelt. Diese wichtige Lektion für den Banken- und Versicherungssektor erfordert absolute Transparenz über die Grenzen von Chatbots, um jegliche Verwirrung über ihre Fähigkeit, sensible Daten zu verarbeiten oder komplexe Zusammenhänge zu verstehen, zu vermeiden.

Für Finanzinstitute hängt das Vertrauen von der absoluten Transparenz gegenüber KI-Technologien ab. Der Eliza-Chatbot, das erste 1966 am MIT entwickelte Chatprogramm, offenbarte den ELIZA-Effekt: eine menschliche Neigung, Systemen echte Intelligenz zuzuschreiben, die diese nicht besitzen. Erfahren Sie, wie diese historische Studie das ethische Design von Bank- und Versicherungs-Chatbots leitet, indem sie die Erwartungen der Kunden klar mit den tatsächlichen Fähigkeiten in Einklang bringt, Misstrauensrisiken verhindert und die Einhaltung strenger regulatorischer Standards und der Berufsethik für eine nachhaltige Kundenbeziehung sicherstellt.

ELIZA Chatbot: Die Ursprünge der konversationellen künstlichen Intelligenz

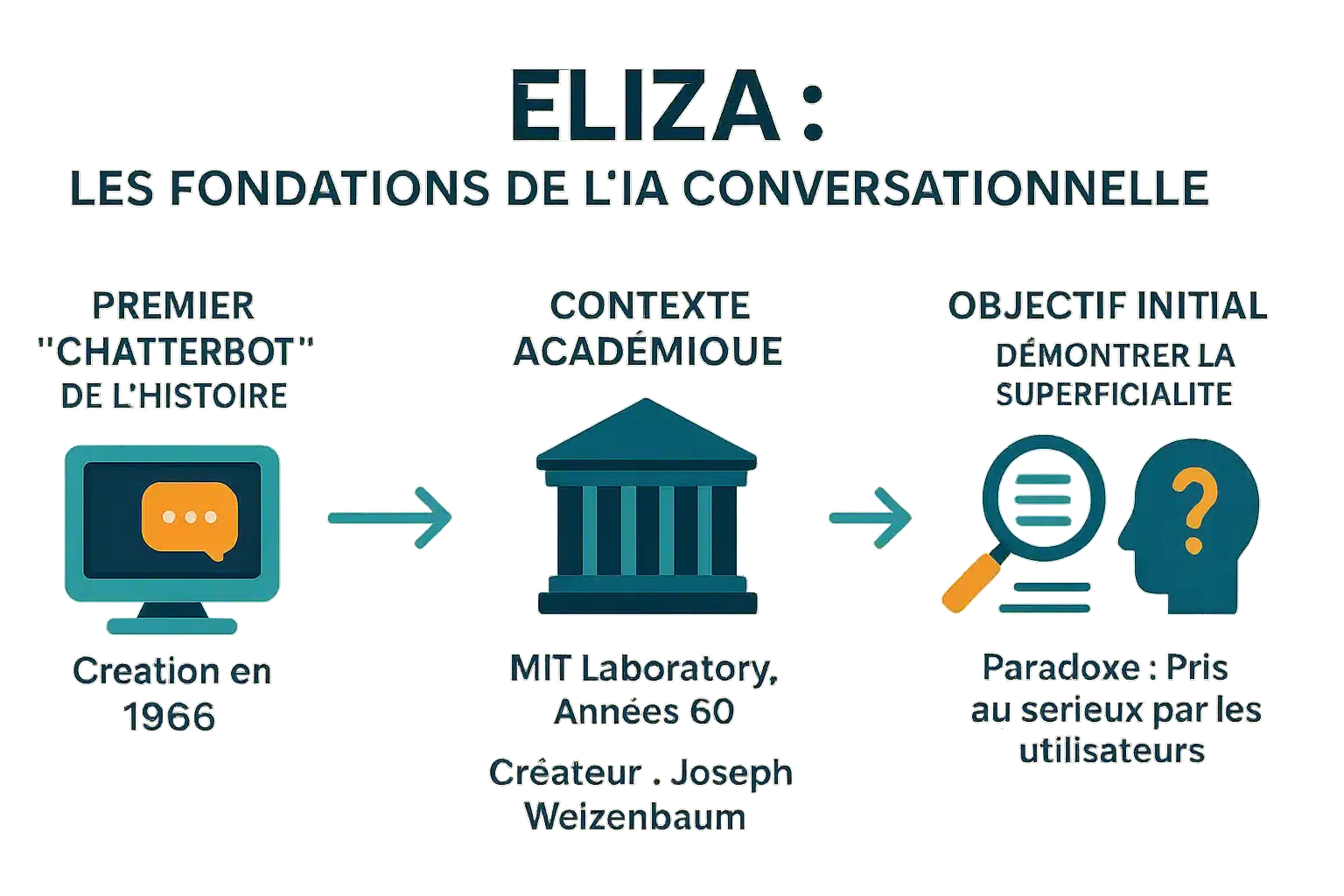

Der erste „Chatbot“ der Geschichte

ELIZA wurde 1966 von Joseph Weizenbaum am MIT entwickelt und ist der erste historische Chatbot. Sein Name ist inspiriert von Eliza Doolittle (‚Pygmalion‘), die die Evolution durch Interaktion symbolisiert. Er verwandelte Sätze wie ‚Ich habe Angst‘ in ‚Warum haben Sie Angst?‘ durch Schlüsselworterkennung und Substitution. Dieser Mechanismus, der nicht wirklich verstanden wurde, beeinflusste die modernen Assistenten und zeigte gleichzeitig , dass selbst einfache Programme den Benutzer täuschen können.

Ein Schöpfer und ein Kontext: das MIT in den 1960er Jahren

ELIZA wurde zwischen 1964-1967 am MIT entwickelt und verwendete MAD-SLIP und Lisp-Skripte. Das DOCTOR-Skript simuliert einen rogerianischen Psychotherapeuten, der die Aussagen ohne externe Grundlage umformuliert. Der Quellcode wurde 2021 nach jahrzehntelanger Verschollenheit wiedergefunden und ermöglicht es, alte Gespräche zu rekonstruieren und die damaligen Techniken zu studieren.

Das ursprüngliche Ziel: eine Demonstration von Oberflächlichkeit

Weizenbaum wollte die Oberflächlichkeit des Austauschs zwischen Mensch und Maschine demonstrieren. Er suchte nicht nach einer echten KI, sondern wollte aufdecken , wie Menschen Intelligenz auf einfache Maschinen projizieren. Nutzer, einschließlich seiner Sekretärin, tauschten persönliche Informationen aus und glaubten, mit einem Menschen zu sprechen. Der ELIZA-Effekt, ein wichtiges psychologisches Phänomen, unterstreicht diese Tendenz zur Anthropomorphisierung. In ‚Computer Power and Human Reason‘ warnte er vor dieser Verwirrung. ELIZA inspiriert immer noch moderne Chatbots. Eine aktuelle Studie aus dem Jahr 2023 zeigt, dass sie GPT-3.5 in einem Turing-Test übertraf, ohne GPT-4 oder Menschen zu übertreffen.

Die Funktionsweise von ELIZA: Eine Illusion von Verständnis

ELIZA wurde 1966 von Weizenbaum entwickelt und zeigte die Oberflächlichkeit der Kommunikation zwischen Mensch und Maschine. Trotz seiner Einfachheit löste es eine unerwartete Reaktion aus: Nutzer teilten persönliche Details mit und glaubten, dass es sich um echte Empathie handelte. Dieser „ELIZA-Effekt“ veranlasste Weizenbaum dazu, in „Computer Power and Human Reason“ vor den

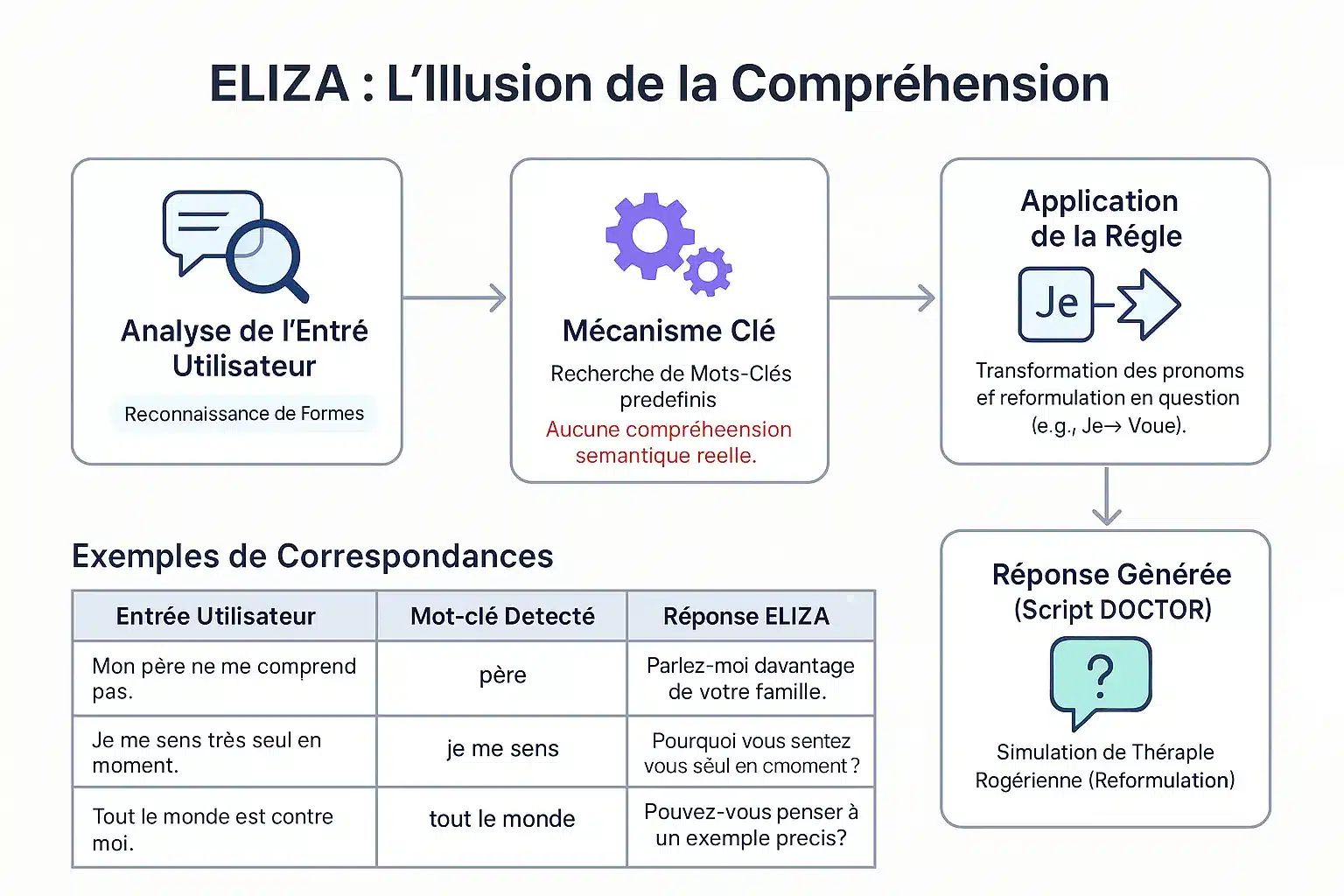

Die Methode der Mustererkennung (pattern matching)

ELIZA identifiziert Schlüsselwörter über einen „Keystack“. Entsprechend ihrer Priorität zerlegt sie Sätze und setzt sie neu zusammen. Beispiel: „Ich“ → „Sie“, um in Fragen umzuformulieren. „Mein Vater versteht mich nicht“ → „Sprechen Sie über Ihre Familie“. Kein wirkliches Verständnis: Ein Mustermechanismus simuliert empathisches Zuhören.

Das berühmte Skript „DOCTOR“ und die Rogers-Therapie

Das DOCTOR-Skript, das von der Rogerianischen Therapie inspiriert ist, spiegelt die Aussagen des Patienten ohne Ratschläge wider. Beispiel: „Ich fühle mich einsam“ → „Warum einsam?“. Weizenbaum wählte diesen Kontext, um eine externe Basis zu vermeiden. Diese Einfachheit offenbarte die menschliche Neigung, Maschinen zu anthropomorphisieren. ELIZA legte den Grundstein für moderne Chatbots. Eine Studie aus dem Jahr 2023 zeigt, dass er GPT-3.5 in einem Turing-Test übertraf, aber nicht GPT-4 oder Menschen.

| Eintrag | Stichwort | Antwort |

|---|---|---|

| Mein Vater versteht mich nicht. | Vater | Sprechen Sie über Ihre Familie. |

| Ich fühle mich einsam. | Ich fühle mich | Warum einsam? |

| Alle sind gegen mich. | alle | Geben Sie ein konkretes Beispiel. |

| Ich glaube, ich brauche Hilfe. | Ich glaube, dass ich | Glauben Sie, dass Sie Hilfe benötigen? |

Der ELIZA-Effekt: Wenn der Mensch Intelligenz auf die Maschine projiziert

Definition eines bedeutenden psychologischen Phänomens

Der ELIZA-Effekt bezeichnet die Tendenz, computergenerierten Symbolen ein menschliches Verständnis zuzuschreiben. Ein Automat, der „DANKE“ anzeigt, wird als echte Dankbarkeit wahrgenommen, obwohl er vorprogrammiert ist.

Dieses Phänomen wurde bereits 1966 bei ELIZA, dem ersten Chatbot von Joseph Weizenbaum am MIT, beobachtet und zeigt, dass die Nutzer trotz der Einfachheit der Antworten Emotionen und Verständnis auf die einfachen Antworten projizierten. Dieser Effekt ist das Ergebnis von kognitiver Dissonanz.

Die Nutzer kennen das mechanische Programm, verhalten sich aber so, als ob sie es verstehen würden. Diese Illusion nach kurzen Interaktionen warnt vor den Grenzen der KI und dem Risiko eines übermäßigen Vertrauens.

Anthropomorphismus und die Reaktion von Weizenbaum

Joseph Weizenbaum gründete ELIZA 1966, um die Oberflächlichkeit der Interaktion zwischen Mensch und Maschine zu demonstrieren. Er war überrascht, dass Nutzer nach kurzen Interaktionen “

Diese Reaktion veranlasste ihn dazu, die KI zu kritisieren, indem er betonte, dass es Maschinen an menschlichem Urteilsvermögen mangelt. In ‚Computer Power and Human Reason‘ bezeichnete er es als obszön, Maschinen Urteile zu überlassen, insbesondere in der Psychologie und der Justiz, da nur Menschen moralische Verantwortung tragen. Sein Werk inspiriert ethische Debatten.

Der ELIZA-Effekt verdeutlicht unsere Neigung, Maschinen zu vermenschlichen, indem wir ihnen Intelligenz und Empathie zuschreiben, die sie nicht besitzen – ein Phänomen, das immer noch aktuell ist.

Die Merkmale dieser Illusion

Diese Manifestationen zeigen eine kognitive Dissonanz zwischen technischem Wissen und Nutzerverhalten. Die wichtigsten sind :

- Zuschreibung von Bewusstsein oder Absichtlichkeit auch bei vorprogrammierten Antworten.

- Projektion von Emotionen auf die Antworten trotz ihrer Einfachheit.

- Vorbehaltlose Weitergabe persönlicher Informationen im Glauben an ein einfühlsames Zuhören.

- Das Gefühl, von einer Maschine gehört und verstanden zu werden.

Diese Illusion wird durch Schnittstellen verstärkt, die die Anthropomorphisierung fördern (Namen, Dialoge). Manche Menschen entwickeln emotionale Bindungen oder verlieben sich sogar in Chatbots, weil sie glauben, dass es sich um eine echte Beziehung handelt. Es muss zwischen schwacher KI (ohne Bewusstsein) und starker KI unterschieden werden. Fachleute müssen Transparenz fördern, um Fehlentwicklungen zu vermeiden.

Das Erbe von ELIZA: ein Grundstein für moderne KI

ELIZA, 1966 von Joseph Weizenbaum entwickelt, offenbarte einen Fehler in der Wahrnehmung der KI. Dies ist eine wichtige Lektion für Finanzinstitute, wo die Transparenz automatisierter Systeme die Kunden vor Fehlinterpretationen schützt.

Der Vorreiter der konversationellen KI

ELIZA wurde 1966 am MIT entwickelt und simulierte einen Psychotherapeuten mit Hilfe eines DOCTOR-Skripts. Beispielsweise wurde ein Satz wie „Ich bin gestresst“ in „Warum fühlen Sie sich gestresst?“ umgewandelt. Trotz des Mangels an echtem Verständnis täuschte es die Nutzer, indem es die Illusion eines menschlichen Dialogs erzeugte.

Der ELIZA-Effekt demonstrierte die menschliche Neigung, Maschinen zu vermenschlichen, ein Phänomen, das auch bei modernen virtuellen Assistenten noch relevant ist. Dieser Vorläufer des Turing-Tests zeigte die Herausforderungen der Konversationssimulation auf und inspirierte die heutigen Chatbots.

Technische Einschränkungen und Warnungen des Schöpfers

ELIZA fehlte es an einem kontextuellen Gedächtnis und einem Verständnis der Bedeutung. Ihre Antworten waren vollständig von vordefinierten Regeln abhängig. In seinem Buch Computer Power and Human Reason betonte Weizenbaum die grundlegende Unterscheidung zwischen mechanischer Berechnung und menschlichem Urteilsvermögen.

Trotz seines revolutionären Charakters war ELIZA nur ein intelligenter Spiegel der Worte des Nutzers, der seine Grenzen angesichts der Komplexität aufzeigte und die Kluft zwischen Simulation und Verständnis verdeutlichte.

Dieser Kritikpunkt bleibt für die Bank entscheidend: Bei der Kreditvergabe oder der Betrugserkennung muss eine KI immer von menschlichen Experten beaufsichtigt werden, um Fehlentscheidungen zu vermeiden und die rechtliche Haftung aufrechtzuerhalten.

Die Wiederauferstehung des Originalcodes: eine archäologische Aktualität

Im Jahr 2021 wurde der Quellcode von ELIZA in den Archiven des MIT gefunden und als Open Source veröffentlicht. Im Jahr 2024 stellte ein Team das Spiel auf einem IBM 7094 Emulator wieder her und reproduzierte die ursprünglichen Interaktionen.

Diese historische Restaurierung bietet einen Einblick in die Anfänge der konversationellen KI. Der Code, der in GNU Emacs zugänglich ist, wird in akademischen Lehrplänen verwendet, um die Grundlagen der KI zu lehren und wurde 2021 mit dem Legacy Peabody Award ausgezeichnet.

Für den Finanzsektor erinnert ELIZA daran, dass es der KI an echtem Verständnis mangelt. Eine klare Transparenz über ihre Fähigkeiten verringert das Risiko einer übermäßigen Weitergabe persönlicher Daten und stärkt das Vertrauen der Kunden in digitale Dienstleistungen.

ELIZA heute: Eine grundlegende Lektion für das Zeitalter der KI

Mehr als ein Artefakt: eine zeitlose Fallstudie

ELIZA wurde 1966 von Joseph Weizenbaum am MIT entwickelt und stellte einen Meilenstein in der Geschichte der KI dar. Dieser Chatbot verwendete einfache Muster und Regeln, um ein Gespräch zu simulieren. Das Skript „DOCTOR“ imitierte einen rogerianischen Psychotherapeuten, der Aussagen in Fragen umformulierte. Er

Dennoch nahmen die Nutzer oftmals ein menschliches Verständnis wahr. Dieser „ELIZA-Effekt“ zeigt unsere Tendenz, Maschinen zu anthropomorphisieren. Heute, angesichts der LLMs, ist diese Unterscheidung zwischen Simulation und echter Intelligenz von entscheidender Bedeutung. Finanzinstitute müssen unrealistische Erwartungen vermeiden, indem sie die tatsächlichen Fähigkeiten der Werkzeuge klarstellen. Diese Lektion zu ignorieren, kann die Glaubwürdigkeit digitaler Dienstleistungen und die Kundenbeziehung beeinträchtigen.

Implikationen für Unternehmen und Vertrauensmanagement

Im Banken- und Versicherungssektor ist das Management der Kundenerwartungen von entscheidender Bedeutung. Chatbots müssen über ihre Natur transparent sein: Sie verstehen keine Sprache, sondern simulieren nur Antworten. Ein Überangebot an Verständnis oder Empathie kann zu einem Vertrauensverlust führen. Der technologische Fortschritt hat die verschiedenen Arten von künstlicher Intelligenz weiterentwickelt, aber die psychologischen Fragen bleiben bestehen.

- Die Möglichkeiten und Grenzen von Chatbots für Kunden klar definieren.

- Vermeiden Sie es, die Empathie oder das Verständnis von automatisierten Agenten überzuverkaufen.

- Berücksichtigung der psychologischen Auswirkungen der Interaktion zwischen Mensch und Maschine bei der Gestaltung der Kundenreise.

- Sicherstellung der ethischen Verantwortung beim Einsatz simulierter Technologien.

Diese Prinzipien ermöglichen den Aufbau einer dauerhaften Kundenbeziehung, die auf Transparenz und Vertrauen beruht. In einem Sektor, in dem Vertrauen von entscheidender Bedeutung ist, ist diese Wachsamkeit unerlässlich, um Enttäuschungen vorzubeugen und den guten Ruf zu erhalten.

ELIZA zeigt trotz ihres Alters das Wesentliche: eine Simulation ist kein Verständnis. Für Banken und Versicherungen ist die Transparenz über die Grenzen von Chatbots entscheidend. Vermeiden Sie eine Überbewertung ihrer Empathie und respektieren Sie gleichzeitig

FAQ

Was ist der ELIZA-Effekt und seine Auswirkungen auf Finanzinstitute?

Der ELIZA-Effekt bezeichnet die Tendenz der Nutzer, automatisierten Systemen menschliches Verständnis und Intelligenz zuzuschreiben, selbst wenn diese diese Fähigkeiten nicht besitzen. Im Bankensektor kann dieser Effekt zu einem übermäßigen Vertrauen in Chatbots führen, was zu Missverständnissen über deren tatsächliche Grenzen führen kann. Die Institutionen müssen daher systematisch die Fähigkeiten und Beschränkungen dieser Tools klären, um die Transparenz und Sicherheit der Kundeninteraktionen zu gewährleisten.

Was war der Chatbot ELIZA und seine historische Rolle?

ELIZA wurde 1966 von Joseph Weizenbaum am MIT entwickelt und gilt als der erste Chatbot der Geschichte. Er funktionierte auf der Grundlage einer Pattern-Matching-Methode, die Antworten auf der Grundlage von vordefinierten Regeln generierte. Obwohl ELIZA ursprünglich zur Simulation einer Rogers-Therapie entwickelt wurde, zeigte es die Grenzen des maschinellen Verständnisses auf und unterstrich die Bedeutung von Transparenz in der Mensch-Maschine-Interaktion, einem Schlüsselprinzip für moderne Bankdienstleistungen.