Conclusão principal: Criado em 1966 por Joseph Weizenbaum no MIT, o ELIZA ilustrou o efeito ELIZA: os humanos percebem inteligência onde há apenas simulação. Essa lição crucial para o setor bancário e de seguros exige transparência absoluta sobre os limites dos chatbots, evitando qualquer confusão sobre sua capacidade de processar dados confidenciais ou entender contextos complexos.

Para as instituições financeiras, a confiança depende da transparência absoluta quando se trata de tecnologias de IA. O chatbot eliza, o primeiro programa de conversação criado em 1966 no MIT, revelou o efeito ELIZA: uma tendência humana de atribuir inteligência real a sistemas incapazes de possuí-la. Descubra como esse estudo de referência orienta o design ético de chatbots de bancos e seguradoras, alinhando claramente as expectativas dos clientes com as capacidades reais, evitando riscos de desconfiança e garantindo a conformidade com padrões regulatórios rigorosos e ética profissional para um relacionamento sustentável com o cliente.

Chatbot ELIZA: as origens da inteligência artificial de conversação

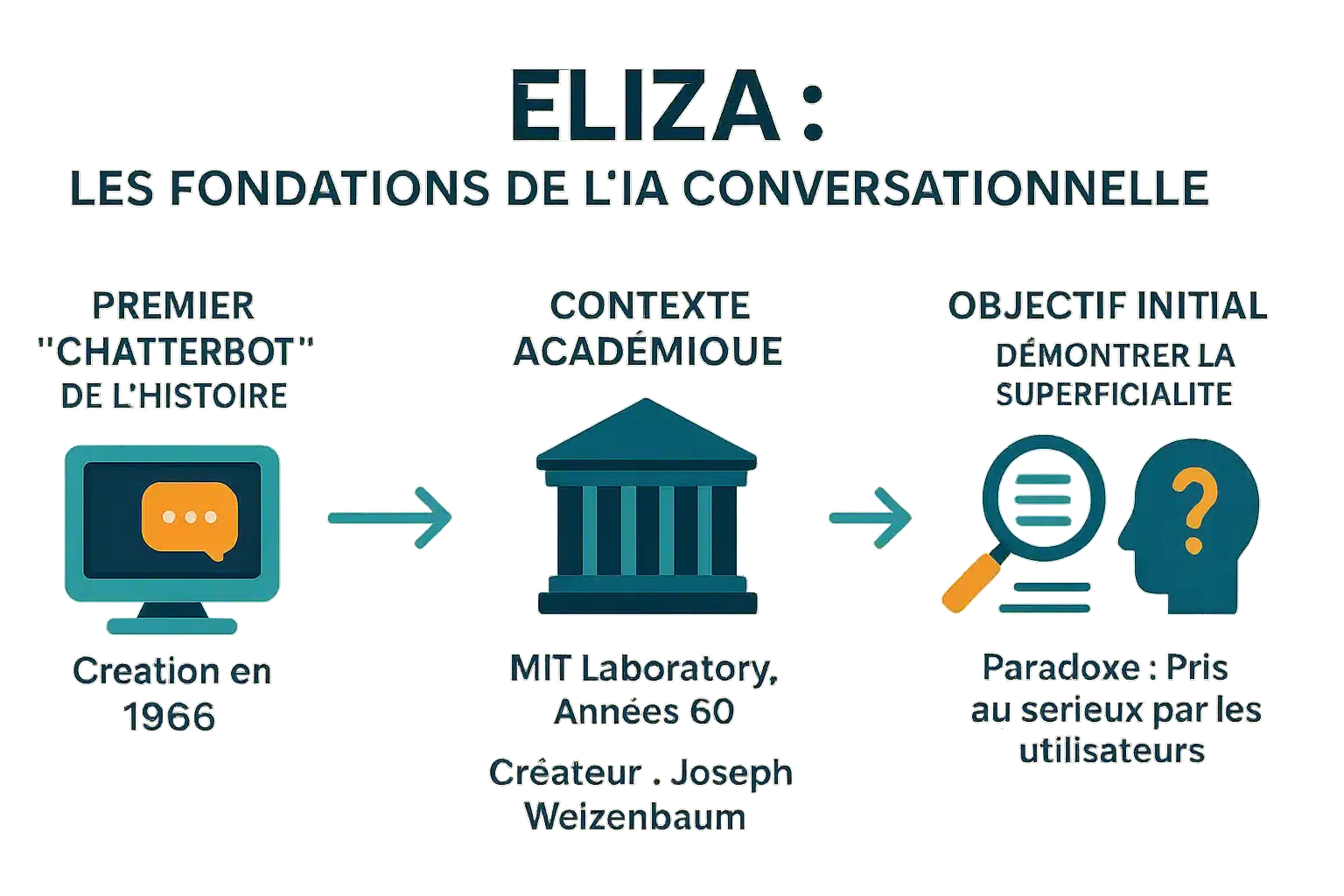

O primeiro “chatterbot” da história

Criada em 1966 por Joseph Weizenbaum no MIT, ELIZA é o primeiro chatbot da história. Seu nome foi inspirado em Eliza Doolittle (“Pygmalion”), simbolizando a evolução por meio da interação. Ela transformou frases como “Estou com medo” em “Por que você está com medo?” por meio do reconhecimento e da substituição de palavras-chave. Esse mecanismo, sem nenhuma compreensão real, influenciou os assistentes modernos e demonstrou que até mesmo programas simples poderiam enganar os usuários.

Um criador e um contexto: o MIT na década de 1960

Desenvolvido no MIT entre 1964 e 1967, o ELIZA usava MAD-SLIP e scripts Lisp. O script DOCTOR simula um psicoterapeuta Rogeriano, reformulando o que é dito sem qualquer base externa. Redescoberto em 2021 após ficar perdido por décadas, seu código-fonte permite reconstruir conversas antigas e estudar as técnicas da época.

O objetivo inicial: uma demonstração de superficialidade

O objetivo de Weizenbaum era demonstrar a superficialidade das trocas entre homem e máquina. Ele não estava procurando uma IA real, mas revelar como os humanos projetam inteligência em máquinas simples. Os usuários, inclusive sua secretária, compartilhavam informações pessoais, acreditando que estavam conversando com um ser humano. O efeito ELIZA, um importante fenômeno psicológico, destaca essa tendência de antropomorfização. Em ‘Computer Power and Human Reason’, ele alertou contra essa confusão. O ELIZA ainda inspira os chatbots modernos. Um estudo recente em 2023 mostrou que ele superou o GPT-3.5 em um teste de Turing, sem superar o GPT-4 ou os humanos.

Como o ELIZA funciona: uma ilusão de compreensão

Criado em 1966 por Weizenbaum, o ELIZA demonstrou a superficialidade das trocas entre homem e máquina. Apesar de sua simplicidade, ele provocou uma reação inesperada: os usuários compartilharam detalhes pessoais, acreditando em empatia genuína. Esse “efeito ELIZA” levou Weizenbaum a alertar sobre os riscos antropomórficos em “Computer Power and Human Reason”. Seu código, redescoberto em 2021, está no GNU Emacs.

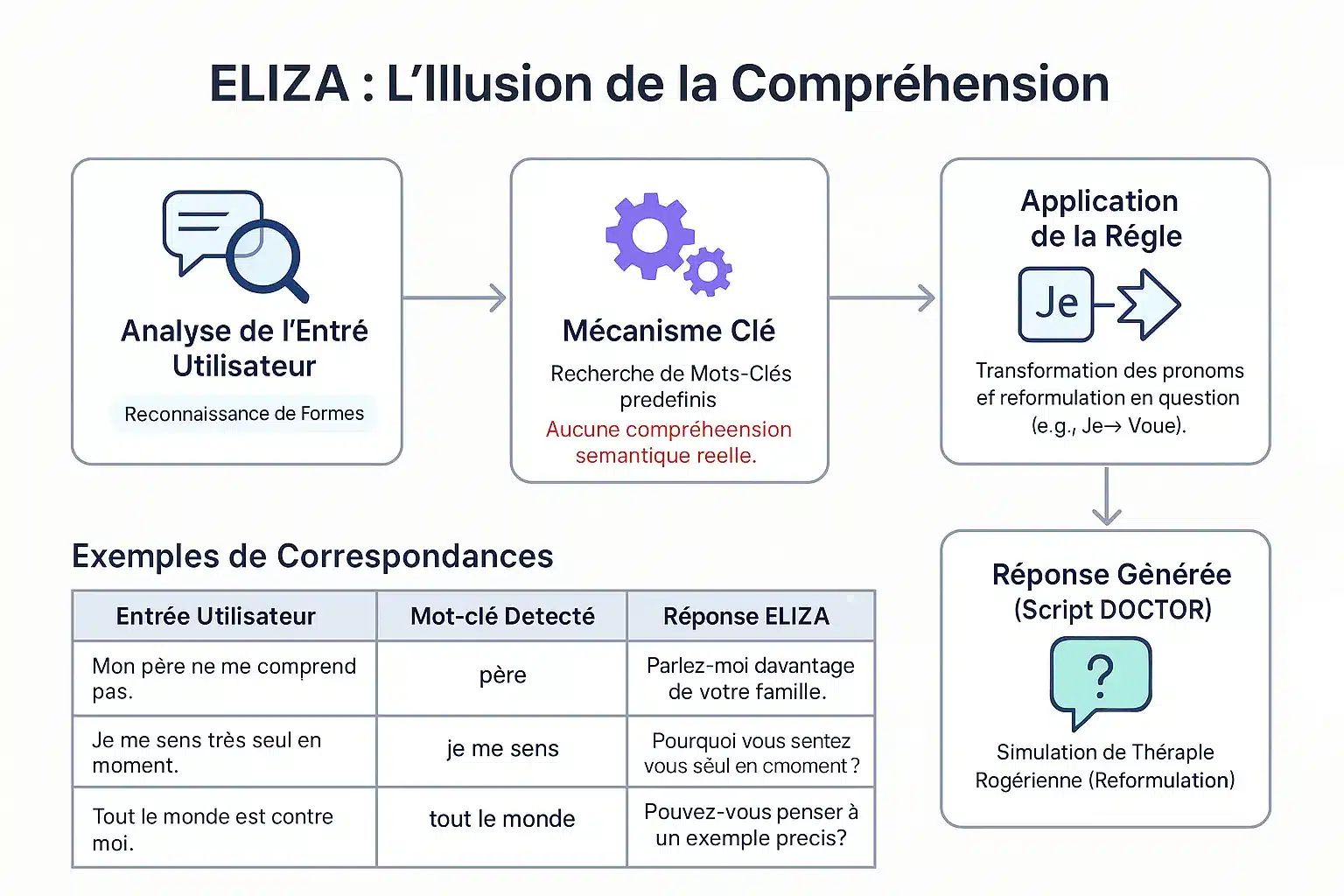

O método de correspondência de padrões

O ELIZA identifica palavras-chave por meio de um keystack. Dependendo da prioridade delas, ele divide e remonta as frases. Exemplo: “Eu” → “você” para reformular em perguntas. “Meu pai não me entende” → “Fale sobre sua família”. Sem compreensão real: um mecanismo padrão que simula a escuta empática.

O famoso script “DOCTOR” e a terapia Rogeriana

O script DOCTOR, inspirado na terapia Rogeriana, reflete o que o paciente diz sem aconselhamento. Exemplo: “Eu me sinto solitário” → “Por que solitário?”. Weizenbaum escolheu esse contexto para evitar uma base externa. Essa simplicidade revelou a propensão humana de antropomorfizar as máquinas. O ELIZA lançou as bases dos chatbots modernos. Um estudo de 2023 mostra que ele superou o GPT-3.5 em um teste de Turing, mas não o GPT-4 ou os humanos.

| Entrada | Palavra-chave | Resposta |

|---|---|---|

| Meu pai não me entende. | Pai | Fale sobre sua família. |

| Eu me sinto solitário. | Eu me sinto | Por que você se sente solitário? |

| Todos estão contra mim. | Todos | Dê um exemplo específico. |

| Acho que preciso de ajuda. | Eu acho que | Você acha que precisa de ajuda? |

O efeito ELIZA: quando os humanos projetam inteligência nas máquinas

Definição de um fenômeno psicológico importante

O efeito ELIZA refere-se à tendência de atribuir compreensão humana a símbolos gerados por computador. Um dispensador que exibe “OBRIGADO” é percebido como uma gratidão genuína, apesar de ser pré-programado.

Observado já em 1966 com ELIZA, o primeiro chatbot de Joseph Weizenbaum no MIT, esse fenômeno mostrou que os usuários projetavam emoções e compreensão em suas respostas simples, apesar de sua simplicidade. O efeito é o resultado da dissonância cognitiva.

Os usuários estão cientes do programa mecânico, mas agem como se o compreendessem. Essa ilusão, após breves interações, nos alerta sobre os limites da IA e o risco de excesso de confiança.

Antropomorfismo e a reação de Weizenbaum

Joseph Weizenbaum criou o ELIZA em 1966 para demonstrar a superficialidade da interação homem-máquina. Ele ficou surpreso com o fato de os usuários desenvolverem “pensamento delirante ” após breves interações. Sua secretária se recusou a deixá-lo observar as trocas de mensagens, preferindo compartilhar seus problemas com o programa.

Essa reação o levou a criticar a IA, apontando que as máquinas não têm discernimento humano. Em ‘Computer Power and Human Reason’ (Poder do computador e razão humana), ele descreveu como obsceno confiar julgamentos a máquinas, especialmente em psicologia ou justiça, porque somente os seres humanos têm responsabilidade moral. Seu trabalho inspira debates éticos.

O efeito ELIZA destaca nossa tendência de antropomorfizar as máquinas, atribuindo a elas uma inteligência e empatia que elas não possuem, um fenômeno que ainda está muito presente em nós hoje.

As características dessa ilusão

Essas manifestações revelam uma dissonância cognitiva entre o conhecimento técnico e o comportamento do usuário. As principais são:

- Atribuição de consciência ou intencionalidade até mesmo a respostas pré-programadas.

- Projetar emoções nas respostas, apesar da simplicidade delas.

- Compartilhar informações pessoais sem reservas, acreditando na escuta empática.

- A sensação de ser ouvido e compreendido por uma máquina.

Essa ilusão é reforçada por interfaces que incentivam a antropomorfização (nomes, diálogo). Algumas pessoas desenvolvem vínculos emocionais, ou até mesmo se apaixonam por chatbots, acreditando em um relacionamento real. Precisamos distinguir entre IA fraca (sem consciência) e IA forte. Os profissionais devem promover a transparência para evitar abusos.

O legado da ELIZA: uma pedra fundamental para a IA moderna

O ELIZA, criado em 1966 por Joseph Weizenbaum, revelou uma falha na percepção da IA. Sua operação baseada no reconhecimento de palavras-chave ilustrou os limites da IA primitiva, uma lição essencial para as instituições financeiras, onde a transparência dos sistemas automatizados protege os clientes contra interpretações errôneas.

O precursor da IA conversacional

Desenvolvido no MIT em 1966, o ELIZA simulava um psicoterapeuta usando um script DOCTOR. Por exemplo, uma frase como “Estou estressado” era transformada em “Por que você se sente estressado? Apesar de sua falta de compreensão real, ele enganava os usuários, criando uma ilusão de diálogo humano.

O efeito ELIZA demonstrou a propensão humana de antropomorfizar as máquinas, um fenômeno que ainda é relevante para os assistentes virtuais modernos. Esse precursor do teste de Turing destacou os desafios da simulação de conversação e, ao mesmo tempo, inspirou os chatbots atuais.

Limitações técnicas e avisos do designer

O ELIZA não tinha memória contextual e compreensão do significado. Suas respostas dependiam inteiramente de regras predefinidas. Em seu livro Computer Power and Human Reason, Weizenbaum enfatizou a distinção fundamental entre o cálculo mecânico e o julgamento humano.

Apesar de sua natureza revolucionária, o ELIZA era apenas um espelho inteligente das palavras do usuário, revelando suas limitações diante da complexidade e destacando o abismo entre a simulação e a compreensão.

Essa crítica continua sendo crucial para o banco: na concessão de empréstimos ou na detecção de fraudes, a IA deve sempre ser supervisionada por especialistas humanos para evitar decisões errôneas e manter a responsabilidade legal.

A ressurreição do código original: uma atualização arqueológica

Em 2021, o código-fonte do ELIZA foi encontrado nos arquivos do MIT e publicado como código-fonte aberto. Em 2024, uma equipe o restaurou em um emulador IBM 7094, reproduzindo fielmente as interações originais.

Essa restauração histórica oferece um vislumbre dos primeiros dias da IA conversacional. O código, acessível no GNU Emacs, é usado em currículos universitários para ensinar os fundamentos da IA e recebeu um Prêmio Legacy Peabody em 2021.

Para os setores financeiros, o ELIZA nos lembra que a IA carece de compreensão real. A transparência clara sobre seus recursos limita os riscos de compartilhamento excessivo de dados pessoais e fortalece a confiança do cliente nos serviços digitais.

ELIZA hoje: uma lição fundamental para a era da IA

Mais do que um artefato: um estudo de caso atemporal

A ELIZA, criada em 1966 por Joseph Weizenbaum no MIT, foi um marco na história da IA. Esse chatbot usava padrões e regras simples para simular uma conversa. O script “DOCTOR” imitava um psicoterapeuta Rogeriano, reformulando declarações em perguntas. No entanto, ele não entendia o idioma, apenas palavras-chave. Essa limitação foi intencional para demonstrar a superficialidade da interação homem-máquina.

No entanto, os usuários geralmente percebem uma compreensão humana. Esse “efeito ELIZA” revela nossa tendência de antropomorfizar as máquinas. Hoje, diante dos LLMs, essa distinção entre simulação e inteligência autêntica é vital. As instituições financeiras devem

Implicações para empresas e gerenciamento de confiança

Nos setores bancário e de seguros, é fundamental gerenciar as expectativas dos clientes. Os chatbots devem ser transparentes quanto à sua natureza: eles não entendem a linguagem, apenas simulam respostas.

- Defina claramente os recursos e as limitações dos chatbots para os clientes.

- Evite exagerar na empatia ou na compreensão dos agentes automatizados.

- Leve em conta o impacto psicológico da interação homem-máquina ao projetar as jornadas do cliente.

- Garantia de responsabilidade ética na implantação de tecnologias simuladas.

Esses princípios nos permitem construir relacionamentos duradouros com os clientes com base na transparência e na confiança. Em um setor em que a confiança é essencial, essa vigilância é fundamental para evitar decepções e manter a reputação.

O ELIZA, apesar de sua idade, ilustra o ponto essencial: uma simulação não é compreensão. Para bancos e seguradoras,

PERGUNTAS FREQUENTES

O que é o efeito ELIZA e o que ele significa para as instituições financeiras?

O efeito ELIZA refere-se à tendência dos usuários de atribuir compreensão e inteligência humanas aos sistemas automatizados, mesmo quando eles não possuem essas capacidades. No setor bancário, esse efeito pode levar a uma confiança excessiva nos chatbots, arriscando mal-entendidos sobre suas reais limitações. Portanto, as instituições devem esclarecer sistematicamente os recursos e as restrições dessas ferramentas para preservar a transparência e a segurança das interações com os clientes.

O que foi o chatbot ELIZA e sua função histórica?

Criada em 1966 por Joseph Weizenbaum no MIT, a ELIZA é considerada o primeiro chatbot da história. Ele usava um método de correspondência de padrões para gerar respostas com base em regras predefinidas. Embora tenha sido projetado inicialmente para simular uma terapia Rogeriana, o ELIZA revelou os limites da compreensão da máquina, destacando a importância da transparência na interação homem-máquina, um princípio fundamental para os serviços bancários modernos.