Principali informazioni: creato nel 1966 da Joseph Weizenbaum al MIT, ELIZA ha illustrato l’effetto ELIZA: gli esseri umani percepiscono l’intelligenza laddove c’è solo simulazione. Questa lezione cruciale per il settore bancario e assicurativo richiede un’assoluta trasparenza sui limiti dei chatbot, evitando qualsiasi confusione sulla loro capacità di elaborare dati sensibili o di comprendere contesti complessi.

Per gli istituti finanziari, la fiducia dipende dalla trasparenza assoluta quando si tratta di tecnologie AI. Il chatbot eliza, il primo programma conversazionale creato nel 1966 al MIT, ha rivelato l’effetto ELIZA: la tendenza umana ad attribuire una vera intelligenza a sistemi incapaci di possederla. Scopri come questo studio di riferimento guida la progettazione etica dei chatbot bancari e assicurativi, allineando chiaramente le aspettative dei clienti con le capacità reali, prevenendo i rischi di sfiducia e garantendo la conformità con i rigorosi standard normativi e l’etica professionale per una relazione sostenibile con i clienti.

Il chatbot ELIZA: le origini dell’intelligenza artificiale conversazionale

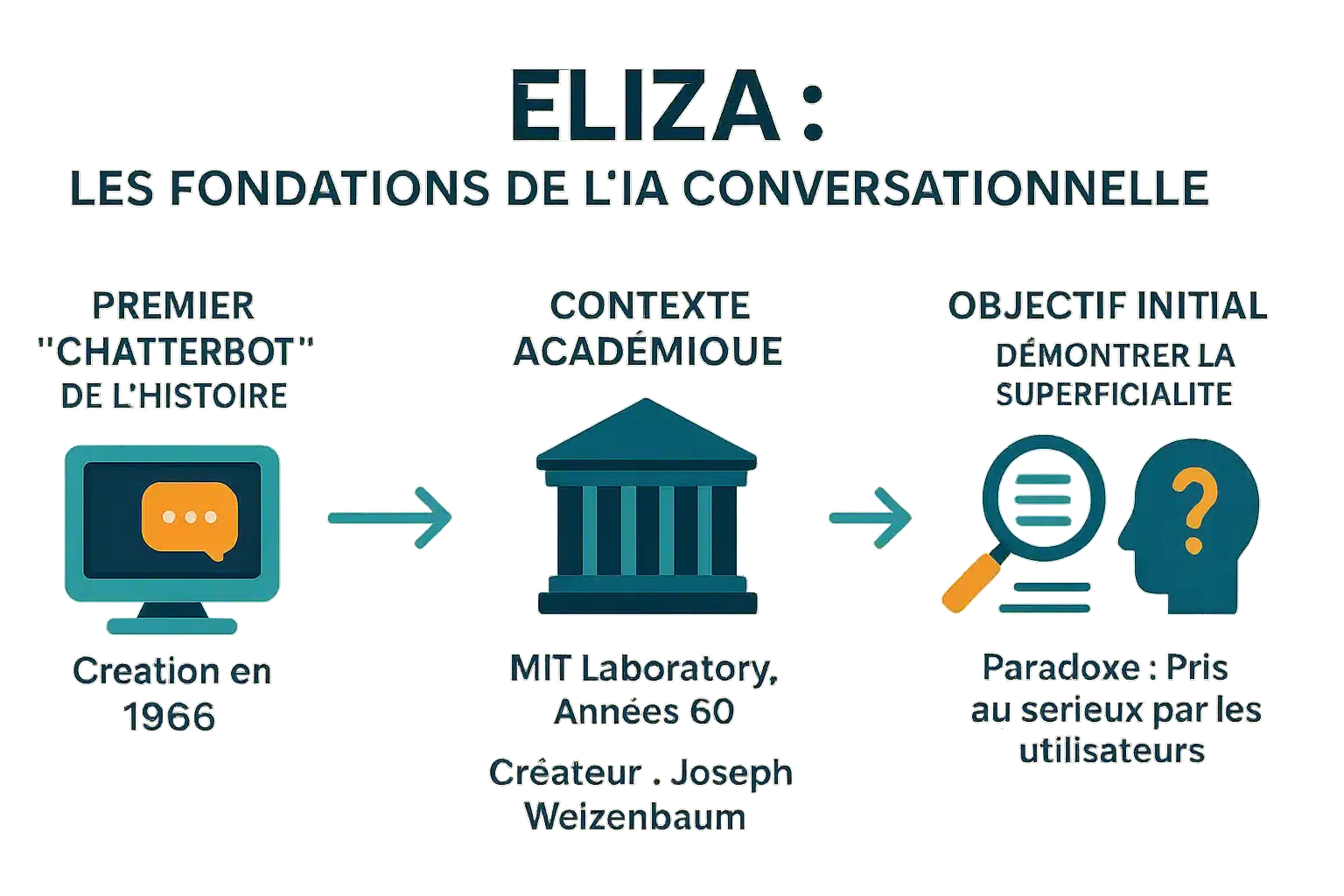

Il primo “chatterbot” della storia

Creata nel 1966 da Joseph Weizenbaum al MIT, ELIZA è il primo chatbot della storia. Il suo nome è ispirato a Eliza Doolittle (“Pigmalione”) e simboleggia l’evoluzione attraverso l’interazione. Ha trasformato frasi come “Ho paura” in “Perché hai paura?” attraverso il riconoscimento e la sostituzione di parole chiave. Questo meccanismo, privo di una reale comprensione, ha influenzato i moderni assistenti e ha dimostrato che anche i programmi più semplici possono ingannare gli utenti.

Un creatore e un contesto: il MIT negli anni ’60

Sviluppato al MIT tra il 1964 e il 1967, ELIZA utilizzava script MAD-SLIP e Lisp. Lo script DOCTOR simula uno psicoterapeuta rogersiano, riformulando ciò che viene detto senza alcuna base esterna. Riscoperto nel 2021 dopo essere stato perso per decenni, il suo codice sorgente permette di ricostruire vecchie conversazioni e studiare le tecniche dell’epoca.

L’obiettivo iniziale: una dimostrazione di superficialità

L’obiettivo di Weizenbaum era dimostrare la superficialità degli scambi uomo-macchina. Non era alla ricerca di una vera IA, ma di rivelare come gli esseri umani proiettano l’intelligenza su macchine semplici. Gli utenti, tra cui la sua segretaria, hanno condiviso informazioni personali, credendo di parlare con un essere umano. L’effetto ELIZA, un importante fenomeno psicologico, sottolinea questa tendenza all’antropomorfizzazione. In “Potere del computer e ragione umana”, l’autore metteva in guardia da questa confusione. ELIZA ispira ancora i moderni chatbot. Un recente studio del 2023 ha dimostrato che ha superato il GPT-3.5 in un test di Turing, senza però superare il GPT-4 o gli esseri umani.

Come funziona ELIZA: un’illusione di comprensione

Creata nel 1966 da Weizenbaum, ELIZA dimostrò la superficialità degli scambi uomo-macchina. Nonostante la sua semplicità, provocò una reazione inaspettata: gli utenti condividevano dettagli personali, credendo in una vera e propria empatia. Questo “effetto ELIZA” ha portato Weizenbaum a mettere in guardia dai

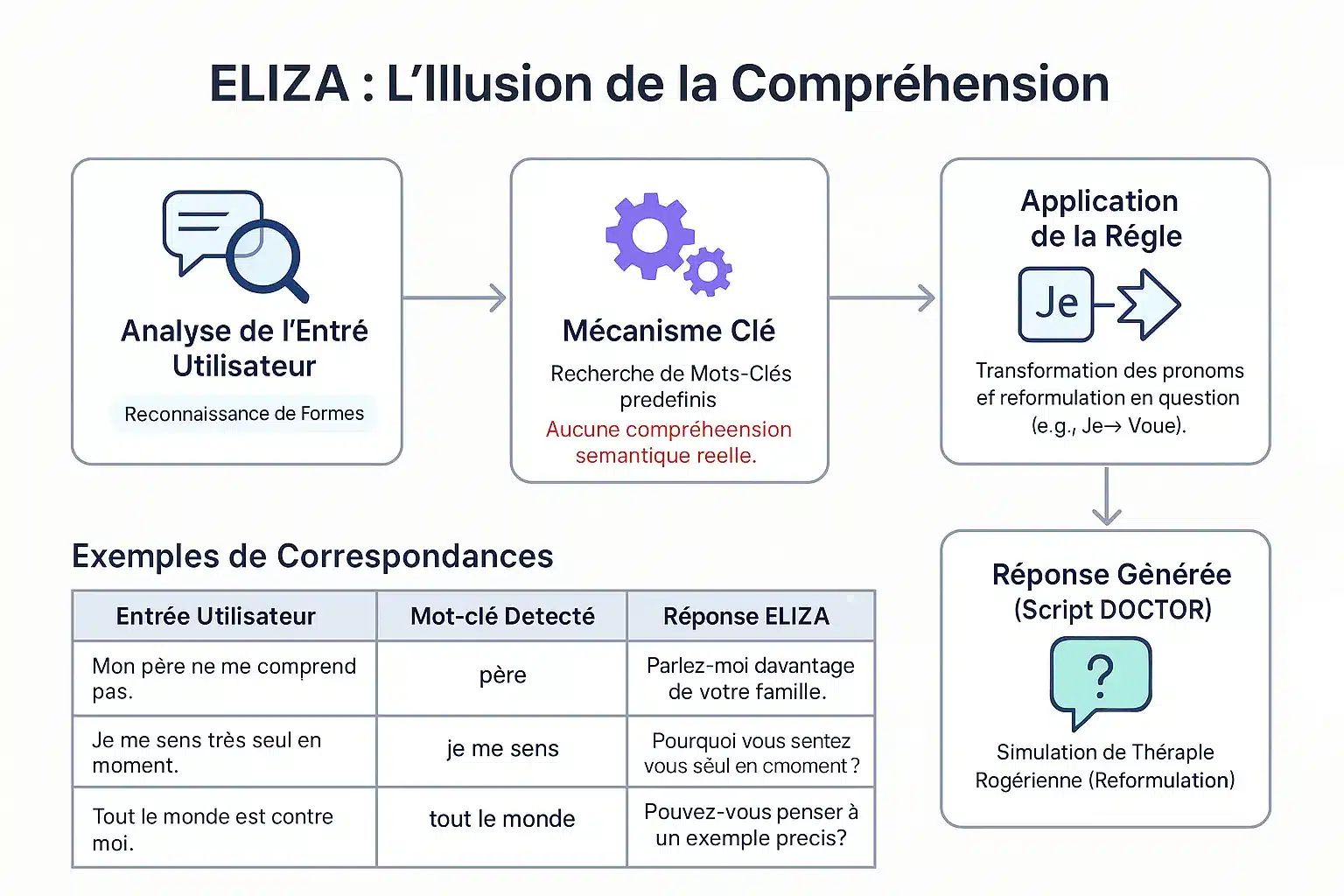

Il metodo della corrispondenza dei modelli

ELIZA identifica le parole chiave tramite un keystack. In base alla loro priorità, scompone e riassembla le frasi. Esempio: “io” → “tu” per riformulare in domande. “Mio padre non mi capisce” → “Parla della tua famiglia”. Nessuna comprensione reale: un meccanismo che simula l’ascolto empatico.

Il famoso testo “DOCTOR” e la terapia Rogeriana

Il copione del DOCTOR, ispirato alla terapia rogeriana, riflette ciò che il paziente dice senza dare consigli. Esempio: “Mi sento solo” → “Perché solo?”. Weizenbaum ha scelto questo contesto per evitare una base esterna. Questa semplicità ha rivelato la propensione umana ad antropomorfizzare le macchine. ELIZA ha gettato le basi per i moderni chatbot. Uno studio del 2023 dimostra che ha superato il GPT-3.5 in un test di Turing, ma non il GPT-4 o gli esseri umani.

| Parole chiave | Parola chiave | Risposta |

|---|---|---|

| Mio padre non mi capisce. | padre | Parla della tua famiglia. |

| Mi sento solo. | Mi sento | Perché ti senti solo? |

| Tutti sono contro di me. | tutti | Fai un esempio specifico. |

| Penso di aver bisogno di aiuto. | Credo | Pensi di aver bisogno di aiuto? |

L’effetto ELIZA: quando gli esseri umani proiettano l’intelligenza sulle macchine

Definizione di un fenomeno psicologico importante

L’effetto ELIZA si riferisce alla tendenza ad attribuire la comprensione umana ai simboli generati dal computer. Un dispenser che visualizza “GRAZIE” viene percepito come una gratitudine genuina, nonostante sia pre-programmato.

Osservato già nel 1966 con ELIZA, il primo chatbot di Joseph Weizenbaum al MIT, questo fenomeno ha dimostrato che gli utenti proiettavano emozioni e comprensione sulle sue semplici risposte, nonostante la sua semplicità. L’effetto è il risultato della dissonanza cognitiva.

Gli utenti sono consapevoli del programma meccanico ma si comportano come se lo capissero. Questa illusione, dopo brevi interazioni, ci mette in guardia dai limiti dell’IA e dal rischio di un’eccessiva fiducia.

Antropomorfismo e reazione di Weizenbaum

Joseph Weizenbaum creò ELIZA nel 1966 per dimostrare la superficialità dell’interazione uomo-macchina. Fu sorpreso dal fatto che gli utenti sviluppassero

Questa reazione lo portò a criticare l’IA, sottolineando che le macchine non hanno un giudizio umano. In “Computer Power and Human Reason”, ha definito osceno affidare i giudizi alle macchine, in particolare in psicologia o in giustizia, perché solo gli esseri umani hanno una responsabilità morale. Il suo lavoro ispira il dibattito etico.

L’effetto ELIZA evidenzia la nostra tendenza ad antropomorfizzare le macchine, attribuendo loro un’intelligenza e un’empatia che non possiedono, un fenomeno che ci accompagna ancora oggi.

Le caratteristiche di questa illusione

Queste manifestazioni rivelano una dissonanza cognitiva tra le conoscenze tecniche e il comportamento degli utenti. Le principali sono :

- Attribuzione di coscienza o intenzionalità anche a risposte pre-programmate.

- Proiettare emozioni sulle risposte nonostante la loro semplicità.

- Condividere informazioni personali senza riserve, credere nell’ascolto empatico.

- La sensazione di essere ascoltati e compresi da una macchina.

Questa illusione è rafforzata dalle interfacce che incoraggiano l’antropomorfizzazione (nomi, dialoghi). Alcune persone sviluppano legami emotivi o addirittura si innamorano dei chatbot, credendo in una relazione reale. Dobbiamo distinguere tra IA debole (senza coscienza) e IA forte. I professionisti devono promuovere la trasparenza per evitare abusi.

L’eredità di ELIZA: una pietra miliare per l’IA moderna

ELIZA, creata nel 1966 da Joseph Weizenbaum, ha rivelato un difetto nella percezione dell’IA. Il suo funzionamento basato sul riconoscimento di parole chiave ha illustrato i limiti dell’IA primitiva, una lezione essenziale per gli istituti finanziari dove la trasparenza dei sistemi automatizzati protegge i clienti da interpretazioni errate.

Il precursore dell’IA conversazionale

Sviluppato al MIT nel 1966, ELIZA simulava uno psicoterapeuta utilizzando uno script DOCTOR. Ad esempio, una frase come “Sono stressato” veniva trasformata in “Perché ti senti stressato? Nonostante la sua mancanza di comprensione reale, ingannava gli utenti, creando un’illusione di dialogo umano.

L’effetto ELIZA ha dimostrato la propensione umana ad antropomorfizzare le macchine, un fenomeno ancora attuale con i moderni assistenti virtuali. Questo precursore del test di Turing ha messo in luce le sfide della simulazione conversazionale e ha ispirato i chatbot di oggi.

Limitazioni tecniche e avvertenze del progettista

ELIZA mancava di memoria contestuale e di comprensione del significato. Le sue risposte dipendevano interamente da regole predefinite. Nel suo libro Computer Power and Human Reason, Weizenbaum ha sottolineato la distinzione fondamentale tra calcolo meccanico e giudizio umano.

Nonostante la sua natura rivoluzionaria, ELIZA non era altro che uno specchio intelligente delle parole dell’utente, rivelando i suoi limiti di fronte alla complessità ed evidenziando il divario tra simulazione e comprensione.

Questa critica rimane cruciale per la banca: nella concessione di prestiti o nel rilevamento di frodi, l ‘IA deve sempre essere supervisionata da esperti umani per evitare decisioni errate e mantenere la responsabilità legale.

La resurrezione del codice originale: un aggiornamento archeologico

Nel 2021, il codice sorgente di ELIZA fu ritrovato negli archivi del MIT e pubblicato come open source. Nel 2024, un team lo ripristina su un emulatore IBM 7094, riproducendo fedelmente le interazioni originali.

Questo restauro storico offre uno sguardo agli albori dell’IA conversazionale. Il codice, accessibile in GNU Emacs, viene utilizzato nei programmi universitari per insegnare i fondamenti dell’IA e ha ricevuto un Legacy Peabody Award nel 2021.

Per i settori finanziari, ELIZA ci ricorda che l’IA manca di una vera comprensione. Una chiara trasparenza sulle sue capacità limita i rischi di un’eccessiva condivisione dei dati personali e rafforza la fiducia dei clienti nei servizi digitali.

ELIZA oggi: una lezione fondamentale per l’era dell’AI

Più che un artefatto: un caso di studio senza tempo

ELIZA, creata nel 1966 da Joseph Weizenbaum al MIT, è stata una pietra miliare nella storia dell’IA. Questo chatbot utilizzava semplici schemi e regole per simulare una conversazione. Lo script “DOCTOR” imitava uno psicoterapeuta rogersiano, riformulando le affermazioni in domande. Tuttavia,

Eppure gli utenti hanno spesso percepito una comprensione umana. Questo “effetto ELIZA” rivela la nostra tendenza ad antropomorfizzare le macchine. Oggi, di fronte agli LLM, questa distinzione tra simulazione e intelligenza autentica è fondamentale. Le istituzioni finanziarie devono evitare aspettative irrealistiche chiarendo le reali capacità degli strumenti. Ignorare questa lezione rischia di danneggiare la credibilità dei servizi digitali e delle relazioni con i clienti.

Implicazioni per le aziende e la gestione della fiducia

Nei settori bancario e assicurativo, la gestione delle aspettative dei clienti è fondamentale. I chatbot devono essere trasparenti sulla loro natura: non capiscono il linguaggio, ma simulano solo le risposte.

- Definisci chiaramente le capacità e i limiti dei chatbot per i clienti.

- Evita di sopravvalutare l’empatia o la comprensione degli agenti automatici.

- Tieni conto dell’impatto psicologico dell’interazione uomo-macchina quando progetti i percorsi dei clienti.

- Garantire la responsabilità etica nell’impiego di tecnologie simulate.

Questi principi ci permettono di costruire relazioni durature con i clienti basate sulla trasparenza e sulla fiducia. In un settore in cui la fiducia è fondamentale, questa vigilanza è essenziale per evitare delusioni e mantenere la reputazione.

ELIZA, nonostante la sua età, illustra il punto essenziale: una simulazione non è comprensione. Per le banche e le compagnie assicurative, la trasparenza sui limiti dei chatbot è fondamentale. Evitare di sopravvalutare la loro empatia, rispettando l’

DOMANDE FREQUENTI

Cos’è l’effetto ELIZA e cosa significa per gli istituti finanziari?

L’effetto ELIZA si riferisce alla tendenza degli utenti ad attribuire comprensione e intelligenza umana ai sistemi automatizzati, anche quando questi non possiedono tali capacità. Nel settore bancario, questo effetto può portare a un’eccessiva fiducia nei chatbot, rischiando di creare malintesi sui loro reali limiti. Gli istituti devono quindi chiarire sistematicamente le capacità e le restrizioni di questi strumenti per preservare la trasparenza e la sicurezza delle interazioni con i clienti.

Che cos’era il chatbot ELIZA e il suo ruolo storico?

Creato nel 1966 da Joseph Weizenbaum al MIT, ELIZA è considerato il primo chatbot della storia. Utilizzava un metodo di pattern matching per generare risposte basate su regole predefinite. Sebbene sia stato inizialmente progettato per simulare una terapia rogersiana, ELIZA ha rivelato i limiti della comprensione automatica, sottolineando l’importanza della trasparenza nell’interazione uomo-macchina, un principio chiave per i moderni servizi bancari.