L’essentiel à retenir : l’IA en périphérie exécute l’apprentissage automatique directement sur les appareils locaux au lieu de s’appuyer sur des serveurs cloud distants. En analysant les données là où elles sont créées, cette technologie élimine les temps de latence et améliore considérablement la confidentialité. Elle permet aux gadgets intelligents et aux véhicules autonomes de prendre des décisions en une fraction de seconde de manière indépendante, assurant ainsi la fiabilité même lorsque la connexion Internet est interrompue.

Vous êtes-vous déjà demandé pourquoi votre maison intelligente semble parfois un peu lente ou si vous vous inquiétez de la circulation de vos séquences privées sur le Web pour analyse ? C’est précisément le problème que l’IA en périphérie résout en déplaçant l’intelligence des centres de données distants directement vers vos appareils locaux pour un traitement immédiat. Nous allons explorer comment cette approche locale accorde à vos appareils électroniques des pouvoirs de décision quasi instantanés et pourquoi c’est la meilleure solution pour garder vos données sensibles sous votre propre toit.

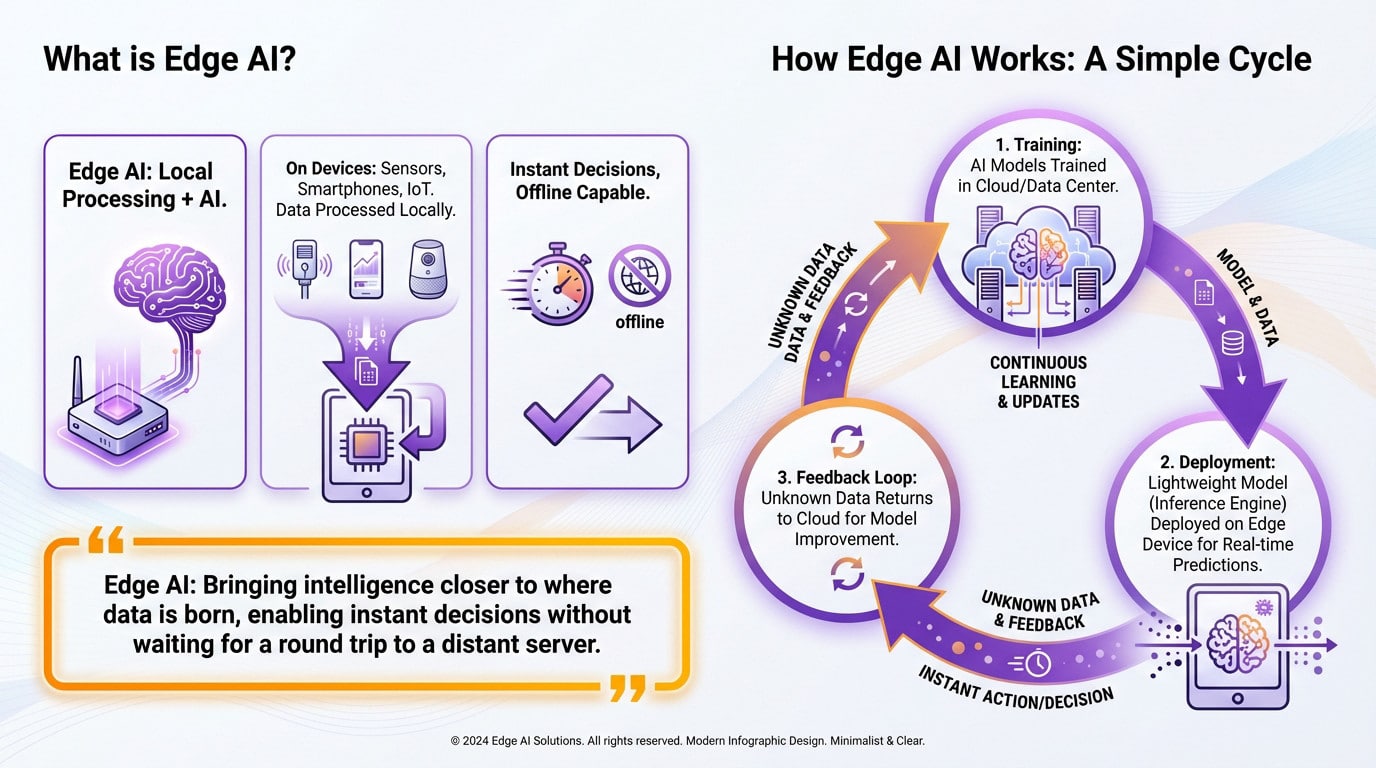

Qu’est-ce que l’IA en périphérie, au juste ?

Allons droit au but. L’IA en périphérie n’est pas juste un autre mot à la mode ; c’est un changement fondamental dans la façon dont les machines pensent, déplaçant l’intelligence des serveurs distants directement dans votre main.

Définir l’IA à la périphérie du réseau

Au fond, cette technologie est simplement le mariage de l’informatique en périphérie et de l’intelligence artificielle. Le concept est simple : les calculs complexes se font localement sur l’appareil, et non dans le cloud. Vous cessez d’externaliser la réflexion.

Nous parlons d’exécuter l’intelligence directement sur les capteurs, les smartphones et les gadgets IoT. Cette configuration vous permet de traiter les données localement, directement à la source où elles sont réellement générées, sans avoir besoin d’un long trajet vers un serveur distant. L’action reste ici.

Le résultat est une prise de décision en une fraction de seconde qui fonctionne parfaitement, même lorsque la connexion Internet est coupée.

Comment cela fonctionne réellement : un cycle simple

Cela commence par le gros du travail, appelé entraînement. Des réseaux neuronaux massifs apprennent à partir de montagnes de données, généralement à l’intérieur d’une infrastructure cloud puissante ou d’un centre de données centralisé.

Une fois que le cerveau est suffisamment intelligent, nous le réduisons. Une version allégée, le moteur d’inférence, est déployée directement sur votre appareil en périphérie. Désormais, il fait des prédictions en temps réel sans appeler la maison.

Si l’appareil voit quelque chose d’étrange qu’il ne reconnaît pas, il le signale. Ces données spécifiques retournent dans le cloud pour rendre le modèle plus intelligent.

L’idée centrale en bref

Pensez à une caméra de sécurité. Au lieu de diffuser des heures d’images de couloir vide vers le cloud, une caméra avec l’IA en périphérie repère l’intrus elle-même et envoie uniquement l’alerte. C’est plus rapide, et franchement, beaucoup plus privé.

L’IA en périphérie ne consiste pas à remplacer le cloud ; il s’agit de rapprocher l’intelligence de l’endroit où les données naissent, permettant des décisions instantanées sans attendre un aller-retour vers un serveur distant.

Périphérie vs. Cloud : un partenariat, pas un combat

Maintenant que nous avons les bases, tuons un mythe courant dès maintenant : l’IA en périphérie n’est pas là pour remplacer le cloud. En fait, ce sont juste les deux faces d’une même pièce.

Comprendre leurs rôles distincts

Considérez l’IA dans le cloud comme la salle de sport. Elle dispose d’une puissance de calcul et d’un stockage massifs, ce qui est absolument nécessaire pour entraîner des modèles complexes en utilisant des téraoctets de données. C’est là que le gros du travail se fait pour construire le cerveau.

D’un autre côté, nous avons l’IA en périphérie. C’est le terrain de jeu. Elle se concentre entièrement sur l’inférence en temps réel, appliquant ce modèle entraîné pour faire des prédictions rapides directement sur l’appareil, exactement là où l’action se déroule.

Un conte de deux IA : une comparaison directe

Vous vous demandez peut-être comment ils se comparent l’un à l’autre. Ce tableau visualise les forces et les faiblesses spécifiques de chaque approche, afin que vous puissiez voir exactement où ils diffèrent.

| Fonctionnalité | IA en périphérie | IA dans le cloud |

|---|---|---|

| Latence | Faible (millisecondes, traitement sur l’appareil) | Élevée (dépend de la connexion réseau aux serveurs distants) |

| Bande passante du réseau | Faible (transmission minimale des données) | Élevée (nécessite un téléchargement/téléversement constant des données) |

| Puissance de calcul | Limitée (contrainte par le matériel de l’appareil) | Virtuellement illimitée (accès à des centres de données massifs) |

| Confidentialité et sécurité des données | Élevée (données traitées et stockées localement) | Plus faible (données sensibles transmises sur le réseau) |

| Capacité hors ligne | Oui (peut fonctionner sans connexion Internet) | Non (nécessite une connectivité constante) |

L’architecture hybride : mieux ensemble

L’approche la plus intelligente est généralement une approche hybride. Le cloud gère l’entraînement et le réentraînement lourds des modèles, tandis que la périphérie gère l’exécution rapide et quotidienne des tâches. Cela fonctionne parce que chacun fait ce qu’il fait le mieux.

Imaginez un chef cuisinier créant une recette complexe ; c’est le cloud. Ensuite, vous avez le cuisinier de ligne, la périphérie, exécutant cette recette parfaitement et rapidement dans la cuisine.

Cette synergie entre la périphérie et le cloud est la clé de voûte de nombreuses applications modernes. Des voitures autonomes aux usines intelligentes, elles reposent toutes sur ce partenariat.

Les avantages concrets : pourquoi vous devriez vous en soucier

Réponse instantanée : éliminer la latence

La latence est l’ennemi absolu des applications critiques. C’est simplement le décalage entre la collecte des données et l’obtention d’une réponse. L’IA en périphérie élimine ce délai en traitant les chiffres directement sur place. La vitesse est primordiale ici.

Prenez une voiture autonome ; elle ne peut pas attendre que les serveurs cloud décident quand freiner. Cette décision doit être immédiate pour éviter un accident. Cette analyse en temps réel est vitale, tout comme la nécessité de réduire la latence dans les entrepôts intelligents.

Vos données restent avec vous : un avantage pour la confidentialité

Soyons honnêtes au sujet des risques de confidentialité aujourd’hui. L’envoi de données personnelles à des serveurs externes distants comporte toujours un risque de sécurité massif. Heureusement, l’IA en périphérie change complètement ce jeu dangereux.

En traitant les informations sensibles — comme les images de caméras de sécurité ou les statistiques de santé — localement, nous minimisons considérablement l’exposition. Vous gardez le contrôle sur ce qui compte le plus. La confidentialité des données est renforcée de manière native sans aucun effort supplémentaire requis de la part des utilisateurs.

Avec l’IA en périphérie, les informations sensibles n’ont pas besoin de voyager. Elles sont analysées là où elles sont créées, ce qui réduit considérablement la surface d’attaque pour les violations de données et améliore la confiance des utilisateurs.

Les principaux avantages en un coup d’œil

Les avantages sont multiples et se renforcent magnifiquement les uns les autres. Cela crée un écosystème puissant et efficace.

- Latence réduite : pour des réponses en temps réel et un retour d’information immédiat.

- Confidentialité des données améliorée : en traitant les données sensibles sur l’appareil au lieu de les envoyer au cloud.

- Utilisation réduite de la bande passante : réduction drastique de la quantité de données qui doivent être transmises, ce qui réduit également les coûts.

- Fiabilité améliorée : les applications peuvent fonctionner même avec une connexion Internet instable ou inexistante.

- Meilleure évolutivité : l’ajout de nouveaux appareils n’augmente pas proportionnellement la charge sur les ressources cloud centrales.

L’IA en périphérie en action : de votre domicile à l’usine

Assez de théorie. Voyons où cette technologie fait déjà des vagues. Vous seriez surpris de voir à quel point l’IA en périphérie est déjà présente tout autour de nous.

Des appareils intelligents de plus en plus intelligents

Pensez à votre salon en ce moment. Les assistants vocaux répondent instantanément parce qu’ils traitent l’audio localement, et non sur un serveur distant. Les sonnettes vidéo reconnaissent les visages sans télécharger le flux. Même les thermostats intelligents apprennent vos habitudes quotidiennes pour ajuster le chauffage avant que vous n’entriez.

Cela devient personnel avec la technologie de la santé. Les appareils portables comme les montres intelligentes analysent votre fréquence cardiaque en continu sur votre poignet. S’ils détectent une chute soudaine, ils alertent immédiatement les services d’urgence. Ils effectuent ce travail vital même sans avoir besoin d’une connexion Internet active.

Transformer les industries clés

Maintenant, regardez l’usine. C’est là que la maintenance prédictive permet d’économiser beaucoup d’argent. Les capteurs fixés aux machines analysent les vibrations et les températures en temps réel. Ils repèrent une panne des jours avant qu’elle ne se produise, empêchant des temps d’arrêt coûteux sans attendre qu’un humain vérifie.

Le commerce de détail rattrape son retard rapidement, lui aussi. Les chariots intelligents scannent vos courses au fur et à mesure que vous les déposez, ce qui vous évite complètement la file d’attente à la caisse. Les caméras analysent le flux de clients pour aider les gestionnaires à mieux organiser les allées. Pour découvrir d’autres cas d’utilisation, vous pouvez explorer notre blog sur l’IA.

L’avenir de la mobilité et de la sécurité

Les voitures autonomes sont le test ultime ici. Un véhicule doit prendre des centaines de décisions en une fraction de seconde en fonction des données des capteurs. S’appuyer sur une connexion cloud lente ici n’est pas seulement ennuyeux. C’est impossible sans un traitement de l’IA embarqué ultra-rapide.

Enfin, considérez les systèmes de sécurité modernes. La vision artificielle avancée sur les caméras peut détecter un comportement suspect en temps réel. Elles traitent le flux localement au lieu d’encombrer le réseau. Cela évite d’envoyer des heures d’images vidéo inutiles à un serveur juste pour ne rien trouver.

Les détails techniques : déployer l’IA sur de minuscules appareils

Cela semble formidable sur le papier, mais comment faire entrer un cerveau numérique massif sur une puce de la taille d’un ongle ? C’est là que le véritable casse-tête d’ingénierie commence.

Le défi des ressources limitées

Vous ne pouvez pas simplement glisser-déposer un modèle cloud massif sur un thermostat. Ces appareils en périphérie ont de minuscules batteries et une mémoire limitée par rapport à une ferme de serveurs. C’est comme essayer de garer un semi-remorque dans un espace compact. Le matériel refuse tout simplement de coopérer.

Ainsi, les ingénieurs doivent réduire ces modèles d’IA sans les rendre stupides. Cela devient un exercice d’équilibre à enjeux élevés entre la vitesse et la précision. Si vous coupez trop, le système ne parvient à rien reconnaître d’utile.

Rendre les modèles plus petits et plus rapides

C’est là que la magie opère, plus précisément grâce à deux techniques principales. Nous utilisons l’élagage pour supprimer les connexions inutiles, un peu comme jardiner un bonsaï. Ensuite, il y a la quantification, qui force les calculs à utiliser des nombres plus simples. Cela rend le gros du travail gérable.

Le résultat final est un modèle allégé, « léger », prêt à l’action. Il fonctionne rapidement sur du matériel spécialisé comme les NPU ou les GPU intégrés que l’on trouve dans les puces modernes. Cela permet à l’IA en périphérie de traiter les données instantanément sans latence. La vitesse est la seule monnaie ici.

Outils du métier pour les développeurs

Heureusement, les développeurs n’ont pas à coder cela à partir de zéro. Il existe tout un arsenal d’outils qui les attend.

Vous pourriez être surpris de voir à quel point ces cadres sont devenus accessibles aux ingénieurs. Au lieu de réinventer la roue, ils s’appuient sur des écosystèmes établis pour gérer le gros du travail d’optimisation et de déploiement sur du matériel spécifique.

- TensorFlow Lite & PyTorch Mobile : Versions allégées des cadres d’IA populaires, conçues spécifiquement pour les appareils mobiles et embarqués.

- MediaPipe : Un cadre Google pour la construction de pipelines ML appliqués multimodaux multiplateformes.

- Edge AI Studio / LiteRT : Kits d’outils spécifiques des fabricants de matériel (comme Texas Instruments) pour optimiser les modèles pour leurs puces.

- Keras & JAX : API et bibliothèques de haut niveau qui aident à construire et à entraîner des modèles qui peuvent ensuite être convertis pour un déploiement en périphérie.

L’IA en périphérie n’est pas qu’un simple mot à la mode ; elle remodèle la façon dont nos gadgets « pensent ». En déplaçant l’intelligence des serveurs distants vers l’appareil dans votre main, nous gagnons en vitesse, en confidentialité et en fiabilité. Le cloud ne va nulle part, mais l’avenir se déroule clairement ici, à la périphérie — grille-pain intelligents et tout le reste.