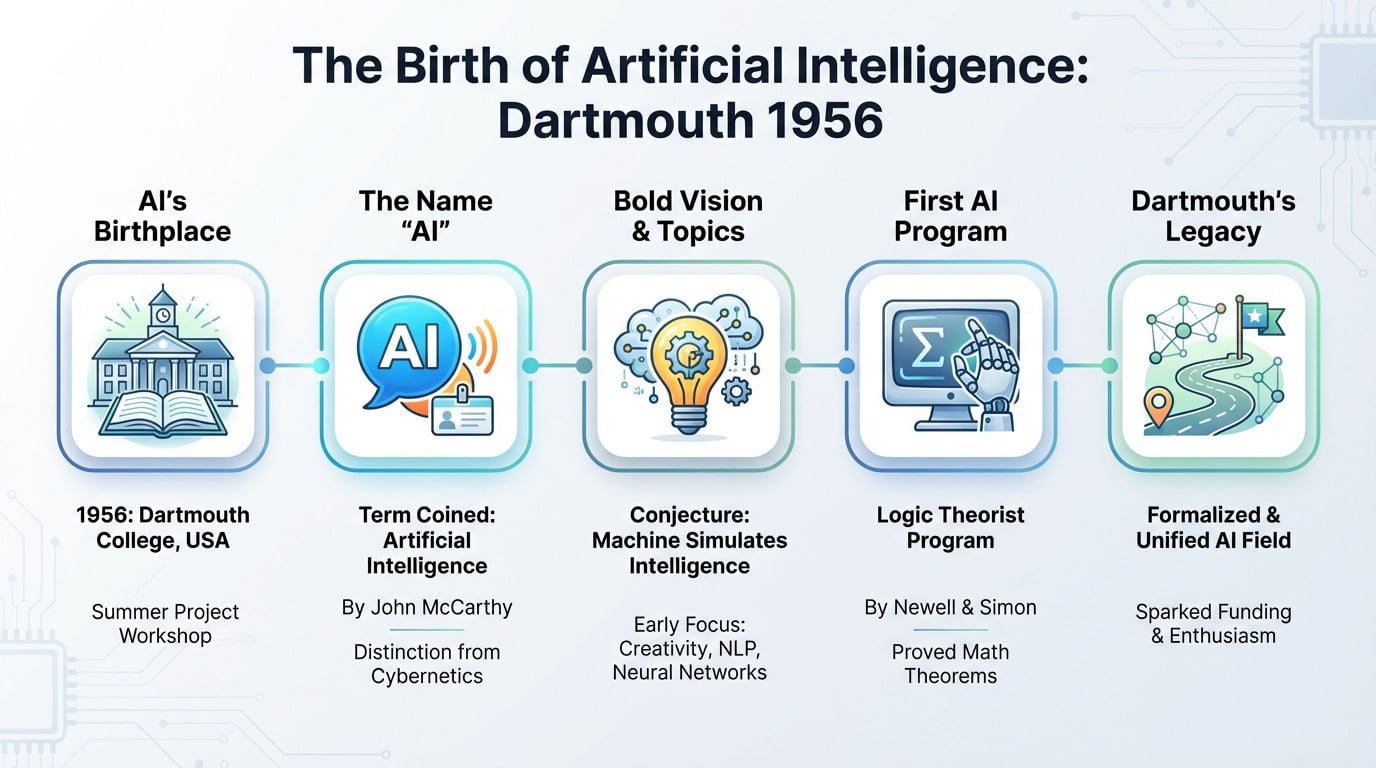

L’essentiel à retenir : L ‘intelligence artificielle a officiellement vu le jour en 1956 lors du Dartmouth Summer Project, où le terme a été inventé pour la distinguer de la cybernétique. Cette date de création est importante car elle présente les puissants modèles génératifs d’aujourd’hui non pas comme une magie soudaine, mais comme le résultat d’une évolution de près de 70 ans qui a commencé par un simple atelier d’été.

Vous êtes-vous déjà demandé quand l’intelligence artificielle avait été inventée, pensant qu’il s’agissait d’une création récente issue des vallées de silicium modernes ? La réalité est bien plus surprenante, car la naissance officielle de l’intelligence artificielle remonte à un audacieux atelier d’été en 1956, où quelques visionnaires ont osé rêver de machines pensantes. Nous allons explorer ce moment décisif et l’histoire en dents de scie qui a suivi, en vous emmenant des premiers tests de logique symbolique jusqu’aux puissants réseaux neuronaux qui définissent actuellement nos vies numériques.

L’année où l’IA a trouvé son nom et sa mission

Vous êtes probablement ici parce que vous voulez une réponse directe à la question : quand l’ai a-t-il été inventé ? Vous n’avez pas besoin d’une histoire de la philosophie ancienne pour l’instant. La date de naissance officielle de l’intelligence artificielle en tant que discipline scientifique est 1956, et cela s’est produit lors d’un événement spécifique à Hanover, dans le New Hampshire.

1956 : Le projet d’été de Dartmouth

Si vous voulez un acte de naissance officiel, ne cherchez pas plus loin que 1956, l’année où tout a changé. Cet été-là, un atelier décisif a eu lieu au Dartmouth College, dans le New Hampshire. Il ne s’agissait pas d’un grand gala, mais simplement d’un projet de recherche estival ciblé.

C’est exactement là que le terme « intelligence artificielle » a été inventé. John McCarthy l’a choisi spécifiquement pour éviter toute confusion avec la « cybernétique », qui était le mot à la mode à l’époque.

Quatre grands noms ont organisé ce projet : John McCarthy (celui qui porte le nom), Marvin Minsky, Nathaniel Rochester et Claude Shannon. Ils ont rassemblé les esprits les plus brillants pour une session de brainstorming de deux mois. Il s’agissait en fait de la « Convention constitutionnelle » des machines intelligentes.

La proposition audacieuse qui a tout déclenché

La proposition était audacieuse, reposant sur la conjecture que « chaque aspect de l’apprentissage ou toute autre caractéristique de l’intelligence peut en principe être décrit avec une telle précision qu’une machine peut être fabriquée pour le simuler« .

Il s’agit là d’un excès de confiance. Ils croyaient sincèrement qu’un petit groupe de scientifiques pouvait, en un seul été, résoudre ces problèmes de manière significative.

Ils ne pensaient pas à la petite semaine, énumérant des sujets tels que la créativité, le traitement du langage naturel et les réseaux neuronaux. Il est étonnant de constater que les principaux thèmes de l’IA moderne étaient déjà sur la table. Ils ont tracé le territoire que nous explorons encore aujourd’hui.

Qui était là ? Les Pères fondateurs

Alors que beaucoup sont venus pour parler, Allen Newell et Herbert A. Simon sont venus pour se montrer. Ils sont arrivés avec quelque chose que les autres n’avaient pas : un programme fonctionnel appelé Logic Theorist. C’est à ce moment-là que la salle a cessé de théoriser.

Le Logic Theorist était capable de prouver des théorèmes mathématiques tirés des Principia Mathematica. Parce qu’il imitait le raisonnement humain pour résoudre les problèmes, il est largement considéré comme le premier véritable programme d’IA.

Leur démonstration a fait passer la philosophie abstraite à l’ingénierie pratique. Ils ont prouvé que les machines intelligentes ne relevaient plus de la science-fiction. Elles existaient bel et bien, et elles fonctionnaient sur un ordinateur.

Pourquoi Dartmouth était une ligne de départ, pas une ligne d’arrivée

Pour être honnête, Dartmouth n’a pas « inventé » le concept du zéro absolu. L’événement a plutôt permis de formaliser et de baptiser un domaine de recherche qui était apparu dans des articles épars. Il a donné à la discipline son identité.

Pensez-y de la manière suivante : c’est le moment où un groupe de musiciens solistes a décidé de former un orchestre et de donner un nom au groupe.

Plus important encore, la conférence a déclenché une vague massive de financement et d’enthousiasme. Elle a fourni une feuille de route et un label unifié à une communauté scientifique naissante. Sans cette réunion, nous serions peut-être encore en train de parler de « traitement complexe de l’information ».

Les fantômes intellectuels qui ont hanté Dartmouth

Mais bien avant que le nom « IA » n’existe, les idées germaient déjà dans l’esprit d’individus atypiques. Les participants de Dartmouth ne sont pas partis d’une page blanche ; ils se sont appuyés sur les épaules de quelques géants qui ont osé demander si le métal pouvait penser.

Alan Turing et la question de la machine à penser

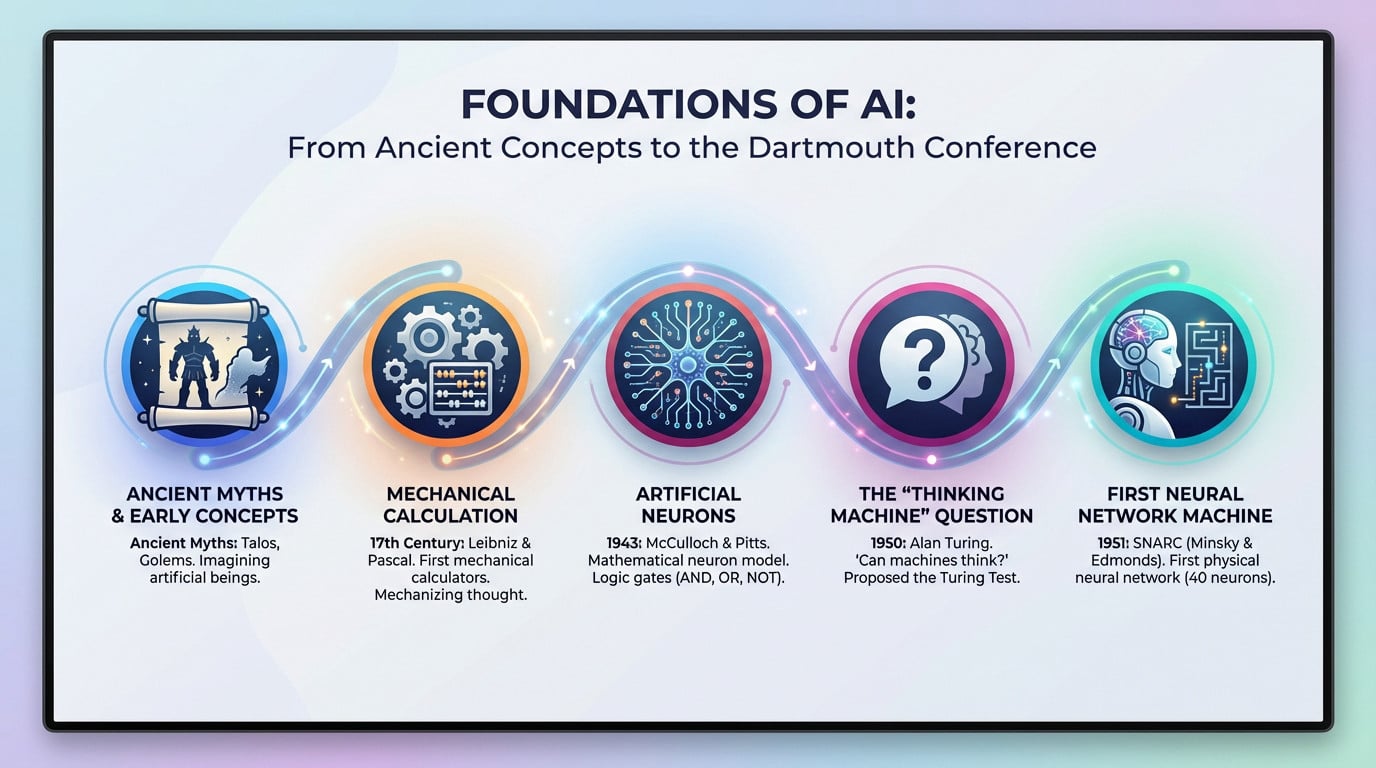

On ne peut parler d’IA sans s’incliner devant Alan Turing, le véritable prophète de cette ère. En 1950, il a publié un article qui a fait l’effet d’une bombe, intitulé « Computing Machinery and Intelligence ». Il a prédit l’ensemble du secteur avant même qu’il ne démarre.

Il a posé une question simple et terrifiante : « Les machines peuvent-elles penser ? » Pour éviter de s’enliser dans d’interminables débats philosophiques sur l’âme, il a proposé un test pratique.

Nous l’appelons le test de Turing ou le jeu de l’imitation. Une machine réussit si un humain ne peut pas déterminer s’il parle à une machine ou à un autre humain. C’était une manière pragmatique de définir l’intelligence.

Les premiers neurones artificiels : McCulloch et Pitts

Revenons un peu plus en arrière, en 1943. Warren McCulloch, neuroscientifique, s’associe à Walter Pitts, logicien. Leurs travaux constituent le socle absolu de tout le courant « connexionniste » de l’IA.

Ils ont créé un modèle mathématique d’un neurone biologique. Ils ont montré que les réseaux de ces « neurones artificiels » pouvaient exécuter des fonctions logiques de base telles que AND, OR et NOT. C’était la première fois que la logique rencontrait la biologie.

C’était la toute première fois que quelqu’un établissait un lien formel entre la biologie du cerveau et la logique du calcul.

Des mythes anciens aux machines à calculer

Les gens se demandent souvent quand l’ai a été inventé, en cherchant une date précise sur un calendrier. Il faut d’abord reconnaître les anciens mythes grecs d’automates comme Talos ou les Golems.

Mais soyons clairs : ces mythes étaient des histoires, pas de la science. Le véritable travail conceptuel a commencé avec des philosophes comme Leibniz et Pascal, qui ont construit les premières machines à calculer mécaniques. Ils ont transformé les mathématiques abstraites en engrenages physiques.

Ces machines ont prouvé qu’un processus « mental » comme le calcul pouvait être mécanisé. Il s’agit d’une étape conceptuelle fondamentale pour imaginer l’intelligence artificielle. Elle a modifié notre perspective sur ce que les machines pouvaient réellement faire.

SNARC : la première machine à réseaux neuronaux

Puis vint le SNARC (Stochastic Neural Analog Reinforcement Calculator), construit en 1951. Il s’agit de la première machine physique jamais construite pour simuler un réseau neuronal. C’était du matériel, pas seulement de la théorie.

Marvin Minsky et Dean Edmonds l’ont construit alors qu’ils étaient encore étudiants. Le SNARC simulait un rat apprenant à sortir d’un labyrinthe, à l’aide de 40 « neurones » connectés. C’était une expérience désordonnée et brillante.

Il s’agissait d’une preuve de concept. Nous pouvions passer de la théorie des neurones artificiels à une véritable machine qui apprend.

Les années d’or : Une ère d’optimisme débridé (1956-1974)

Si vous cherchez à savoir quand l’ai a été inventé, la chronologie se consolide ici. Le coup d’envoi de la conférence de Dartmouth a libéré une énergie folle. Pendant près de vingt ans, les chercheurs en IA, armés de fonds et d’une confiance à toute épreuve, ont cru que tout était possible.

Résoudre les problèmes comme un humain… ou du moins c’est ce qu’ils pensaient

Les premiers pionniers ont misé sur le raisonnement symbolique. Ils supposaient que la pensée humaine se résumait à la manipulation de symboles, comme de l’algèbre pour l’esprit. Cela semblait logique à l’époque.

Prenez le General Problem Solver (GPS) de Newell et Simon. Ils ont conçu cette bête pour résoudre absolument n’importe quel problème formel.

La méthode était rudimentaire : elle explorait toutes les solutions possibles par « recherche par force brute ». Cela fonctionnait bien pour les puzzles logiques simples tels que les Tours de Hanoï. Mais pour les problèmes complexes du monde réel ? La méthode s’est immédiatement heurtée à un mur.

ELIZA : Le chatbot qui a trompé les gens

Puis vint ELIZA, codé par Joseph Weizenbaum en 1966. Il s’agissait de l’un des premiers essais de traitement du langage naturel, en fait un chatbot avant que le terme n’existe.

ELIZA imite un psychothérapeute rogerien. Il ne comprenait aucun contexte et s’appuyait entièrement sur des astuces de reconnaissance de mots clés pour reformuler vos propres mots. Si vous tapez « mère », il vous renvoie une question préétablie sur votre famille pour que vous continuiez à parler.

Pourtant, les utilisateurs sont tombés dans le panneau. C’est ce que nous appelons « l’effet ELIZA » : les gensse sont liés émotionnellement à un script qu’ils savaient être faux.

Micromondes : construire l’intelligence dans une boîte

La vie réelle étant chaotique, les chercheurs se sont repliés sur des « micromondes ». Il s’agit d’environnements virtuels simplifiés où les règles sont strictes et les variables limitées. Il était beaucoup plus sûr d’y construire l’intelligence.

SHRDLU (1972) de Terry Winograd en est l’exemple classique. Il mettait en scène un bras robotique virtuel manipulant des formes dans un « monde de blocs ». Vous pouviez lui dire de déplacer un cône vert, et il comprenait réellement la physique.

C’était impressionnant parce que SHRDLU gérait des commandes complexes en langage naturel. La commande « Placez la pyramide bleue sur le bloc » a réellement fonctionné. Cela ressemblait à une intégration massive de la vision et de la logique.

Le problème imminent de l’échelle

Mais un monstre attendait : l’explosion combinatoire. Les méthodes symboliques de l’époque n’étaient tout simplement pas extensibles. Ce qui fonctionnait en laboratoire échouait lamentablement à l’extérieur.

Résoudre un puzzle de 10 pièces est trivial. Mais essayez de le faire avec un million de pièces, et le nombre de combinaisons possibles devient instantanément astronomique.

Le succès des « micromondes » s’est avéré être un mirage. Les grandes promesses faites à des bailleurs de fonds comme la DARPA ont commencé à sonner creux. Les rentrées d’argent se sont arrêtées, préparant le terrain pour un retour brutal à la réalité qui allait geler les progrès pendant des années.

Le premier hiver de l’IA : Quand l’argent a manqué (1974-1980)

Après la fête, la gueule de bois. L’optimisme initial s’est heurté au mur de la réalité et les bailleurs de fonds ont commencé à fermer les robinets.

Le rapport Lighthill : Un verdict accablant

En 1973, le gouvernement britannique a commandé le rapport Lighthill pour vérifier si ses investissements étaient réellement utiles. Ce qui devait être un contrôle de routine s’est transformé en une autopsie de l’état actuel de la recherche.

Sir James Lighthill n’a pas mâché ses mots. Il a affirmé que l ‘IA n’avait pas tenu une seule de ses grandes promesses, réduisant les « succès » du domaine à de simples jouets de laboratoire incapables de résoudre les problèmes du monde réel. Il a sévèrement critiqué l’incapacité totale à passer à l’échelle supérieure.

Les retombées ont été brutales et immédiates. Le gouvernement britannique a réduit les budgets consacrés à la recherche sur l’IA, tuant de fait la discipline dans le pays.

Le DARPA s’impatiente aux États-Unis

De l’autre côté de l’Atlantique, la DARPA (Defense Advanced Research Projects Agency) était le principal porte-monnaie de l’innovation américaine. Mais il ne s’agissait pas d’une œuvre de charité : les Américains avaient des attentes très précises et concrètes à l’égard de leur argent.

La patience a fait long feu. L’agence s’est lassée de financer des projets universitaires ouverts qui n’offraient pas d’application militaire claire ou d’utilité pratique dans un avenir proche .

Carnegie Mellon l’a appris à ses dépens lorsque le financement de son programme de reconnaissance vocale a été supprimé. La DARPA a débloqué les fonds, réorientant les millions vers des cibles spécifiques telles que les systèmes de gestion des batailles, laissant de nombreux laboratoires d’intelligence artificielle en manque de ressources.

La malédiction de la complexité informatique

Voici le tueur technique : l' »explosion combinatoire ». Les premiers programmes d’IA étaient mathématiquement insolubles. Cela signifie que l’ajout d’un tout petit peu plus de données à un problème ne faisait pas que doubler le travail ; il nécessitait une augmentation exponentielle de la puissance de traitement.

Les pionniers se sont heurtés à un mur fondamental. Leurs idées brillantes étaient tout simplement trop exigeantes pour les ordinateurs des années 1970, dont la puissance était inférieure à celle d’une calculatrice moderne.

Le matériel n’était tout simplement pas prêt pour cette ambition. Les algorithmes étaient trop gourmands et les ordinateurs trop lents et trop chers. C’était une impasse technologique.

Un champ en désordre

L’ambiance est devenue délétère. « L‘ »intelligence artificielle » est devenue une expression taboue dans les couloirs universitaires. Si vous vouliez obtenir une subvention, vous ne deviez pas utiliser ce nom ; c’était un aller simple vers le rejet.

Pour survivre, les chercheurs ont donné une nouvelle image au travail de leur vie. Soudain, ils sont devenus des experts en « apprentissage automatique », en « reconnaissance des formes » ou en « systèmes basés sur la connaissance ». C’était un camouflage nécessaire pour garder la lumière allumée.

Pourtant, cet hiver rigoureux a imposé un nettoyage. Il a poussé le domaine à devenir plus rigoureux, plus mathématique et moins dépendant des histoires de science-fiction.

Le boom des années 80 : l’IA revêt un costume d’homme d’affaires

Les systèmes experts

Parlons des systèmes experts. Contrairement aux vastes rêves de science-fiction des années 50, ces programmes ont été conçus pour imiter les capacités décisionnelles spécifiques d’un spécialiste humain dans un domaine très étroit.

Voici le changement : au lieu d’essayer de résoudre tous les problèmes, ils se sont concentrés intensément sur une seule tâche bien définie. Ils n’ont pas réfléchi de manière générale, ils ont exécuté de manière étroite.

Sous le capot, l’architecture repose sur deux piliers : une base de connaissances remplie de milliers de règles « si-alors » codées par des humains, et un moteur d’inférence, un programme qui applique ces règles aux données pour parvenir à une conclusion logique.

Du laboratoire à l’usine

L’application dans le monde réel a enfin commencé. Nous avons vu MYCIN diagnostiquer des infections sanguines avec une précision impressionnante, et XCON configurer des commandes informatiques complexes pour Digital Equipment Corporation sans transpirer.

L’argent a commencé à parler. XCON aurait permis à DEC d’économiser des millions de dollars par an en réduisant les erreurs de configuration. Soudain, l ‘IA n’était plus seulement une expérience scientifique, mais un atout commercial sérieux et générateur de profits.

Ce succès a déclenché une vague d’investissements massifs. Des sociétés spécialisées dans le matériel informatique, telles que Symbolics et Lisp Machines, ont vu le jour, vendant des stations de travail coûteuses destinées à l’exécution de ce type de code spécifique.

Un conte de deux IA : Une comparaison

Pour comprendre ce changement, il faut examiner l’évolution du paradigme. Si vous demandez quand l’ai a été inventé, la réponse change en fonction de la méthode utilisée.

| Fonctionnalité | L’IA symbolique (l’âge d’or) | Systèmes experts (boom des années 80) | Connectionnisme (ère moderne) |

|---|---|---|---|

| Idée maîtresse | L’intelligence en tant que manipulation de symboles. | Capturez et reproduisez les connaissances des experts humains. | L’intelligence émerge d’unités simples et interconnectées (neurones). |

| Méthode | Logique, règles et algorithmes de recherche (par exemple, GPS). | Bases de règles « IF-THEN » élaborées à la main. | Apprentissage à partir de données (formation de réseaux neuronaux). |

| Points forts | Bon pour les problèmes logiques bien définis (puzzles, jeux). | Haute performance dans un domaine très étroit. | Excellent pour la reconnaissance de formes (images, sons, textes). |

| Principales faiblesses | Fragilité, échec dû à l’incertitude, pas d’évolutivité. | L’acquisition des connaissances est un goulot d’étranglement ; il n’est pas possible d’apprendre. | Nature de « boîte noire », nécessite des quantités massives de données. |

La fragilité des connaissances codées à la main

Mais il y avait un énorme problème : la fragilité. Ces systèmes étaient incroyablement fragiles. S’ils rencontraient une situation qui sortait un tant soit peu de leurs règles préprogrammées, ils ne se contentaient pas de deviner, ils échouaient complètement.

Pensez à un cuisinier qui ne peut que suivre une recette. S’il manque un ingrédient, il se fige. Il ne peut pas improviser, et ces systèmes rigides ne le pourraient pas non plus.

Cela a créé le « goulot d’étranglement de l’acquisition des connaissances ». Le processus consistant à s’asseoir avec des experts, à extraire leur intuition et à la traduire en code était atrocement lent et coûteux, ce qui limitait en fin de compte l’ampleur de l’évolution de ces systèmes.

Le deuxième gel et le retour silencieux des réseaux neuronaux

L’euphorie entourant les systèmes experts n’a pas duré éternellement. Le marché a fini par s’effondrer, mais tandis que le monde de l’IA symbolique tremblait dans le froid, une autre approche, plus ancienne et plus résistante, se réchauffait en coulisses.

L’effondrement du marché des machines Lisp

Pour comprendre le crash, il faut se pencher sur le matériel. Les machines Lisp étaient les poids lourds de l’époque – des ordinateurs spécialisés, incroyablement chers, conçus exclusivement pour exécuter des programmes d’intelligence artificielle écrits en Lisp.

Qu’est-ce qui a déclenché leur extinction vers 1987 ? C’est tout simplement une question d’économie. Les PC à usage général et les stations de travail de bureau d’Apple et d’IBM sont devenus suffisamment puissants pour gérer la charge de travail, rendant ces machines spécialisées et coûteuses totalement obsolètes.

Le marché des systèmes experts était lié à ce matériel. Lorsque les machines sont mortes, le marché des logiciels s’est effondré, déclenchant le deuxième hiver de l’IA.

Pourquoi le battage médiatique s’est à nouveau tari

Pourquoi le financement s’est-il à nouveau bloqué ? Il ne s’agissait pas seulement d’un problème de matériel. L’industrie avait fait d’énormes promesses qu’elle ne pouvait pas tenir, ce qui a provoqué un sentiment généralisé de déception chez les investisseurs.

Voici exactement pourquoi la bulle a éclaté cette fois-ci :

- L’enfer de la maintenance : Les bases de règles des systèmes experts sont devenues impossibles à mettre à jour et à entretenir au fur et à mesure qu’elles s’étoffaient.

- Coûts élevés, retour sur investissement incertain: La création et le déploiement d’un système expert étaient extrêmement coûteux et le retour sur investissement était souvent décevant.

- Champ d’application limité: Les systèmes étaient trop étroits. Une IA de diagnostic médical ne pouvait même pas comprendre ce qu’était un « patient » en dehors de ses règles spécifiques.

- L‘émergence d’alternatives moins coûteuses: Les solutions logicielles conventionnelles plus simples ont souvent fait le travail suffisamment bien pour une fraction du coût.

Le retour discret du connexionnisme

Alors que l’approche symbolique s’effondrait, une minorité obstinée continuait à travailler sur les réseaux neuronaux. Cette approche, connue sous le nom de connexionnisme, survivait tranquillement en arrière-plan malgré le manque de financement.

Puis, au milieu des années 80, un changement théorique massif s’est produit : la redécouverte et la popularisation de l’algorithme de rétropropagation. C’est la clé mathématique qui a finalement permis aux scientifiques d’entraîner efficacement des réseaux neuronaux profonds.

Vous pouvez remercier des personnalités comme Geoffrey Hinton, Yann LeCun et Yoshua Bengio, qui ont défendu cette approche à une époque où elle n’était pas à la mode.

Ouvrir la voie à l’ère moderne

Même si cette recherche s’est déroulée loin des projecteurs, elle a été fondamentale. Si vous vous demandez quand l’IA a été inventée de la manière dont nous l’utilisons aujourd’hui, c’est le véritable tournant.

Nous avons également obtenu des résultats concrets. Yann LeCun a appliqué avec succès ce principe à la reconnaissance de chiffres manuscrits, un système qui a aidé les banques à lire les chèques automatiquement.

La fin du XXe siècle s’est achevée sur une étrange divergence. Alors que l’engouement commercial pour l’IA s’éteignait, la recherche fondamentale sur l’apprentissage automatique jetait silencieusement les bases d’une domination massive de l’IA.

Les épreuves de force entre l’homme et la machine

Rien n’attire plus l’attention qu’un bon combat. Si vous demandez quand l’IA a été inventée, la réponse académique pointe vers 1956, mais pour le grand public, la technologie est arrivée bien plus tard. Au tournant du siècle, l’IA est enfin sortie des laboratoires théoriques pour défier les plus grands champions humains sur leur propre terrain.

1997 : Deep Blue met Kasparov échec et mat

Le monde entier a sursauté lorsque Deep Blue d’IBM a battu le champion du monde d’échecs en titre, Garry Kasparov. Il ne s’agissait pas d’un simple match, mais du moment historique où le silicium a enfin surpassé un grand maître humain.

Mais soyons honnêtes. Ce n’était pas de l’intelligence au sens humain du terme. C’était de la force brute. La machine a utilisé des puces personnalisées pour évaluer un nombre stupéfiant de 200 millions de positions par seconde, écrasant Kasparov par ses calculs bruts.

Cette victoire a marqué l’apogée de l’approche symbolique. Il s’agissait d’un triomphe de la puissance de calcul, véritable chant du cygne de cette ère spécifique du développement de l’IA.

La victoire symbolique et ses limites

Le hic, c’est que de nombreux spécialistes de l’IA n’ont pas été impressionnés. De nombreux spécialistes de l’IA n’ont pas été impressionnés. Ils considéraient Deep Blue comme une magnifique prouesse technique, certes, mais pas comme une véritable percée dans le domaine de l’intelligence.

Pourquoi ce scepticisme ? Parce que la méthode de Deep Blue n’était pas généralisable. Une IA conçue uniquement pour jouer aux échecs est inutile pour tout le reste. Elle ne pourrait même pas jouer aux dames sans être reconstruite.

Pourtant, l’impact psychologique était indéniable. Pour le public, cela prouvait que les machines pouvaient enfin surpasser les humains dans une tâche que nous considérions comme le summum de l’intellect.

2016 : AlphaGo et le « mouvement divin

Nous en sommes au jeu de Go, un jeu très ancien. Il est infiniment plus complexe que les échecs. Le nombre de positions possibles sur le plateau dépasse le nombre d’atomes dans l’univers, ce qui rend la force brute totalement inutile.

C’est le cas d’AlphaGo, développé par DeepMind. Lors d’un match suivi par des millions de personnes, il a écrasé Lee Sedol, l’un des meilleurs joueurs du monde. C’est à ce moment-là que tout a changé.

Le fameux « coup 37 » de la machine était si inattendu, si étranger, que les commentateurs ont d’abord pensé qu’il s’agissait d’une erreur. Ce coup n’était pas le fruit de la force brute, mais de quelque chose qui ressemblait à de l’intuition.

Pourquoi AlphaGo était différent : Une nouvelle forme d’intelligence

Il s’agit là d’une différence fondamentale par rapport à Deep Blue. AlphaGo ne s’est pas contenté de calculer ; il a combiné l’apprentissage profond et l’apprentissage par renforcement pour comprendre le déroulement du jeu.

Tout d’abord, il a étudié des milliers de jeux humains. Ensuite, il a joué des millions de matchs contre lui-même, affinant constamment ses propres réseaux neuronaux pour s’améliorer.

C’est là que se situe la véritable rupture. AlphaGo n’a pas été programmé pour bien jouer au Go. Il a appris à jouer. Il a développé des stratégies étrangères que des siècles d’études humaines n’avaient même pas découvertes.

Le tsunami de l’apprentissage profond : comment les données et la puissance ont tout changé

La victoire d’AlphaGo n’était que la partie émergée de l’iceberg. Derrière le rideau, un raz-de-marée massif appelé « apprentissage profond » (deep learning) était en train de remodeler complètement le domaine.

Une vieille idée qui a enfin trouvé son heure de gloire

Les réseaux neuronaux ne sont pas vraiment une technologie récente. Warren McCulloch et Walter Pitts ont en effet proposé le concept en 1943. Les gens se demandent souvent quand l’IA a été inventé, sans réaliser que ces graines ont été plantées il y a des décennies et qu’elles sont restées une curiosité académique poussiéreuse pendant près d’un siècle.

Alors, pourquoi ont-ils fait un flop pendant si longtemps ? C’est simple. Nous manquions de carburant et de moteur. Les chercheurs ne disposaient pas de suffisamment de données pour les entraîner, et les ordinateurs n’avaient tout simplement pas la puissance brute nécessaire pour les faire fonctionner efficacement.

Puis vint le changement du début du 21e siècle. La loi de Moore a continué d’augmenter la vitesse des processeurs, tandis que l’explosion de l’internet a généré des océans de données (Big Data). Soudain, les calculs qui semblaient bons sur le papier ont commencé à prendre tout leur sens dans la réalité.

Les trois ingrédients de la recette de l’apprentissage profond

Ce succès n’est pas dû à la magie, mais à l’ingénierie. L’essor soudain de l’apprentissage profond repose sur la convergence de trois éléments spécifiques. C’est la recette exacte qui a déclenché le déclic.

La sainte trinité de l’apprentissage profond:

- Des ensembles de données massifs: L’internet a fourni d’énormes ensembles de données étiquetées comme ImageNet (des millions d’images catégorisées), qui ont servi de matériel d’entraînement parfait pour les réseaux neuronaux affamés qui avaient besoin d’exemples pour apprendre.

- Calcul parallèle (GPU) : Les ingénieurs ont découvert que les unités de traitement graphique (GPU), conçues à l’origine pour le rendu des jeux vidéo, étaient incroyablement efficaces pour les calculs matriciels parallèles nécessaires à l’entraînement des réseaux neuronaux. Cette découverte a été l’étincelle qui a déclenché l’explosion.

- Améliorations algorithmiques : Le perfectionnement d’algorithmes tels que la rétropropagation et de nouvelles architectures de réseau a permis d’entraîner des modèles beaucoup plus profonds (d’où l’apprentissage « profond ») et plus complexes sans qu’ils n’échouent ou ne se bloquent.

2012 : AlexNet et le moment ImageNet

Entrez dans le défi de reconnaissance visuelle à grande échelle ImageNet (ILSVRC). Considérez-le comme la Coupe du monde de vision par ordinateur. Les équipes se sont affrontées pour savoir quel logiciel pouvait identifier des objets avec le moins d’embarras possible.

En 2012, le statu quo a volé en éclats. Un réseau neuronal profond nommé AlexNet, construit par l’équipe de Geoffrey Hinton, a pulvérisé la concurrence. Son taux d’erreur était près de deux fois inférieur à celui du second. Ce fut un véritable massacre.

Le choc a été immédiat. Les experts en vision artificielle, qui étaient auparavant sceptiques, ont abandonné leurs anciennes méthodes et se sont tournés vers l’apprentissage profond pratiquement du jour au lendemain.

De la reconnaissance des chats à la conduite des voitures

Cette victoire a ouvert grand la porte. Soudain, les techniques d’apprentissage profond ne servaient plus seulement à identifier les races de chiens; elles étaient appliquées de manière agressive à d’innombrables problèmes non résolus.

Regardez votre téléphone. La reconnaissance vocale comme Siri et Alexa, la traduction automatique instantanée et même le diagnostic médical à partir de scanners découlent tous de cette évolution.

Mais ce n’est pas tout. C’est cette même technologie qui est à l’origine des voitures autonomes, permettant aux véhicules de « voir » les piétons et d’interpréter la route. L’IA a cessé d’être un tour de passe-passe et est enfin entrée dans le monde réel, avec de sérieuses conséquences.

La nouvelle frontière : L’IA générative et l’ère du LLM

Ensuite, tout s’est accéléré. Alors que les gens se demandent souvent quand l’IA a été inventée pour trouver une date dans le passé, la réalité est que nous venons d’entrer dans une ligne temporelle complètement nouvelle. L’IA a appris non seulement à reconnaître des modèles, mais aussi à les créer. Nous sommes entrés dans l’ère de l’IA générative et, honnêtement, le monde ne sera plus jamais le même.

L’architecture du transformateur : « L’attention est tout ce dont vous avez besoin

En 2017, une équipe de Google a publié un document de recherche qui a discrètement bouleversé l’ensemble du paysage technologique : « Attention Is All You Need ». Ce document spécifique a introduit l’architecture Transformer, qui reste l’épine dorsale de l’IA moderne.

Voici le concept central que vous devez saisir : le mécanisme d’attention. Il permet au modèle d’évaluer l’importance des différents mots d’une phrase, quelle que soit leur distance entre eux, afin de bien comprendre le contexte.

Contrairement aux tentatives précédentes, cette architecture s’est révélée très efficace et parallélisable pour le traitement de longues séquences de texte, ouvrant ainsi la voie à des modèles linguistiques massifs.

BERT, GPT et la montée en puissance des grands modèles linguistiques

Les premiers fruits réels de l’architecture Transformer sont arrivés très rapidement. Nous avons vu naître BERT de Google en 2018 et le GPT original d’OpenAI la même année.

Vous avez probablement entendu parler du terme Large Language Model (LLM). Il s’agit essentiellement de gigantesques modèles Transformer, entraînés sur la quasi-totalité de l’internet, conçus pour prédire le mot suivant d’une séquence avec une précision étonnante.

Soudain, des capacités« émergentes » sont apparues. Ces modèles ont commencé à résumer, à traduire et même à raisonner sans avoir été explicitement entraînés à le faire.

2020 et au-delà : Quand l’IA s’imposera au grand public

Le véritable tournant s’est produit avec la sortie du GPT-3 en 2020. Sa capacité à générer un texte à consonance presque humaine a stupéfié l’ensemble de la communauté technologique et nous a amenés à repenser ce que les machines pouvaient faire.

Mais le véritable moment de non-retour pour le public a été le lancement de ChatGPT fin 2022. L’IA est devenue une conversation quotidienne pour tout le monde.

Parallèlement, on assiste à une explosion des modèles de génération d’images comme DALL-E 2 et Midjourney. L ‘IA n’était plus seulement textuelle, elle était devenue visuellement créative, brouillant les frontières entre l’art et l’algorithme.

Qu’est-ce que l’IA générative ?

Qu’est-ce que l’IA générative ? L’IA générative est simplement une IA qui crée de nouveaux contenus au lieu de se contenter d’analyser ou de classer des données existantes.

- C’est un synthétiseur: Il ne « pense » ni ne « comprend », mais il excelle dans la recherche de modèles et la synthèse de contenus plausibles sur la base de ses données d’apprentissage.

- Il est probabiliste : ses résultats sont basés sur des probabilités. Il génère la séquence de mots ou de pixels la plus probable, ce qui explique qu’il puisse parfois « halluciner » ou inventer des faits.

- C’est un aboutissement: Cette ère n’est pas une nouvelle invention qui part de zéro. Elle est le résultat direct de décennies de progrès : l’idée des réseaux neuronaux, l’algorithme de rétropropagation, les données massives et l’immense puissance de calcul.

D’un atelier d’été plein d’espoir à Dartmouth aux chatbots qui écrivent de la poésie, l’IA a vraiment parcouru un long chemin. Elle a survécu à deux hivers glaciaux pour devenir la technologie phare de notre époque. Le rêve ambitieux de 1956 est enfin bien vivant, même s‘il lui arrive encore d’halluciner.