L’essentiel à retenir : Créé en 1966 par Joseph Weizenbaum au MIT, ELIZA a illustré l’effet ELIZA : les humains perçoivent une intelligence là où il n’y a qu’une simulation. Cette leçon cruciale pour le secteur bancaire et l’assurance impose une transparence absolue sur les limites des chatbots, évitant toute confusion sur leur capacité à traiter des données sensibles ou à comprendre des contextes complexes.

Pour les institutions financières, la confiance repose sur une transparence absolue face aux technologies IA. L’eliza chatbot, premier programme conversationnel créé en 1966 au MIT, a révélé l’effet ELIZA : une tendance humaine à attribuer une intelligence réelle à des systèmes incapables de la posséder. Découvrez comment cette étude historique guide la conception éthique des chatbots bancaires et d’assurance, en alignant clairement les attentes clients avec les capacités réelles, prévenant les risques de méfiance et garantissant la conformité aux normes réglementaires strictes et à l’éthique professionnelle pour une relation client durable.

ELIZA chatbot : aux origines de l’intelligence artificielle conversationnelle

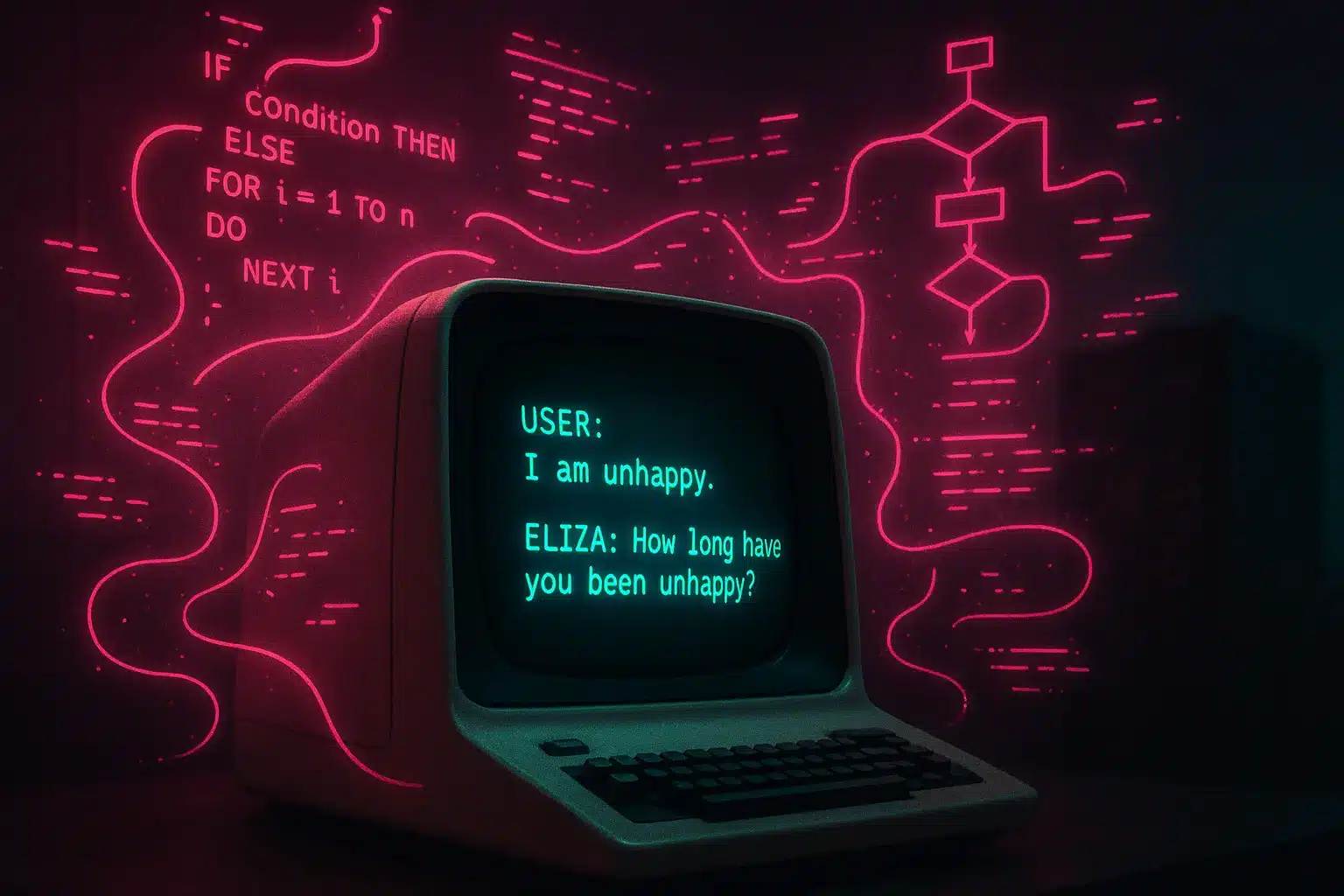

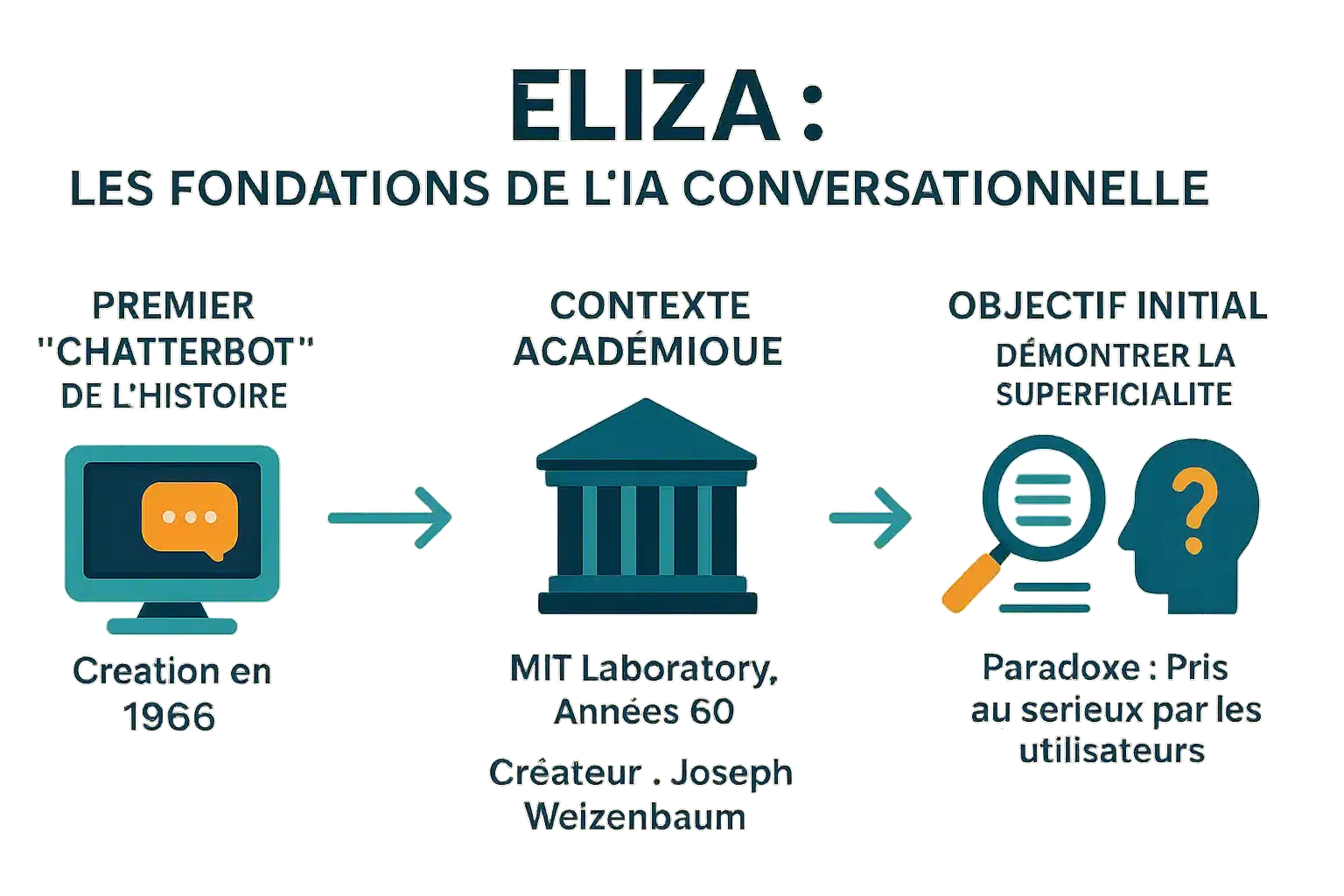

Le premier « chatterbot » de l’histoire

Créé en 1966 par Joseph Weizenbaum au MIT, ELIZA est le premier chatbot historique. Son nom s’inspire d’Eliza Doolittle (‘Pygmalion’), symbolisant l’évolution par l’interaction. Il transformait des phrases comme ‘J’ai peur’ en ‘Pourquoi avez-vous peur ?’ via reconnaissance de mots-clés et substitution. Ce mécanisme, sans compréhension réelle, a influencé les assistants modernes tout en démontrant que même des programmes simples pouvaient tromper les utilisateurs.

Un créateur et un contexte : le MIT dans les années 60

Développé au MIT entre 1964-1967, ELIZA utilisait MAD-SLIP et scripts Lisp. Le script DOCTOR simule un psychothérapeute rogerien, reformulant les propos sans base externe. Retrouvé en 2021 après avoir été perdu pendant des décennies, son code source permet de reconstituer les anciennes conversations et étudier les techniques de l’époque.

L’objectif initial : une démonstration de superficialité

Weizenbaum visait à démontrer la superficialité des échanges homme-machine. Il ne cherchait pas une IA réelle, mais à révéler comment les humains projettent une intelligence sur des machines simples. Des utilisateurs, y compris sa secrétaire, partageaient des informations personnelles, croyant parler à un humain. L’effet ELIZA, un phénomène psychologique majeur, souligne cette tendance à anthropomorphiser. Dans ‘Computer Power and Human Reason’, il mit en garde contre cette confusion. ELIZA inspire encore les chatbots modernes. Une étude récente de 2023 montre qu’elle surpassait GPT-3.5 lors d’un test de Turing, sans dépasser GPT-4 ou les humains.

Le fonctionnement d’ELIZA : une illusion de compréhension

Créé en 1966 par Weizenbaum, ELIZA démontrait la superficialité des échanges homme-machine. Malgré sa simplicité, il a provoqué une réaction inattendue : des utilisateurs partageaient des détails personnels, croyant à une empathie réelle. Cet « effet ELIZA » a conduit Weizenbaum à alerter sur les risques anthropomorphiques dans « Computer Power and Human Reason ». Son code, redécouvert en 2021, est dans GNU Emacs.

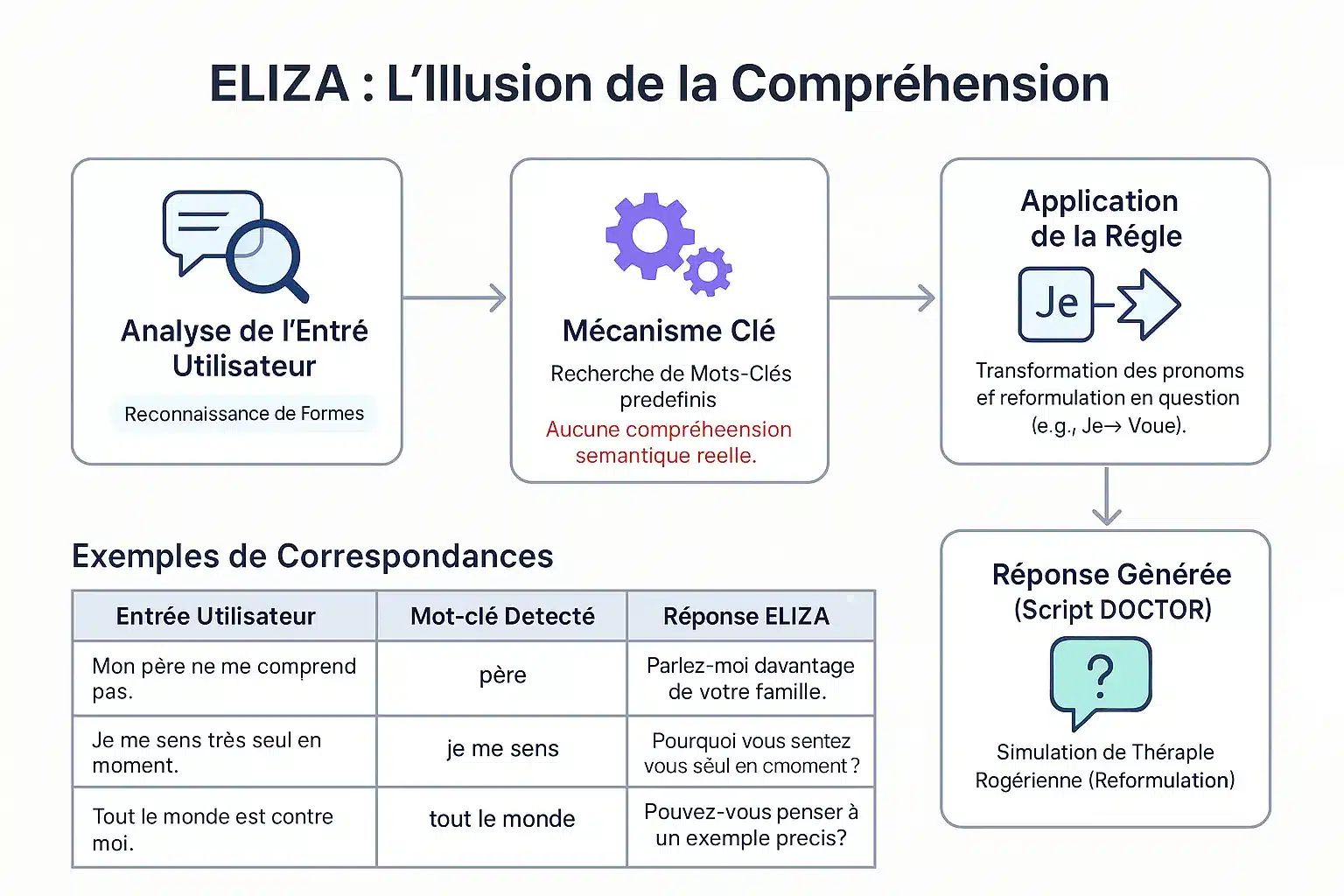

La méthode de la reconnaissance de formes (pattern matching)

ELIZA identifie des mots-clés via une « keystack ». Selon leur priorité, décompose et réassemble les phrases. Exemple : « je » → « vous » pour reformuler en questions. « Mon père ne me comprend pas » → « Parlez de votre famille. » Aucune compréhension réelle : un mécanisme de motifs simule l’écoute empathique.

Le célèbre script « DOCTOR » et la thérapie rogérienne

Le script DOCTOR, inspiré de la thérapie Rogerienne, reflète les propos du patient sans conseils. Exemple : « Je me sens seul » → « Pourquoi seul ? ». Weizenbaum a choisi ce contexte pour éviter une base externe. Cette simplicité a révélé la propension humaine à anthropomorphiser les machines. ELIZA a posé les bases des chatbots modernes. Une étude 2023 montre qu’il a surpassé GPT-3.5 dans un test de Turing, mais pas GPT-4 ou les humains.

| Entrée | Mot-clé | Réponse |

|---|---|---|

| Mon père ne me comprend pas. | père | Parlez de votre famille. |

| Je me sens seul. | je me sens | Pourquoi seul ? |

| Tout le monde est contre moi. | tout le monde | Donnez un exemple précis. |

| Je crois que j’ai besoin d’aide. | je crois que | Pensez-vous avoir besoin d’aide ? |

L’effet ELIZA : quand l’humain projette l’intelligence sur la machine

Définition d’un phénomène psychologique majeur

L’effet ELIZA désigne la tendance à attribuer une compréhension humaine à des symboles générés par ordinateur. Un distributeur affichant « MERCI » est perçu comme de la gratitude réelle, bien que préprogrammé.

Observé dès 1966 avec ELIZA, premier chatbot de Joseph Weizenbaum au MIT, ce phénomène montre que les utilisateurs projetaient émotions et compréhension sur ses réponses simples, malgré sa simplicité. L’effet résulte d’une dissonance cognitive.

Les utilisateurs savent le programme mécanique mais agissent comme s’il comprenait. Cette illusion, après brèves interactions, alerte sur les limites de l’IA et risques de confiance excessive.

L’anthropomorphisme et la réaction de Weizenbaum

Joseph Weizenbaum créa ELIZA en 1966 pour montrer la superficialité des interactions homme-machine. Il fut surpris que des utilisateurs développent une « pensée délirante » après brèves interactions. Sa secrétaire refusa qu’il observe leurs échanges, préférant partager ses problèmes avec le programme.

Cette réaction l’a poussé à critiquer l’IA, soulignant que les machines manquent de jugement humain. Dans ‘Computer Power and Human Reason’, il qualifiait d’obscénité de confier des jugements à des machines, notamment en psychologie ou justice, car seuls les humains portent une responsabilité morale. Son œuvre inspire des débats éthiques.

L’effet ELIZA met en lumière notre propension à anthropomorphiser les machines, en leur attribuant une intelligence et une empathie qu’elles ne possèdent pas, un phénomène toujours d’actualité.

Les caractéristiques de cette illusion

Ces manifestations révèlent une dissonance cognitive entre connaissance technique et comportement utilisateur. Les principales sont :

- Attribution de conscience ou intentionnalité même aux réponses préprogrammées.

- Projection d’émotions sur les réponses malgré leur simplicité.

- Partage d’informations personnelles sans réserve, croyant à une écoute empathique.

- Sensation d’être écouté et compris par une machine.

Cette illusion est renforcée par des interfaces encourageant l’anthropomorphisation (noms, dialogue). Certains développent des attachements émotionnels, voire tombent amoureux de chatbots, croyant en une relation réelle. Il faut distinguer l’IA faible (sans conscience) de l’IA forte. Professionnels doivent promouvoir la transparence pour éviter les dérives.

L’héritage d’ELIZA : une pierre angulaire pour l’IA moderne

ELIZA, créé en 1966 par Joseph Weizenbaum, a révélé une faille dans la perception de l’IA. Son fonctionnement basé sur la reconnaissance de mots-clés a illustré les limites de l’IA primitive, une leçon essentielle pour les institutions financières où la transparence des systèmes automatisés protège les clients contre les interprétations erronées.

Le précurseur de l’IA conversationnelle

Développé au MIT en 1966, ELIZA simulait un psychothérapeute via un script DOCTOR. Par exemple, une phrase comme « Je suis stressé » était transformée en « Pourquoi ressentez-vous du stress ? ». Malgré son manque de compréhension réelle, il trompait les utilisateurs, créant une illusion de dialogue humain.

L’effet ELIZA a démontré la propension humaine à anthropomorphiser les machines, un phénomène toujours pertinent avec les assistants virtuels modernes. Ce test précurseur du Turing a mis en lumière les défis de la simulation conversationnelle, tout en inspirant les chatbots actuels.

Les limites techniques et les avertissements du créateur

ELIZA manquait de mémoire contextuelle et de compréhension du sens. Ses réponses dépendaient entièrement de règles prédéfinies. Dans son ouvrage Computer Power and Human Reason, Weizenbaum a insisté sur la distinction fondamentale entre calcul mécanique et jugement humain.

Malgré son caractère révolutionnaire, ELIZA n’était qu’un miroir intelligent des paroles de l’utilisateur, révélant ses limites face à la complexité et soulignant le gouffre entre simulation et compréhension.

Cette critique reste cruciale pour la banque : dans les prêts ou la détection de fraude, une IA doit toujours être supervisée par des experts humains pour éviter des décisions erronées et maintenir la responsabilité légale.

La résurrection du code original : une actualité archéologique

En 2021, le code source d’ELIZA a été retrouvé dans les archives du MIT et publié en open source. En 2024, une équipe l’a restauré sur un émulateur IBM 7094, reproduisant fidèlement les interactions d’origine.

Cette restauration historique offre un aperçu des débuts de l’IA conversationnelle. Le code, accessible dans GNU Emacs, est utilisé dans les cursus universitaires pour enseigner les fondements de l’IA et a reçu un Legacy Peabody Award en 2021.

Pour les secteurs financiers, ELIZA rappelle que l’IA manque de compréhension réelle. Une transparence claire sur ses capacités limite les risques de partage excessif de données personnelles et renforce la confiance des clients dans les services numériques.

ELIZA aujourd’hui : une leçon fondamentale pour l’ère de l’IA

Plus qu’un artefact : une étude de cas intemporelle

ELIZA, créé en 1966 par Joseph Weizenbaum au MIT, marquait une étape clé dans l’histoire de l’IA. Ce chatbot utilisait des motifs et des règles simples pour simuler une conversation. Le script « DOCTOR » imitait un psychothérapeute rogerien, reformulant les déclarations en questions. Pourtant, il ne comprenait pas le langage, seulement des mots-clés. Cette limite était intentionnelle pour démontrer la superficialité des interactions homme-machine.

Pourtant, les utilisateurs percevaient souvent une compréhension humaine. Ce « effet ELIZA » révèle notre tendance à anthropomorphiser les machines. Aujourd’hui, face aux LLMs, cette distinction entre simulation et intelligence authentique est vitale. Les institutions financières doivent éviter des attentes irréalistes en clarifiant les capacités réelles des outils. Ignorer cette leçon risque de nuire à la crédibilité des services numériques et à la relation client.

Implications pour les entreprises et la gestion de la confiance

Dans les secteurs bancaire et d’assurance, la gestion des attentes clients est primordiale. Les chatbots doivent être transparents sur leur nature : ils ne comprennent pas le langage, seulement simulent des réponses. Sur-vendre la compréhension ou l’empathie peut entraîner une perte de confiance. Les progrès technologiques ont évolué les différents types d’intelligence artificielle, mais les questions psychologiques demeurent.

- Définir clairement les capacités et limites des chatbots pour les clients.

- Éviter de sur-vendre l’empathie ou la compréhension des agents automatisés.

- Prendre en compte l’impact psychologique des interactions homme-machine dans la conception des parcours clients.

- Assurer la responsabilité éthique dans le déploiement de technologies simulées.

Ces principes permettent de construire une relation client durable, fondée sur la transparence et la confiance. Dans un secteur où la confiance est essentielle, cette vigilance est indispensable pour prévenir les déceptions et maintenir la réputation.

ELIZA, malgré son ancienneté, illustre l’essentiel : une simulation n’est pas compréhension. Pour les banques et assurances, transparence sur les limites des chatbots est cruciale. Éviter de surévaluer leur empathie, tout en respectant l’éthique et la confiance client. Une leçon intemporelle face aux IA modernes.

FAQ

Quel est l’effet ELIZA et ses implications pour les institutions financières ?

L’effet ELIZA désigne la tendance des utilisateurs à attribuer une compréhension et une intelligence humaines à des systèmes automatisés, même lorsque ceux-ci ne possèdent pas ces capacités. Dans le secteur bancaire, cet effet peut induire une confiance excessive envers des chatbots, risquant des malentendus sur leurs limites réelles. Les institutions doivent donc clarifier systématiquement les capacités et les restrictions de ces outils afin de préserver la transparence et la sécurité des interactions clients.

Quel était le chatbot ELIZA et son rôle historique ?

Créé en 1966 par Joseph Weizenbaum au MIT, ELIZA est considéré comme le premier chatbot de l’histoire. Son fonctionnement reposait sur une méthode de correspondance de motifs (pattern matching) permettant de générer des réponses basées sur des règles prédéfinies. Bien qu’initialement conçu pour simuler une thérapie rogérienne, ELIZA a révélé les limites de la compréhension machine, soulignant l’importance de la transparence dans l’interaction homme-machine, un principe clé pour les services bancaires modernes.