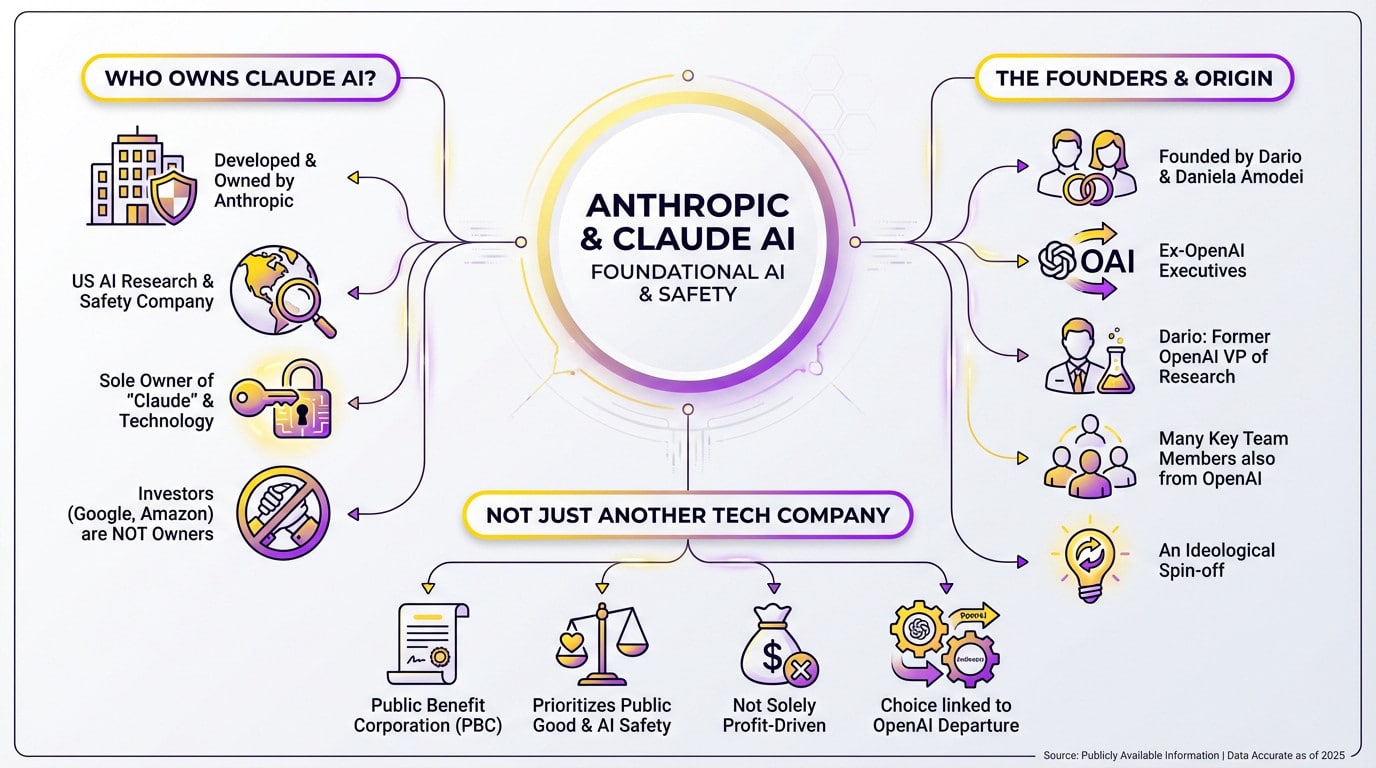

L’essentiel à retenir : Claude AI appartient exclusivement à Anthropic, une société d’intérêt public fondée par d’anciens dirigeants d’OpenAI pour donner la priorité à la sécurité de l’IA. Cette structure juridique protège la mission de l’entreprise contre les pressions liées au profit. Malgré les milliards de dollars de financement d’Amazon et de Google, ces géants ne détiennent qu’une participation minoritaire et n’exercent aucun contrôle sur la gouvernance.

Avec les chèques massifs d’Amazon et de Google, vous êtes en droit de vous demander qui possède Claude AI et s’il ne s’agit pas simplement d’une autre marionnette déguisée de Big Tech. La réponse se trouve chez Anthropic, une société d’utilité publique fondée par d’anciens cadres d’OpenAI qui ont construit une forteresse juridique pour protéger leur mission de sécurité contre les investisseurs. Nous révélons la structure de gouvernance spécifique qui empêche ces géants de la technologie de prendre le volant, en veillant à ce que l ‘éthique soit toujours prioritaire par rapport aux bénéfices trimestriels.

La bonne réponse : Anthropic est à l’origine de Claude AI

Qui est le propriétaire ?

Si vous vous demandez à qui appartient claude ai, voici la réalité. Il est développé et détenu à 100 % par Anthropic, une société américaine spécialisée dans la sécurité et la recherche en matière d’IA. Il n’y a pas de confusion possible.

Anthropic en est le seul et unique propriétaire. Le nom « Claude » et la technologie sous-jacente lui appartiennent entièrement.

Certes, des titans de la technologie comme Google et Amazon ont versé des milliards dans le pot. Mais soyons clairs : ce sont des investisseurs minoritaires, pas des propriétaires. Il s’agit là d’une distinction essentielle qui échappe à la plupart des gens.

Ceux qui ont tout déclenché

Les cerveaux de l’opération sont les frères et sœurs Dario Amodei et Daniela Amodei. Ils occupent respectivement les postes de directeur général et de président. Leur leadership définit l’entreprise, et ils étaient auparavant cadres supérieurs dans une autre grande entreprise.

Voici l’essentiel : ces fondateurs ont fait défection d’OpenAI. Dario y a d’ailleurs occupé le poste de vice-président de la recherche avant de partir. Connaître cette lignée change votre vision de l’ensemble du domaine.

Ils ne sont pas partis seuls ; plusieurs autres membres clés de l’équipe sont également des anciens de l’OpenAI. Il s’agit en fait d’un spin-off idéologique.

Une entreprise technologique pas comme les autres

Anthropic n’est pas une startup comme les autres : elle est enregistrée en tant qu’association d’utilité publique (AIP). Ce statut juridique est rare dans les grandes entreprises technologiques. Il change complètement les règles du jeu.

Cette structure oblige légalement l’entreprise à donner la priorité à la sécurité de l’IA et au bien public. Elle ne peut pas se contenter de rechercher le profit maximal pour les actionnaires. Elle impose un équilibre que la plupart des concurrents ignorent.

Ce choix structurel découle directement des préoccupations en matière de sécurité qui les ont poussés à quitter l’OpenAI. Ils ont construit la cage avant de faire grandir la bête. Il s’agit d’une démarche délibérée pour éviter un scénario d’emballement.

Le grand fossé : Pourquoi l’Anthropique s’est séparée de l’OpenAI

Maintenant que nous savons qui est derrière Claude, la question évidente est : pourquoi laisser un géant comme OpenAI repartir à zéro ? La réponse est une question de principe.

Un désaccord fondamental sur l’orientation

Nombreux sont ceux qui s’interrogent sur l’identité de Claude AI, s’attendant à une simple raison sociale, mais en réalité, il s’agit d’une sortie spectaculaire. Dario et Daniela Amodei ont quitté OpenAI en raison d’une profonde fracture dans la vision stratégique. L’équipe s’est inquiétée de la direction prise par OpenAI après son partenariat avec Microsoft, craignant que la commercialisation n’éclipse la mission initiale.

Le point de rupture n’était pas l’argent. Il s’agissait d’un conflit non négociable sur la priorité à accorder à la sécurité de l’IA par rapport à un déploiement rapide.

La philosophie de la « sécurité avant tout

Pour les fondateurs d’Anthropic, la sécurité n’est pas une option que l’on ajoute après coup, c’est le point de départ. Ils ont structuré l’entreprise de manière à éviter que la recherche du profit ne compromette les normes éthiques.

Cette conviction est absolue. Comme ils l’ont dit :

« Pour nous, la construction d’une IA sûre et bénéfique est la mission elle-même. Ce n’est pas une case à cocher, mais la raison même de l’existence de notre entreprise. »

C’est cette philosophie qui est à l’origine de la scission. Leurs principales préoccupations sont les suivantes :

- Le rythme de la commercialisation dépasse celui de la recherche en matière de sécurité.

- Les risques liés au déploiement de modèles puissants sans garde-fous adéquats.

- La nécessité d’une structure de gouvernance protégeant la mission de sécurité de la pression financière.

Un nouveau cap dans l’histoire de l’IA

Anthropic n’était pas une startup comme les autres, c’était une tentative de construire un modèle alternatif. Elle a créé une société d’utilité publique afin de donner légalement la priorité à l’humanité plutôt qu’au rendement des actionnaires.

Cette décision constitue un moment décisif dans l ‘histoire du développement de l’IA. Elle marque un clivage clair dans la manière dont nous construisons ces technologies, séparant ceux qui recherchent l’échelle de ceux qui sont obsédés par le contrôle. En raison de ce clivage, l’industrie doit maintenant faire face à des questions inconfortables en matière d’éthique et de gouvernance.

Une structure unique pour protéger la mission

Avoir une belle déclaration de mission, c’est bien. Mais lorsque vous regardez à qui appartient Claude AI, vous vous rendez compte que le véritable défi est de faire en sorte que cette mission survive aux pressions exercées par des milliards de dollars. Anthropic a mis en place une structure de gouvernance franchement inhabituelle.

Plus qu’une simple « société d’intérêt public »

Tout d’abord, examinons leur statut d’organisme d’intérêt public (OIP). Il ne s’agit pas d’un simple autocollant de marketing pour faire bonne figure, mais d’un engagement juridique contraignant.

Voici ce que cela donne sur le papier :

- Une mission d’intérêt public clairement déclarée.

- Le devoir d’équilibrer les portefeuilles des actionnaires avec cette mission.

- L’obligation de publier un rapport sur les performances sociales.

Pour Anthropic, cela signifie que le conseil d’administration a la responsabilité légale de poursuivre sa mission de sécurité, même si cela va à l’encontre de la maximisation des profits à court terme. Il s’agit là d’une décision rare.

Le fonds de prestations à long terme : L’ultime garde-fou

Mais voici le véritable atout : le « Long-Term Benefit Trust ». Il s’agit d’une entité indépendante composée d’experts en matière de sécurité et de politique publique, qui se tient à l’écart de l’échelle habituelle des entreprises.

Ce Trust dispose de droits spécifiques que les actionnaires ordinaires n’ont pas. Ils ont notamment le pouvoir d’élire une partie spécifique du conseil d’administration d’Anthropic.

Leur rôle ? Servir de garde-fou en veillant à ce que l’entreprise reste fidèle à sa mission sur le long terme.

Comment prévenir une prise de contrôle hostile de la mission

Cette structure est un pare-feu. Elle est conçue pour éviter que les investisseurs ne prennent le volant et ne renoncent à la prudence dans le seul but d’obtenir des marges bénéficiaires plus élevées.

Il s’agit d’une réponse directe à ce qu’ils ont perçu comme une dilution de la mission originale d’OpenAI. Ils ont construit ces murs juridiques spécifiquement pour se protéger de ce destin.

Fondamentalement, le pouvoir de la fiducie garantit que la sécurité de l’IA reste la priorité absolue.

Suivre l’argent : L’investissement n’est pas la propriété

Une structure éthique, c’est bien sur le papier, mais la mise en place d’une IA d’avant-garde coûte une fortune absolue. Alors, d’où vient l’argent ? Et surtout, qui tire réellement les ficelles financières derrière le rideau ?

Les géants de la technologie font leurs jeux

Amazon et Google font la une des journaux. Ils ont injecté des milliards de dollars directement dans l’opération. Il s’agit d’un montant stupéfiant.

Salesforce est également entré dans la danse avec des fonds propres importants. Elle est fermement impliquée dans le projet, aux côtés d’autres bailleurs de fonds importants.

Ces accords sont purement stratégiques. Ils permettent à ces géants d’accéder aux modèles d’Anthropic. Ils leur permettent de rester pertinents dans la course à l’IA, dont les enjeux sont considérables. Cependant, ils ne tiennent pas le volant.

Des enjeux minoritaires sans attaches ?

Précisons qui détient Claude Ai à l’heure actuelle : il s’agit de participations strictement minoritaires. Aucun de ces géants de la technologie ne possède réellement l’entreprise. Ils sont simplement des investisseurs.

Cet afflux massif de liquidités ne leur permet pas de contrôler la gouvernance. Ils ne peuvent pas dicter la feuille de route du produit. Plus important encore, ils n’ont aucune autorité sur les politiques de sécurité internes.

Le conseil d’administration et le fonds de prestations à long terme conservent le pouvoir de décision final. Ils sont les seuls à prendre les décisions. C’est l’élément central non négociable de l’ensemble de l’accord.

Propriété et investissement : Une distinction claire

Alors que les liquidités proviennent de Big Tech, les clés du royaume restent entre les mains d’Anthropic. La propriété et le contrôle restent totalement séparés. C’est un pare-feu.

| Rôle | Acteurs clés | Niveau de contrôle |

|---|---|---|

| Propriété et développement | PBC anthropique | Contrôle total : Contrôle total du code source, de la marque, de la feuille de route du produit, des politiques de sécurité et de la gouvernance. |

| Investissement financier important | Amazon, Google, etc. | Participation minoritaire / Pas de contrôle : Soutien financier important et partenariat dans le domaine de l’informatique dématérialisée, mais pas de siège au conseil d’administration ni de droit de regard sur la direction de l’entreprise. |

| Gouvernance éthique | Fonds de prestations à long terme | Pouvoir de veto et de contrôle : Peut élire les membres du conseil d’administration pour s’assurer que l’entreprise adhère à sa mission de sécurité, agissant comme un contrôle final sur les décisions de l’entreprise. |

L’IA constitutionnelle: la « sauce secrète » de Claude

Nous avons parlé de l’argent et des propriétaires de Claude AI-Anthropic. Mais techniquement, qu’est-ce qui rend leur approche si différente ? Tout tourne autour d’un concept qu’ils ont baptisé « IA constitutionnelle ».

Qu’est-ce que l’IA constitutionnelle ?

Il s’agit d’une méthode intelligente pour apprendre à l’IA à se comporter en toute sécurité. Elle supprime la nécessité d’une supervision humaine constante à chaque étape. Pensez-y comme à une moralité automatisée.

L’objectif est de donner à l’IA un ensemble de principes à suivre, à l’instar d’une constitution nationale, afin qu’elle puisse s’autocorriger et s’aligner sur les valeurs humaines.

Cette « constitution » est un ensemble spécifique de règles et de principes. Elle s’inspire largement de sources majeures telles que la Déclaration universelle des droits de l’homme. Le modèle doit respecter strictement ces lignes directrices.

Comment cela fonctionne-t-il en pratique ?

Le processus technique se déroule en deux phases distinctes. Tout d’abord, le modèle apprend à critiquer ses propres réponses initiales. Il les révise pour les faire correspondre strictement à la constitution. Cela crée une boucle de rétroaction sans l’épuisement humain habituel.

- Phase supervisée : L’IA génère des réponses, puis les critique et les réécrit sur la base des principes constitutionnels.

- Phase d’apprentissage par renforcement : L’IA est entraînée à partir de ces réponses autocorrigées, apprenant dès le départ à privilégier les résultats utiles et inoffensifs.

L’objectif final : une IA plus prévisible et plus sûre

L’objectif ultime est de rendre le comportement de l’IA transparent. Nous voulons l’empêcher de dérailler. Cela rend le système beaucoup moins enclin à des dérives dangereuses.

En s’appuyant sur des principes explicites plutôt que sur des préférences implicites, Anthropic construit de meilleurs modèles. Ils évitent le désordre des vagues sentiments humains. Le résultat est un modèle beaucoup plus robuste et aligné.

C’est leur réponse technique au problème de la sécurité et de l’alignement. Ce n’est pas seulement du marketing, c’est de l’ingénierie.

Claude dans l’arène : Comment l’anthropologie se démarque

Le concurrent qui a des principes

Lorsque l’on cherche à savoir qui possède Claude Ai, on trouve Anthropic, une entreprise lancée par d’anciens cadres d’OpenAI comme Dario Amodei. Ils ne sont pas simplement en concurrence pour construire le plus grand modèle. Leur principal argument de vente est en fait la sécurité et la fiabilité.

Alors que les concurrents parlent de spécifications brutes, Anthropic parle de prévisibilité. Elle met l’accent sur l’alignement éthique. Il s’agit d’un changement distinct et intentionnel de leurs priorités.

Il s’agit d’un énorme pari. Ils pensent que le marché finira par accorder autant d’importance à la sécurité qu’à la performance.

Une approche différente de la course à l’IA

Cette philosophie se retrouve dans toutes les activités de l’entreprise. Elle dicte la manière dont elle s’adresse au public. Elle contrôle même la manière dont elle diffuse ses modèles.

L’industrie est actuellement en train de sprinter vers la ligne d’arrivée. Anthropic agit comme un frein nécessaire, incitant à la prudence dans la quête de l’intelligence artificielle générale. Il s’agit d’un contrepoint vital et distinct.

Ils ne veulent pas seulement gagner. Ils veulent gagner la course de la bonne manière.

Ce que cela signifie pour les utilisateurs et les développeurs

Pour vous, cela change l’interaction quotidienne. Vous bénéficiez d’une IA moins susceptible de cracher des déchets toxiques. Son utilisation est tout simplement plus sûre.

Les développeurs qui utilisent l’API bénéficient d’un avantage considérable. Ils dorment mieux la nuit. Ils s’inquiètent beaucoup moins de voir leurs applications devenir soudainement indésirables.

Choisir cet outil, c’est faire une déclaration. Vous ne vous contentez pas de choisir une technologie, vous vous alignez sur une philosophie de développement responsable de l’IA. En fin de compte, l’important est de savoir à qui appartient le code.

En fin de compte, Claude AI appartient uniquement à Anthropic, et non aux géants de la technologie qui signent les chèques. En donnant la priorité à la sécurité grâce à une structure d’entreprise unique, les frères Amodei s’assurent que leur mission survivra au battage médiatique. Il reste à voir si cette approche éthique remportera la course, mais au moins nous savons qui conduit réellement.