Ce qu’il faut retenir : le Model Context Protocol (MCP) s’impose comme le port USB-C de l’intelligence artificielle. Ce standard open-source remplace les connexions complexes par un langage universel, permettant aux modèles de dialoguer fluidement. Soutenu par Anthropic, OpenAI et Google, il transforme l’intégration technique en un jeu d’enfant pour propulser des agents IA véritablement utiles et connectés.

Vous est-il déjà arrivé de grincer des dents face à la fragmentation actuelle, où relier vos données à une mcp ia exige systématiquement un développement complexe et sur mesure ? Ce standard open-source débarque pour mettre fin à ce bricolage incessant, en proposant enfin une interface universelle comparable à un port USB-C pour connecter n’importe quel outil à vos modèles. Nous verrons ensemble comment ce protocole ingénieux, désormais soutenu par l’industrie, simplifie mathématiquement vos intégrations et ouvre la voie à une nouvelle génération d’agents réellement utiles.

MCP IA : le standard qui met enfin de l’ordre dans l’IA

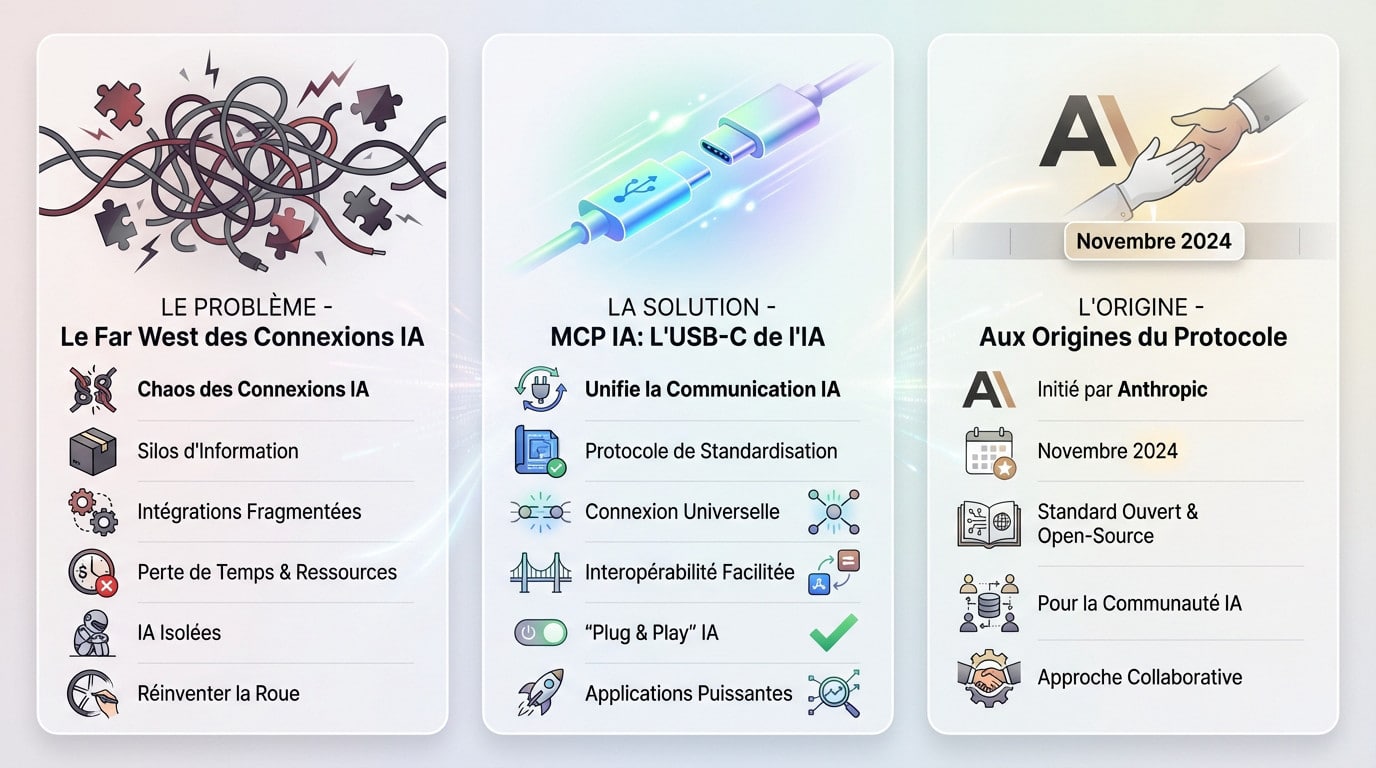

Le vrai problème : le Far West des connexions IA

Regardez le désordre actuel. Chaque outil, chaque base de données exige sa propre connexion bricolée sur mesure. On nage en plein dans des silos d’information et des intégrations fragmentées qui n’en finissent plus. C’est un gaspillage colossal de ressources pour les développeurs.

Cette complexité technique freine brutalement l’émergence d’applications vraiment futées et connectées. L’IA reste coincée dans sa propre bulle, incapable de dialoguer fluidement avec le monde extérieur.

Avant le MCP, connecter une IA à un nouvel outil, c’était comme réinventer la roue à chaque fois. Un cauchemar de complexité et de fragmentation pour les développeurs.

L’analogie qui sauve tout : le port USB-C de l’intelligence artificielle

Voyez le MCP IA comme le port USB-C de l’écosystème numérique. Tout comme ce câble a unifié nos chargeurs, ce protocole de standardisation harmonise enfin la communication des intelligences artificielles.

Peu importe la marque de votre modèle ou l’outil externe branché dessus, la connexion devient universelle. Le but est simple : que tout s’emboîte et fonctionne sans la moindre friction technique. C’est ça, la véritable interopérabilité.

Cette standardisation débloque des applications connectées bien plus puissantes, ce qui relevait de l’impossible hier encore.

Aux origines du protocole : l’initiative d’Anthropic

On doit cette initiative technique à Anthropic, qui a dévoilé le Model Context Protocol (MCP) en novembre 2024. Ils ont posé les bases d’un changement nécessaire.

Leur vision est claire : bâtir un standard ouvert et open-source pour que toute la communauté puisse l’adopter et y contribuer. Ce n’est pas une technologie propriétaire gardée sous clé.

Cette approche collaborative reste la seule façon d’éviter qu’un seul acteur ne dicte les règles de l’interconnexion des IA.

Sous le capot : comment fonctionne réellement le MCP

Maintenant qu’on a saisi le « pourquoi », passons au « comment ». Pas de magie noire ici, le MCP repose sur une architecture redoutablement efficace et bien pensée.

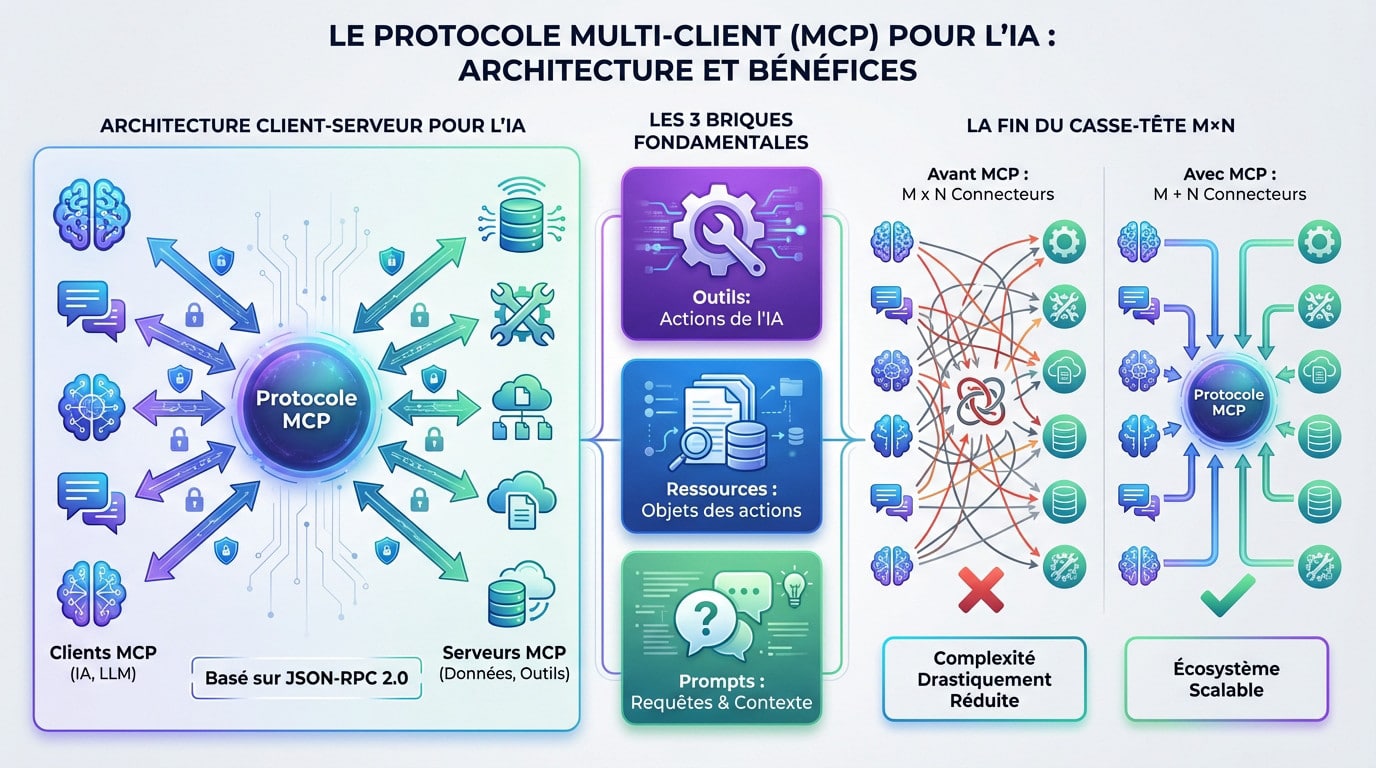

Une architecture client-serveur, mais pour l’IA

Imaginez un restaurant bien organisé. D’un côté, vous avez les clients MCP (vos applications d’IA comme Claude ou un IDE). De l’autre, les serveurs MCP qui détiennent les ingrédients (vos données, vos outils). Le protocole est simplement le langage standardisé qu’ils utilisent pour se comprendre.

C’est un échange bidirectionnel et sécurisé. Votre IA ne se contente pas de lire des données passivement ; elle peut exécuter de vraies actions via les outils que les serveurs exposent.

Inutile de réinventer la roue : le système s’appuie sur du solide, le standard JSON-RPC 2.0, transporté via HTTP ou stdio. C’est robuste et éprouvé.

Les 3 briques fondamentales du protocole

Pour structurer cette communication, le MCP définit trois concepts de base. Ces « primitives » constituent le cœur du système et dictent ce qui est techniquement possible.

- Outils (Tools) : Les actions exécutables par l’IA. Pensez à « envoyer un email », « lire un fichier local » ou « chercher une info en base de données ».

- Ressources (Resources) : Les cibles de ces actions. Un fichier spécifique, un contact CRM, un projet… C’est le contexte tangible et accessible.

- Prompts : Les requêtes standardisées incluant instructions et contexte pour guider le modèle. Pour maîtriser cet aspect, il est utile de comprendre ce qu’est un prompt IA.

La fin du casse-tête M×N : une simplification radicale

Le vrai problème, c’était l’équation « M×N ». Pour connecter M modèles d’IA à N outils, il fallait développer M multiplié par N connecteurs uniques. Un cauchemar de maintenance exponentiel qui paralysait les développeurs.

Le MCP change la donne mathématique. Grâce au standard, il suffit de créer M clients et N serveurs. L’équation devient une simple addition « M+N ». Tout se connecte instantanément.

Cette simplification mathématique réduit drastiquement la complexité technique, rendant l’écosystème enfin scalable et bien moins coûteux.

L’écosystème MCP en action : qui a déjà sauté le pas ?

Une norme, c’est bien beau sur le papier. Mais qui l’utilise vraiment ? L’adoption est le vrai test, et sur ce point, le MCP a rapidement marqué des points.

Des pionniers aux géants de la tech

Anthropic a évidemment été le premier à intégrer le MCP dans ses propres produits, comme les applications de bureau Claude. C’était la suite logique pour lancer le mouvement.

L’adoption a pris une autre dimension avec l’arrivée des deux autres géants. OpenAI a officiellement adopté le MCP en mars 2025 pour ChatGPT et son Agents SDK. Google DeepMind a suivi en avril 2025, confirmant le support pour ses modèles Gemini.

Lorsque ces trois acteurs majeurs s’alignent sur un standard, ce n’est plus une expérience, c’est un mouvement de fond dans l’industrie.

L’ancien monde vs le nouveau : le comparatif qui fait mal

Pour bien visualiser le changement, rien ne vaut un tableau comparatif direct.

| Aspect | Avant MCP (Intégrations M×N) | Avec MCP (Standard M+N) |

|---|---|---|

| Complexité | Très élevée, exponentielle. Chaque connexion est un projet. | Réduite, linéaire. On crée un client ou un serveur réutilisable. |

| Réutilisabilité | Faible. Un connecteur pour Slack-ChatGPT ne fonctionne pas pour Slack-Gemini. | Élevée. Un serveur MCP pour Slack fonctionne avec n’importe quel client MCP. |

| Découverte d’outils | Manuelle. Le développeur doit coder explicitement chaque capacité. | Automatique. Le client MCP peut découvrir les outils disponibles sur un serveur. |

| Maintenance | Coûteuse. Chaque mise à jour d’API peut casser N intégrations. | Simplifiée. On met à jour le serveur MCP, tous les clients en bénéficient. |

Des cas d’usage qui parlent d’eux-mêmes

Des serveurs MCP pré-construits ont été partagés par Anthropic pour des outils populaires comme Google Drive, Slack, et GitHub.

L’impact est concret sur le terrain. Des entreprises comme Block et Apollo l’ont intégré. Des outils pour développeurs comme Zed, Replit, et Sourcegraph l’utilisent pour que leurs agents IA récupèrent du contexte de code plus efficacement.

L’adoption n’est pas que théorique, elle est déjà en production et résout des problèmes réels.

Concrètement, ça change quoi ? Les nouvelles applications possibles

L’adoption par les grands noms, c’est une chose. Mais pour nous, utilisateurs et créateurs, qu’est-ce que ça débloque concrètement ? Les possibilités sont bien plus excitantes qu’une simple norme technique.

Des assistants IA dopés au contexte réel

Vous voyez le problème actuel ? Nos IA manquent cruellement de contexte. Elles ignorent tout de ce qui se trouve dans vos fichiers locaux, vos emails ou l’état de vos projets. Le MCP change radicalement la donne.

Prenez un cas concret. Demandez à votre IA : « Fais-moi un résumé du projet X ». Elle pourra se connecter directement au serveur MCP de votre outil de gestion, comme GitHub, pour lire les derniers commits et commentaires.

L’IA n’est plus une boîte noire amnésique, elle devient un véritable collègue informé. C’est l’un des meilleurs assistants IA qu’on puisse imaginer.

Vers des agents IA vraiment autonomes

Poussons le concept plus loin. Avec un accès standardisé à des outils, l’IA peut passer de simple répondant à acteur. C’est la naissance des agents IA autonomes.

Avec le MCP, on ne parle plus seulement d’assistants qui répondent. On parle d’agents qui agissent, collaborent et résolvent des problèmes complexes en notre nom.

Imaginez un agent planifiant un voyage en se connectant aux serveurs MCP d’une compagnie aérienne, d’un site de réservation et de votre calendrier. Le potentiel des agents IA explose.

La collaboration entre IA (A2A) : le prochain grand virage

Voici un angle mort souvent négligé : la communication d’Agent à Agent (A2A). Le MCP ne sert pas qu’à connecter une IA à un outil.

Il peut aussi servir à connecter des IA entre elles. Un agent spécialisé en analyse de données pourrait ainsi « discuter » avec un agent spécialisé en rédaction de rapports.

C’est une vision d’un écosystème d’IA collaboratives, chacune avec ses propres compétences, unies par un langage commun : le MCP.

Tout n’est pas rose : les défis et points de vigilance du MCP

L’enthousiasme actuel est palpable, mais il faut savoir garder la tête froide face à la réalité technique. Comme toute nouvelle technologie puissante, le MCP amène inévitablement son lot de questions épineuses et de risques potentiels qu’on ne peut ignorer.

Les failles de sécurité à ne pas prendre à la légère

L’adoption massive cache une réalité technique préoccupante qui mérite votre attention immédiate. Dès avril 2025, des chercheurs en sécurité ont tiré la sonnette d’alarme sur des vulnérabilités critiques identifiées peu après l’annonce de l’adoption par les géants. Ces failles exposent les infrastructures d’entreprise à des menaces concrètes.

- Injection de prompt : Un utilisateur malveillant pourrait manipuler l’IA pour qu’elle utilise des outils connectés de manière non autorisée, contournant les garde-fous habituels.

- Problèmes de permissions : Un outil mal configuré pourrait permettre à l’IA d’accéder à plus de données que prévu, menant souvent à une exfiltration de fichiers sensibles vers l’extérieur.

- Usurpation d’outils : Le risque majeur qu’un logiciel malveillant se fasse passer pour un outil de confiance afin de tromper l’IA et l’utilisateur final.

Le risque de la fragmentation : un standard pour les gouverner tous ?

Le MCP est-il vraiment LE standard universel, ou juste le premier d’une longue série à venir ? L’histoire de la tech est remplie de « guerres de standards » qui finissent souvent mal. On croit tenir la solution miracle, puis la réalité du marché reprend ses droits. C’est un cycle classique.

Le risque réel est que d’autres acteurs majeurs proposent leurs propres protocoles concurrents, recréant ainsi la fragmentation exacte que le MCP cherche à éliminer.

L’adoption officielle par OpenAI et Google est un excellent signal, mais l’écosystème reste jeune et la partie n’est pas encore gagnée.

Gouvernance et contrôle : qui pilote le navire ?

Abordons franchement la question centrale de la gouvernance du projet. Le protocole est certes open-source, mais qui décide réellement de son évolution future ? Qui valide les changements techniques ?

La mise en place d’une structure de gouvernance claire et transparente sera déterminante pour sa pérennité. Il faut une fondation neutre, à l’image de la Linux Foundation, pour rassurer tout le monde. Sans cela, la confiance des entreprises restera fragile.

Le risque évident est qu’Anthropic ou un autre acteur majeur finisse par exercer une influence démesurée sur son développement à long terme.

L’avenir du MCP : simple protocole ou fondation de l’IA de demain ?

Malgré ces défis, la trajectoire du MCP est impressionnante. Alors, où va-t-on à partir de là ? Et quel est le véritable enjeu derrière ce standard ?

L’open-source comme moteur de l’innovation

Le vrai tour de force du MCP réside dans son architecture open-source accessible à tous. N’importe quel développeur peut désormais construire un serveur ou un client sans avoir à demander la permission.

Cette liberté totale encourage une explosion d’innovations « bottom-up » assez surprenante. Des développeurs indépendants créent déjà des serveurs pour des outils de niche, enrichissant l’écosystème à une vitesse folle sans attendre l’aval des géants de la Silicon Valley.

Une telle approche collaborative rend l’écosystème résilient, capable de s’étendre bien plus vite que les alternatives à ChatGPT propriétaires classiques.

Les prochaines étapes pour l’écosystème

Regardons maintenant vers l’avenir proche : quelles sont les priorités absolues pour que le MCP tienne ses promesses ambitieuses et devienne incontournable ?

- Enrichissement des SDK : L’objectif est de fournir des kits de développement encore plus simples et puissants dans davantage de langages, comme Kotlin ou Swift, pour attirer tous les codeurs.

- Standardisation de la sécurité : Il faut impérativement développer des normes de sécurité robustes (gestion des permissions, authentification via OAuth) intégrées au protocole pour rassurer les entreprises frileuses.

- Création d’un registre d’outils : La mise en place d’un répertoire public et fiable de serveurs MCP est prévue pour faciliter leur découverte et leur utilisation massive par la communauté.

Mon avis : pourquoi c’est plus qu’une norme technique

Je vais être franc : le MCP n’est pas juste un détail technique pour développeurs en arrière-boutique. C’est une pièce maîtresse pour bâtir une IA plus ouverte, transparente et utile, loin des écosystèmes fermés qui nous brident souvent.

Ce standard constitue le pont essentiel entre le potentiel abstrait des modèles d’IA et les applications concrètes du monde réel. À mes yeux, c’est sans doute l’une des briques les plus importantes pour l’avenir de notre interaction avec l’IA.

Le MCP n’est pas qu’un simple acronyme technique de plus. C’est le chaînon manquant qui transforme nos IA bavardes en véritables collègues connectés au réel. Malgré quelques défis de sécurité à surveiller, ce standard « USB-C » de l’intelligence artificielle est bien parti pour devenir incontournable. Alors, prêt à brancher vos outils ?

FAQ

Concrètement, c’est quoi le Model Context Protocol (MCP) ?

Imaginez une sorte de « prise universelle » pour l’intelligence artificielle. Le Model Context Protocol (MCP) est un standard open-source, lancé par Anthropic en novembre 2024, qui permet de connecter facilement des assistants IA (comme Claude ou ChatGPT) à vos données et outils externes (fichiers, serveurs, applications). Avant lui, c’était le chaos : il fallait créer un connecteur spécifique pour chaque outil. Aujourd’hui, le MCP agit comme un langage commun qui permet à l’IA de « comprendre » et d’interagir avec votre environnement numérique sans bricolage complexe.

Que signifie l’acronyme MCP et quel est son rôle précis ?

MCP signifie Model Context Protocol. Son rôle est dans le nom : fournir du « contexte » au « modèle ». Au lieu d’avoir une IA isolée qui ne connaît rien de vos projets actuels, le MCP crée un pont sécurisé (via une architecture client-serveur) pour qu’elle puisse lire des documents, interroger une base de données ou exécuter des commandes via des outils standardisés. C’est ce qui transforme un simple chatbot en un véritable assistant capable d’agir sur vos systèmes réels, le tout via un protocole unifié (souvent basé sur JSON-RPC).

Pourquoi parle-t-on du MCP comme du nouveau standard de l’IA ?

On qualifie le MCP de standard car il résout le problème de la fragmentation. Plutôt que d’avoir des intégrations fermées et propriétaires, le MCP est une norme ouverte et interopérable. C’est un peu l’équivalent du port USB-C pour l’intelligence artificielle : peu importe le modèle d’IA (client) ou la source de données (serveur), tant qu’ils parlent « MCP », ils peuvent se connecter. L’adoption rapide par des géants comme OpenAI et Google DeepMind en 2025 confirme que c’est bien la fondation sur laquelle l’avenir des agents IA va se construire.