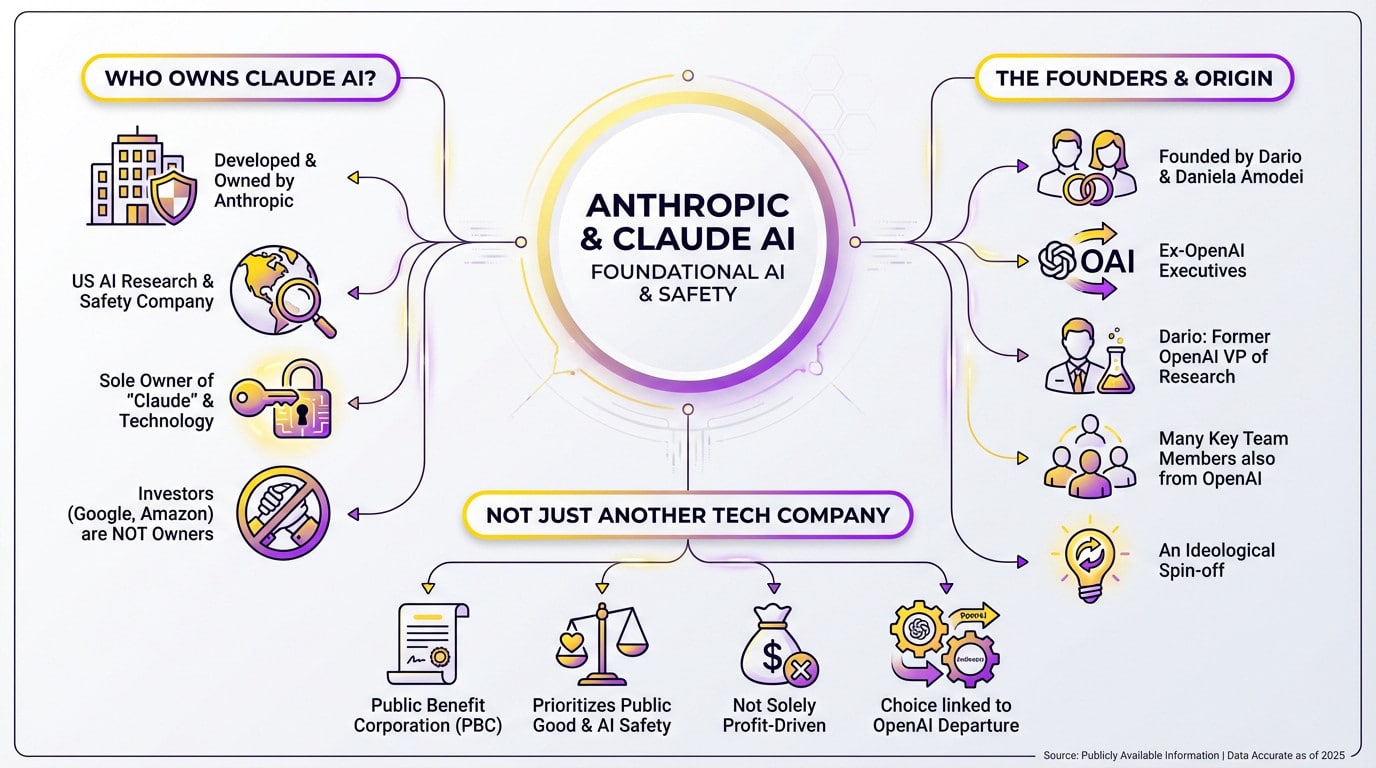

Lo esencial: Claude AI es propiedad exclusiva de Anthropic, una Corporación de Utilidad Pública fundada por antiguos ejecutivos de OpenAI para dar prioridad a la seguridad de la IA. Esta estructura jurídica protege su misión de las presiones lucrativas. Y lo que es más importante, a pesar de los miles de millones de financiación de Amazon y Google, estos gigantes sólo tienen participaciones minoritarias sin ningún control sobre la gobernanza.

Con los enormes cheques que vuelan de Amazon y Google, tienes razón al preguntarte a quién pertenece Claude AI y si no es más que otra marioneta de Big Tech disfrazada. La respuesta nos lleva a Anthropic, una corporación de beneficio público fundada por antiguos ejecutivos de OpenAI que construyeron una fortaleza legal para proteger su misión de seguridad frente a los inversores. Revelamos la configuración específica de gobernanza que impide que estos gigantes tecnológicos tomen nunca el timón, garantizando que la ética siempre tenga prioridad sobre los beneficios trimestrales.

La respuesta directa: Anthropic está detrás de Claude AI

Entonces, ¿quién es el propietario?

Si te preguntas quién es el propietario de claude ai, ésta es la realidad. Está desarrollada y es propiedad en su totalidad de Anthropic, una empresa estadounidense de seguridad e investigación en IA. No existe ninguna confusión al respecto.

Anthropic es el único y exclusivo propietario. Tanto el nombre «Claude» como la tecnología subyacente le pertenecen por completo.

Claro que titanes de la tecnología como Google y Amazon han aportado miles de millones. Pero seamos claros: son inversores minoritarios, no propietarios. Se trata de una gran distinción que la mayoría de la gente pasa por alto.

La gente que lo empezó todo

Los cerebros de la operación son los hermanos Dario Amodei y Daniela Amodei. Llevan las riendas como Consejero Delegado y Presidenta, respectivamente. Su liderazgo define la empresa, y anteriormente fueron altos ejecutivos de otra gran empresa.

Aquí está el truco: estos fundadores desertaron de OpenAI. De hecho, Darío fue Vicepresidente de Investigación allí antes de marcharse. Conocer este linaje cambia tu visión de todo el campo.

No se fueron solos; varios otros miembros clave del equipo también son antiguos alumnos de OpenAI. Se trata efectivamente de una escisión ideológica.

No es una empresa tecnológica más

Anthropic no es una startup al uso: está registrada como Sociedad Anónima de Utilidad Pública (S.A.P.). Este estatus legal es poco frecuente en la gran tecnología. Cambia por completo las reglas del juego.

Esta estructura obliga legalmente a la empresa a dar prioridad a la seguridad de la IA y al bien público. No pueden limitarse a perseguir el máximo beneficio para los accionistas. Obliga a un equilibrio que la mayoría de los competidores ignoran.

Esta elección estructural se deriva directamente de las preocupaciones de seguridad que les llevaron a abandonar OpenAI. Construyeron la jaula antes de hacer crecer a la bestia. Es un movimiento deliberado para evitar un escenario desbocado.

La gran división: Por qué Antrópica se separó de OpenAI

Ahora que sabemos quién está detrás de Claude, la pregunta obvia es: ¿por qué dejar que un gigante como OpenAI empiece de nuevo? La respuesta es una cuestión de principios.

Un desacuerdo fundamental sobre la dirección

Muchos se preguntan a quién pertenece Claude AI esperando un simple nombre corporativo, pero la realidad implica una salida dramática. Dario y Daniela Amodei abandonaron OpenAI debido a una profunda fractura en la visión estratégica. El equipo se alarmó por la dirección de OpenAI tras asociarse con Microsoft, temiendo que la comercialización eclipsara la misión original.

El punto de ruptura no fue el dinero. Fue un enfrentamiento innegociable sobre dar prioridad a la seguridad de la IA por encima de un despliegue rápido.

La filosofía de «la seguridad ante todo

Para los fundadores de Anthropic, la seguridad no es una opción que se parchea después; es el punto de partida. Estructuraron la empresa para evitar que el afán de lucro comprometiera las normas éticas.

Esta convicción es absoluta. Como ellos dicen:

«Para nosotros, construir una IA segura y beneficiosa es la misión en sí misma. No es una casilla que marcar, sino la razón de ser de nuestra empresa».

Esta filosofía impulsó la escisión. Sus principales preocupaciones incluían

- El ritmo de la comercialización supera al de la investigación sobre seguridad.

- Los riesgos de desplegar modelos potentes sin los guardarraíles adecuados.

- La necesidad de una estructura de gobierno que proteja la misión de seguridad de la presión financiera.

Marcar un nuevo rumbo en la historia de la IA

Anthropic no era una startup más; era un intento de construir un modelo alternativo. Crearon una Corporación de Beneficio Público para priorizar legalmente la humanidad sobre los beneficios de los accionistas.

Este movimiento es un momento decisivo en la historia general del desarrollo de la IA. Marca un claro cisma en la forma de construir estas tecnologías, separando a los que persiguen la escala de los obsesionados con el control. Debido a esta división, la industria debe enfrentarse ahora a cuestiones incómodas sobre ética y gobernanza.

Una estructura única para proteger la misión

Tener una bonita declaración de misión está bien. Pero cuando miras quién es el propietario de Claude AI, te das cuenta de que el verdadero reto es hacer que esa misión sobreviva a presiones multimillonarias. Anthropic estableció una estructura de gobierno francamente inusual.

Más que una «Corporación de Utilidad Pública»

En primer lugar, examinemos su condición de Corporación de Utilidad Pública (CBP). Esto no es sólo una pegatina de marketing para quedar bien; es un compromiso jurídico vinculante.

Esto es lo que realmente parece sobre el papel:

- Una misión de interés público claramente declarada.

- El deber de equilibrar las carteras de los accionistas con esa misión.

- Obligación de publicar un informe sobre los resultados sociales.

Para Anthropic, esto significa que la junta tiene la responsabilidad legal de perseguir su misión de seguridad, aunque vaya en contra de maximizar los beneficios a corto plazo. Se trata de una medida poco habitual.

El Fideicomiso de Prestaciones a Largo Plazo: La última salvaguarda

Pero aquí está el verdadero as en la manga: el «Fideicomiso de Prestaciones a Largo Plazo». Se trata de una entidad independiente formada por expertos en seguridad y política pública, al margen del escalafón empresarial habitual.

Este Trust tiene derechos específicos que los accionistas ordinarios no tienen. Lo más importante es que tienen el poder de elegir a una parte específica del consejo de administración de Anthropic.

¿Su función? Actuar a prueba de fallos, asegurándose de que la empresa se mantiene fiel a su misión a largo plazo.

Cómo evita una toma hostil de la Misión

Esta estructura es un cortafuegos. Está diseñada para evitar un escenario en el que los inversores tomen el timón y abandonen la cautela sólo para perseguir mayores márgenes de beneficio.

Es una respuesta directa a lo que percibieron como una dilución de la misión original de OpenAI. Construyeron estos muros legales específicamente para protegerse de ese destino.

Básicamente, el poder del Fideicomiso garantiza que la seguridad de la IA siga siendo la prioridad por encima de todo lo demás.

Siguiendo el Dinero: La inversión no es propiedad

Una estructura ética está muy bien sobre el papel, pero desarrollar una IA de vanguardia cuesta una fortuna. Entonces, ¿de dónde sale realmente el dinero? Y lo que es más importante, ¿quién mueve realmente los hilos financieros detrás del telón?

Los gigantes tecnológicos hacen sus apuestas

Amazon y Google son los protagonistas. Han inyectado miles de millones de dólares directamente en la operación. Es una cantidad asombrosa de capital.

Salesforce también ha dado un paso al frente con un importante capital. Está firmemente involucrada junto con otros grandes patrocinadores.

Estos acuerdos son jugadas puramente estratégicas. Permiten a estos gigantes acceder a los modelos de Anthropic. Les mantiene relevantes en la carrera de la IA. Sin embargo, no llevan el volante.

¿Apuestas minoritarias sin compromiso?

Aclaremos quién posee claude ai en estos momentos: se trata de participaciones estrictamente minoritarias. Ninguno de estos gigantes tecnológicos posee realmente la empresa. Son simples inversores.

Esta entrada masiva de dinero no les compra el control sobre la gobernanza. No pueden dictar la hoja de ruta del producto. Y lo que es más importante, no tienen absolutamente ninguna autoridad sobre las políticas internas de seguridad.

El Consejo y el Fondo de Prestaciones a Largo Plazo conservan el poder de decisión final. Sólo ellos llevan la voz cantante. Ése es el núcleo no negociable de todo el acuerdo.

Propiedad vs. Inversión: Una distinción clara

Mientras el dinero fluye desde Big Tech, las llaves del reino permanecen en Anthropic. La propiedad y el control permanecen totalmente separados. Es un cortafuegos.

| Papel | Actores clave | Nivel de control |

|---|---|---|

| Propiedad y desarrollo | PBC Antrópico | Control total: Control total sobre el código fuente, la marca, la hoja de ruta del producto, las políticas de seguridad y la gobernanza. |

| Grandes inversiones financieras | Amazon, Google, etc. | Participación minoritaria / Sin control: Importante respaldo financiero y asociación en la nube, pero sin puestos en el consejo ni voz en la dirección de la empresa. |

| Gobernanza ética | Fideicomiso de prestaciones a largo plazo | Poder de veto y supervisión: Puede elegir a los miembros del consejo para garantizar que la empresa se adhiere a su misión de seguridad ante todo, actuando como control final de las decisiones corporativas. |

IA constitucional: la «salsa secreta» de Claude

Ya hemos hablado del dinero y de quién es el propietario de Claude AI-Anthropic. Pero técnicamente, ¿qué hace que su enfoque sea tan diferente? Todo gira en torno a un concepto que han denominado «IA Constitucional».

¿Qué es la IA constitucional?

Es un método inteligente para entrenar a la IA a comportarse de forma segura. Elimina la necesidad de supervisión humana constante en cada paso. Piensa en ello como una moralidad automatizada.

El objetivo es dar a la IA un conjunto de principios a seguir, muy parecido a una constitución nacional, para que pueda autocorregirse y alinearse con los valores humanos.

Esta «constitución» es un conjunto específico de normas y principios. Se basa en gran medida en fuentes importantes como la Declaración Universal de los Derechos Humanos. El modelo debe respetar estrictamente estas directrices.

Cómo funciona en la práctica

El proceso técnico se desarrolla en dos fases distintas. En primer lugar, el modelo aprende a criticar sus propias respuestas iniciales. Las revisa para que se ajusten estrictamente a la constitución. Esto crea un bucle de retroalimentación sin el habitual agotamiento humano.

- Fase supervisada: La IA genera respuestas, luego las critica y las reescribe basándose en los principios constitucionales.

- Fase de aprendizaje por refuerzo: La IA se entrena con estas respuestas autocorregidas, aprendiendo a preferir las salidas útiles e inofensivas desde el principio.

El objetivo final: una IA más predecible y segura

El objetivo final es hacer que el comportamiento de la IA sea transparente. Queremos evitar que se descarrile. Esto hace que el sistema sea mucho menos propenso a derivas peligrosas.

Al basarse en principios explícitos y no en preferencias implícitas, Anthropic construye mejores modelos. Evitan el desorden de los vagos sentimientos humanos. El resultado es un modelo mucho más sólido y alineado.

Es su respuesta técnica al problema de la seguridad y la alineación. No es sólo marketing; es ingeniería.

Claude en la Arena: Cómo se distingue lo antrópico

El competidor con principios

Cuando indagas sobre quién es el propietario de claude ai, te encuentras con Anthropic, una empresa creada por antiguos ejecutivos de OpenAI como Dario Amodei. No compiten simplemente por construir el modelo más grande. Su principal argumento de venta es la seguridad y la fiabilidad.

Mientras sus competidores hablan de especificaciones en bruto, Anthropic habla de previsibilidad. Se centran mucho en la alineación ética. Es un cambio claro e intencionado en sus prioridades.

Es una apuesta masiva. Creen que el mercado acabará valorando la seguridad tanto como el rendimiento.

Un enfoque diferente de la carrera de la IA

Esta filosofía impregna todo lo que hace la empresa. Dicta cómo se dirigen al público. Incluso controla exactamente cómo lanzan sus modelos.

Actualmente, la industria corre hacia la línea de meta. Anthropic actúa como un freno necesario, instando a la cautela en la búsqueda de la inteligencia general artificial. Sirve de contrapunto vital y distinto.

No sólo quieren ganar. Quieren ganar la carrera de la forma correcta.

Qué significa esto para usuarios y desarrolladores

Para ti, esto cambia la interacción diaria. Consigues una IA menos propensa a escupir basura tóxica. Sencillamente, es más seguro utilizarla.

Los desarrolladores que utilizan la API obtienen un beneficio enorme. Duermen mejor por la noche. Se preocupan mucho menos de que sus aplicaciones de repente se vuelvan ilegales.

Elegir esta herramienta es una declaración. No sólo eliges tecnología, sino que te alineas con una filosofía de desarrollo responsable de la IA. En última instancia, importa quién es el propietario del código.

En última instancia, Claude AI pertenece únicamente a Anthropic, no a los gigantes tecnológicos que extienden los cheques. Al dar prioridad a la seguridad mediante una estructura corporativa única, los hermanos Amodei se aseguran de que su misión sobreviva al bombo publicitario. Está por ver si este enfoque ético gana la carrera, pero al menos sabemos quién conduce realmente.