La conclusión esencial: la IA en el borde ejecuta el aprendizaje automático directamente en los dispositivos locales en lugar de depender de servidores en la nube distantes. Al analizar los datos donde se crean, esta tecnología elimina el retraso y mejora significativamente la privacidad. Permite que los dispositivos inteligentes y los vehículos autónomos tomen decisiones en fracciones de segundo de forma independiente, lo que garantiza la fiabilidad incluso cuando se interrumpe la conexión a Internet.

¿Alguna vez se ha preguntado por qué su hogar inteligente a veces se siente un poco lento o le preocupa que sus grabaciones privadas viajen a través de la web para su análisis? Ese es precisamente el problema que soluciona la IA en el borde al trasladar la inteligencia de los centros de datos remotos directamente a sus dispositivos locales para su procesamiento inmediato. Vamos a explorar cómo este enfoque local otorga a sus dispositivos electrónicos poderes de toma de decisiones casi instantáneos y por qué es la mejor opción para mantener sus datos confidenciales bajo su propio control.

¿Qué es la IA en el borde de todos modos?

Vamos a cortar por lo sano. La IA en el borde no es solo otra palabra de moda; es un cambio fundamental en el lugar donde las máquinas piensan, trasladando la inteligencia de los servidores distantes directamente a su mano.

Definición de la IA en el borde de la red

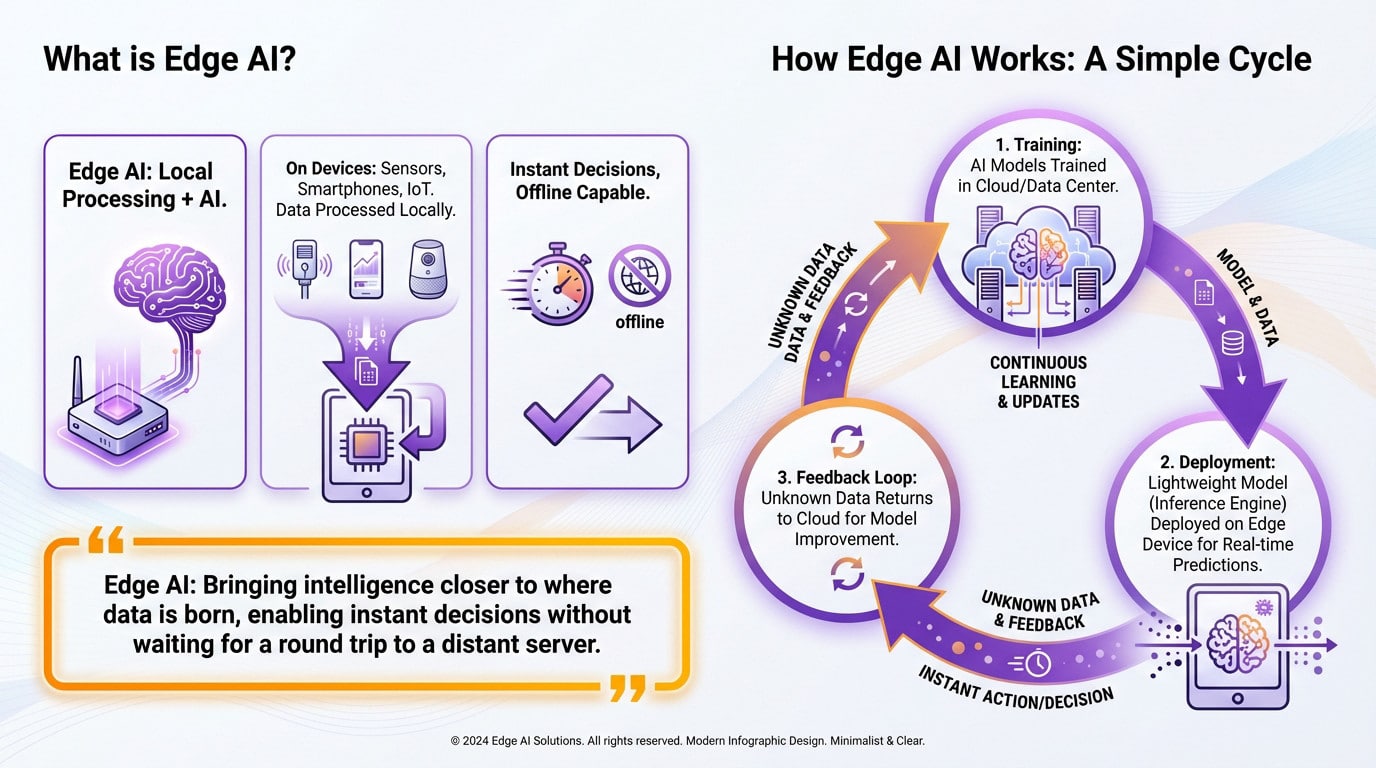

En esencia, esta tecnología es simplemente la unión de la computación en el borde y la inteligencia artificial. El concepto es sencillo: las operaciones matemáticas pesadas se realizan localmente en el dispositivo, no en la nube. Deje de subcontratar el pensamiento.

Estamos hablando de ejecutar la inteligencia directamente en sensores, teléfonos inteligentes y dispositivos IoT. Esta configuración le permite procesar los datos localmente, justo en la fuente donde realmente se generan, sin necesidad de un largo viaje a un servidor remoto. La acción se queda aquí.

El resultado es una toma de decisiones en fracciones de segundo que funciona perfectamente, incluso cuando se cae Internet.

Cómo funciona realmente: un ciclo simple

Comienza con el trabajo pesado llamado entrenamiento. Las redes neuronales masivas aprenden de montañas de datos, generalmente dentro de una potente infraestructura en la nube o un centro de datos centralizado.

Una vez que el cerebro es lo suficientemente inteligente, lo reducimos. Una versión ligera, el motor de inferencia, se implementa directamente en su dispositivo en el borde. Ahora, hace predicciones en tiempo real sin llamar a casa.

Si el dispositivo ve algo raro que no reconoce, lo marca. Esos datos específicos vuelven a la nube para hacer que el modelo sea más inteligente.

La idea central en pocas palabras

Piense en una cámara de seguridad. En lugar de transmitir horas de metraje vacío del pasillo a la nube, una cámara con IA en el borde detecta al intruso y solo envía la alerta. Es más rápido y, francamente, mucho más privado.

La IA en el borde no se trata de reemplazar la nube; se trata de acercar la inteligencia a donde nacen los datos, permitiendo decisiones instantáneas sin esperar un viaje de ida y vuelta a un servidor distante.

Borde vs. Nube: una asociación, no una lucha

Ahora que tenemos lo básico, vamos a acabar con un mito común ahora mismo: La IA en el borde no está aquí para reemplazar la nube. En realidad, son solo dos caras de la misma moneda.

Comprender sus distintos roles

Piense en la IA en la nube como el gimnasio. Tiene una enorme potencia de cálculo y almacenamiento, lo cual es absolutamente necesario para entrenar modelos complejos utilizando terabytes de datos. Es donde se realiza el trabajo pesado para construir el cerebro.

Por otro lado, tenemos la IA en el borde. Este es el campo de juego. Se centra por completo en la inferencia en tiempo real, aplicando ese modelo entrenado para hacer predicciones rápidas directamente en el dispositivo, exactamente donde está sucediendo la acción.

Una historia de dos IA: una comparación directa

Puede que se pregunte cómo se comparan entre sí. Esta tabla visualiza las fortalezas y debilidades específicas de cada enfoque, para que pueda ver exactamente dónde difieren.

| Función | Edge AI | Cloud AI |

|---|---|---|

| Latencia | Baja (milisegundos, procesamiento en el dispositivo) | Alta (depende de la conexión de red a los servidores remotos) |

| Ancho de banda de la red | Bajo (transmisión mínima de datos) | Alto (requiere carga/descarga constante de datos) |

| Potencia de cálculo | Limitada (limitada por el hardware del dispositivo) | Virtualmente ilimitada (acceso a centros de datos masivos) |

| Privacidad y seguridad de los datos | Alta (datos procesados y almacenados localmente) | Más baja (datos confidenciales transmitidos a través de la red) |

| Capacidad sin conexión | Sí (puede funcionar sin conexión a Internet) | No (requiere conectividad constante) |

La arquitectura híbrida: mejor juntos

El enfoque más inteligente suele ser uno híbrido. La nube gestiona el entrenamiento pesado y el reentrenamiento de los modelos, mientras que el borde gestiona la ejecución rápida y diaria de las tareas. Funciona porque cada uno hace lo que mejor sabe hacer.

Imagínese a un jefe de cocina creando una receta compleja; esa es la nube. Luego tiene al cocinero de línea, el borde, ejecutando esa receta perfectamente y rápidamente en la cocina.

Esta sinergia entre el borde y la nube es la piedra angular de muchas aplicaciones modernas. Desde los coches autónomos hasta las fábricas inteligentes, todos dependen de esta asociación.

Las ventajas del mundo real: por qué debería importarle

Respuesta instantánea: eliminar la latencia

La latencia es el enemigo absoluto de las aplicaciones críticas. Es simplemente el retraso entre la recopilación de datos y la obtención de una respuesta. La IA en el borde elimina este retraso al procesar los números directamente en el lugar. La velocidad lo es todo aquí.

Tome un coche autónomo; no puede esperar a que los servidores en la nube decidan cuándo frenar. Esa decisión debe ser inmediata para evitar un choque. Este análisis en tiempo real es vital, al igual que la necesidad de reducir la latencia en los almacenes inteligentes.

Sus datos se quedan con usted: una victoria para la privacidad

Seamos honestos sobre los riesgos de privacidad hoy en día. Enviar datos personales a servidores externos distantes siempre conlleva un riesgo de seguridad masivo. Afortunadamente, la IA en el borde cambia por completo este peligroso juego.

Al procesar información confidencial, como las grabaciones de cámaras de seguridad o las estadísticas de salud, localmente, minimizamos drásticamente la exposición. Usted mantiene el control sobre lo que más importa. La privacidad de los datos se refuerza de forma nativa sin ningún esfuerzo adicional por parte de los usuarios.

Con la IA en el borde, la información confidencial no necesita viajar. Se analiza donde se crea, lo que reduce significativamente la superficie de ataque para las violaciones de datos y mejora la confianza del usuario.

Las ventajas principales de un vistazo

Las ventajas son múltiples y se refuerzan mutuamente de forma excelente. Esto crea un ecosistema potente y eficiente.

- Latencia reducida: para respuestas en tiempo real y retroalimentación inmediata.

- Privacidad de datos mejorada: al procesar los datos confidenciales en el dispositivo en lugar de enviarlos a la nube.

- Menor uso de ancho de banda: reduce drásticamente la cantidad de datos que deben transmitirse, lo que también reduce los costes.

- Fiabilidad mejorada: las aplicaciones pueden funcionar incluso con una conexión a Internet inestable o inexistente.

- Mejor escalabilidad: añadir nuevos dispositivos no aumenta proporcionalmente la carga en los recursos centrales de la nube.

La IA en el borde en acción: desde su hogar hasta la fábrica

Basta de teoría. Veamos dónde está causando sensación esta tecnología. Le sorprendería ver cuánta IA en el borde ya está presente a nuestro alrededor.

Dispositivos inteligentes que se vuelven más inteligentes

Piense en su sala de estar ahora mismo. Los asistentes de voz responden al instante porque procesan el audio localmente, no en un servidor distante. Los timbres de vídeo reconocen rostros sin subir la transmisión. Incluso los termostatos inteligentes aprenden sus hábitos diarios para ajustar la calefacción antes de que entre.

Se vuelve personal con la tecnología de la salud. Los dispositivos portátiles como los relojes inteligentes analizan su frecuencia cardíaca continuamente en su muñeca. Si detectan una caída repentina, alertan a los servicios de emergencia de inmediato. Hacen este trabajo que salva vidas incluso sin necesidad de una conexión a Internet activa.

Transformación de industrias clave

Ahora, mire la fábrica. Aquí es donde el mantenimiento predictivo ahorra mucho dinero. Los sensores conectados a las máquinas analizan las vibraciones y las temperaturas en tiempo real. Detectan una avería días antes de que ocurra, evitando costosos tiempos de inactividad sin esperar a que un humano lo compruebe.

El comercio minorista también se está poniendo al día rápidamente. Los carros inteligentes escanean sus compras a medida que las deja caer, omitiendo por completo la fila de pago. Las cámaras analizan el flujo de clientes para ayudar a los gerentes a organizar mejor los pasillos. Para descubrir otros casos de uso, puede explorar nuestro blog de IA.

El futuro de la movilidad y la seguridad

Los coches autónomos son la prueba definitiva aquí. Un vehículo debe tomar cientos de decisiones en fracciones de segundo basadas en los datos de los sensores. Depender de una conexión lenta a la nube aquí no es solo molesto. Es imposible sin un procesamiento de IA integrado ultrarrápido.

Finalmente, considere los sistemas de seguridad modernos. La visión artificial avanzada en las cámaras puede detectar comportamientos sospechosos en tiempo real. Procesan la transmisión localmente en lugar de obstruir la red. Esto evita enviar horas de metraje de vídeo inútil a un servidor solo para no encontrar nada.

Los entresijos: implementación de la IA en dispositivos diminutos

Suena genial sobre el papel, pero ¿cómo se mete realmente un cerebro digital masivo en un chip del tamaño de una uña? Ahí es donde comienza el verdadero dolor de cabeza de la ingeniería.

El desafío de los recursos limitados

No puede simplemente arrastrar y soltar un modelo masivo en la nube en un termostato. Estos dispositivos en el borde tienen baterías diminutas y memoria limitada en comparación con una granja de servidores. Es como intentar aparcar un camión semirremolque en un lugar compacto. El hardware simplemente se niega a cooperar.

Por lo tanto, los ingenieros tienen que reducir estos modelos de IA sin hacerlos estúpidos. Se convierte en un acto de equilibrio de alto riesgo entre velocidad y precisión. Si corta demasiado, el sistema no reconoce nada útil.

Hacer que los modelos sean más pequeños y rápidos

Aquí es donde ocurre la magia, específicamente a través de dos técnicas principales. Usamos la poda para recortar las conexiones inútiles, como si se tratara de un árbol bonsái. Luego está la cuantificación, que obliga a las matemáticas a usar números más simples. Hace que el trabajo pesado sea manejable.

El resultado final es un modelo ligero, «ligero», listo para la acción. Se ejecuta rápidamente en hardware especializado como NPU o GPU integradas que se encuentran en los chips modernos. Esto permite que la IA en el borde procese los datos al instante sin retrasarse. La velocidad es la única moneda aquí.

Herramientas del oficio para desarrolladores

Afortunadamente, los desarrolladores no tienen que codificar esto desde cero. Hay todo un arsenal de herramientas esperándolos.

Puede que le sorprenda lo accesibles que se han vuelto estos marcos para los ingenieros. En lugar de reinventar la rueda, confían en ecosistemas establecidos para manejar el trabajo pesado de la optimización y la implementación en hardware específico.

- TensorFlow Lite & PyTorch Mobile: Versiones ligeras de marcos de IA populares, diseñadas específicamente para dispositivos móviles e integrados.

- MediaPipe: un marco de Google para construir canalizaciones de ML aplicadas multimodales multiplataforma.

- Edge AI Studio / LiteRT: Kits de herramientas específicos de fabricantes de hardware (como Texas Instruments) para optimizar los modelos para sus chips.

- Keras & JAX: API y bibliotecas de alto nivel que ayudan a construir y entrenar modelos que luego se pueden convertir para la implementación en el borde.

La IA en el borde no es solo una palabra de moda; está remodelando la forma en que nuestros dispositivos «piensan». Al trasladar la inteligencia de los servidores distantes al dispositivo en su mano, ganamos velocidad, privacidad y fiabilidad. La nube no va a desaparecer, pero el futuro está claramente sucediendo aquí mismo, en el borde: tostadoras inteligentes y todo.