Lo esencial: La Inteligencia Artificial comenzó oficialmente en 1956 en el Proyecto de Verano de Dartmouth, donde se acuñó el término para distinguirla de la cibernética. Esta fecha de fundación es importante porque enmarca los potentes modelos generativos actuales no como magia repentina, sino como el resultado de una evolución de casi 70 años que comenzó con un simple taller de verano.

¿Te has preguntado alguna vez cuándo se inventó exactamente la inteligencia artificial, suponiendo que debe de ser una creación reciente nacida de los modernos valles del silicio? La realidad es mucho más sorprendente, ya que el nacimiento oficial de la inteligencia artificial se remonta a un audaz taller de verano de 1956 en el que unos cuantos visionarios se atrevieron a soñar con máquinas pensantes. Exploraremos este momento decisivo y la montaña rusa de la historia que le siguió, llevándote desde aquellas primeras pruebas de lógica simbólica directamente a las potentes redes neuronales que definen actualmente nuestras vidas digitales.

El año en que la IA obtuvo su nombre y una misión

Probablemente estás aquí porque quieres una respuesta directa a la pregunta: ¿cuándo se inventó el ai? Ahora no necesitas una historia de la filosofía antigua. La fecha oficial de nacimiento de la Inteligencia Artificial como disciplina científica es 1956, y ocurrió en un acontecimiento concreto en Hanover, New Hampshire.

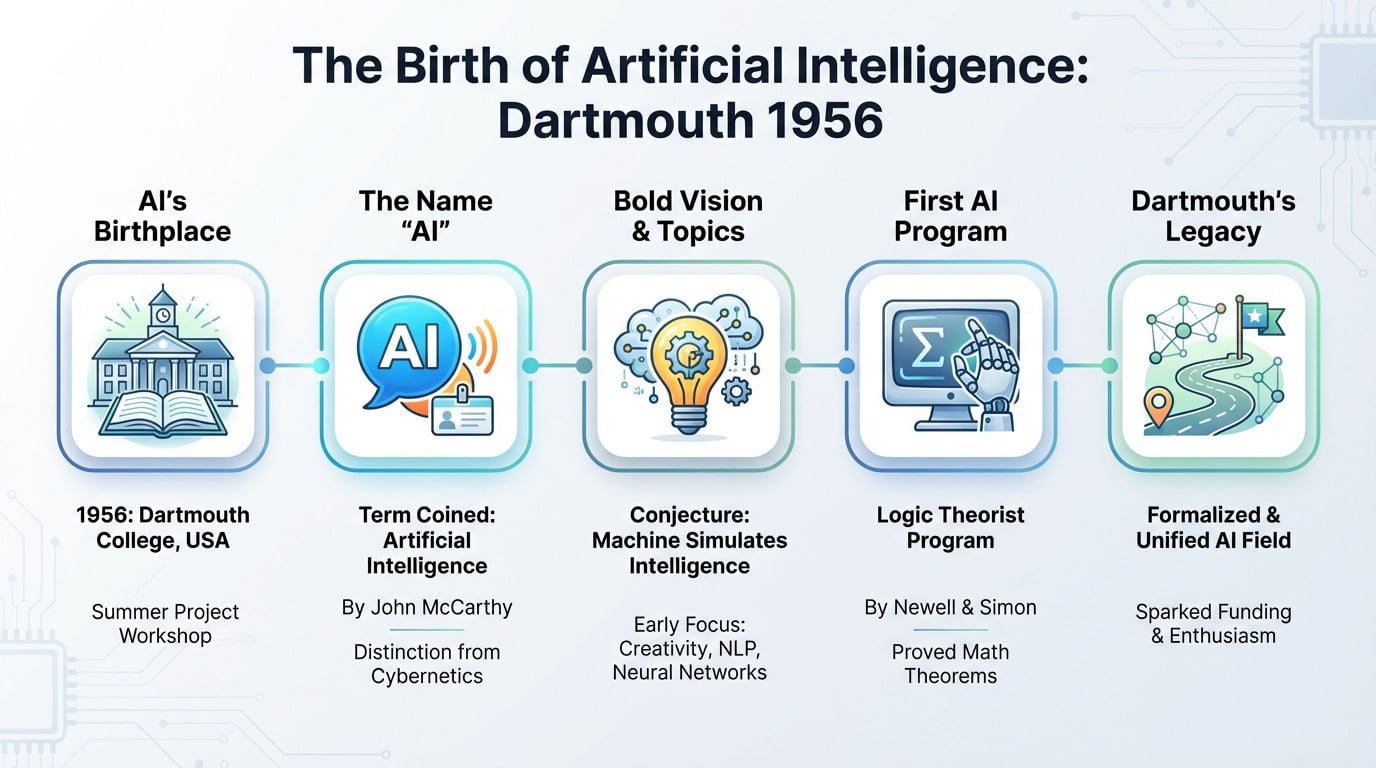

1956: El Proyecto de Verano de Dartmouth

Si quieres la partida de nacimiento oficial, no busques más allá de 1956, el año en que todo cambió. Aquel verano tuvo lugar un taller crucial en el Dartmouth College de New Hampshire. No se trataba de una gala multitudinaria, sino de un proyecto de investigación de verano.

Aquí es exactamente donde se inventó el término «Inteligencia Artificial«. John McCarthy lo eligió específicamente para evitar la confusión con «cibernética», que era la palabra de moda por aquel entonces.

Cuatro pesos pesados organizaron esto: John McCarthy (el del nombre), Marvin Minsky, Nathaniel Rochester y Claude Shannon. Reunieron a las mentes más brillantes en una sesión de intercambio de ideas que duró dos meses. Fue básicamente la «Convención Constitucional» de las máquinas inteligentes.

La audaz propuesta que lo empezó todo

La propuesta era audaz y se basaba en la conjetura de que «cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, describirse con tanta precisión que se puede hacer que una máquina lo simule«.

Hablando de exceso de confianza. Creían sinceramente que un pequeño grupo de científicos podría hacer mella en estos problemas durante un solo verano.

No pensaban en pequeño, ya que enumeraban temas como la creatividad, el procesamiento del lenguaje natural y las redes neuronales. Es increíble darse cuenta de que los principales temas de la IA moderna ya estaban sobre la mesa. Trazaron el territorio que seguimos explorando hoy.

Quién estaba allí: Los Padres Fundadores

Mientras muchos venían a hablar, Allen Newell y Herbert A. Simon venían a presumir. Llegaron con algo que los demás no tenían: un programa en funcionamiento llamado Teórico Lógico. Fue el momento en que la sala dejó de teorizar.

El Teórico de la Lógica era capaz de demostrar teoremas matemáticos de Principia Mathematica. Como imitaba el razonamiento humano para resolver problemas, se le considera el primer programa de IA real.

Su demostración cambió por completo la onda de la filosofía abstracta a la ingeniería práctica. Demostraron que las máquinas inteligentes ya no eran sólo ciencia ficción. Era real y funcionaba en un ordenador.

Por qué Dartmouth fue una línea de salida, no de llegada

Para ser justos, Dartmouth no «inventó» el concepto de cero absoluto. En cambio, el acontecimiento formalizó y bautizó un campo de investigación que había estado bullendo en artículos dispersos. Dio identidad a la disciplina.

Piénsalo de este modo: fue el momento en que un grupo de músicos solistas decidieron formar una orquesta y ponerle por fin un nombre.

Y lo que es más importante, la conferencia desencadenó una oleada masiva de financiación y entusiasmo. Proporcionó una hoja de ruta y una etiqueta unificada para una comunidad científica naciente. Sin esta reunión, quizá seguiríamos llamándolo «procesamiento complejo de la información».

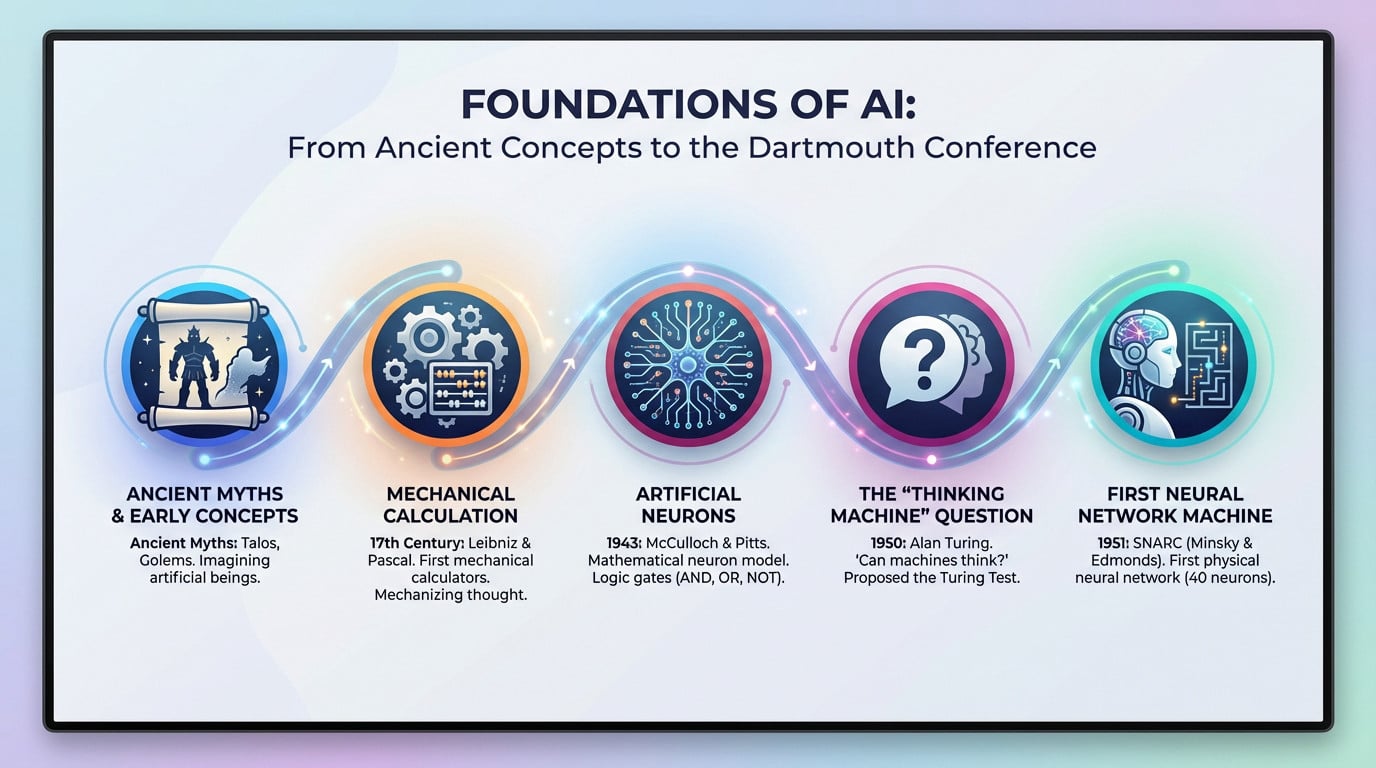

Los fantasmas intelectuales que atormentaron a Dartmouth

Pero mucho antes de que existiera el nombre de «IA», las ideas ya brotaban en las mentes de los atípicos. Los participantes de Dartmouth no partieron de una página en blanco, sino que se apoyaron en los hombros de unos cuantos gigantes que se atrevieron a preguntar si el metal podía pensar.

Alan Turing y la cuestión de la «máquina pensante

No se puede hablar de IA sin hacer una reverencia a Alan Turing, el verdadero profeta de esta era. En 1950, publicó un artículo bomba titulado «Computing Machinery and Intelligence». Básicamente predijo toda la industria antes incluso de que empezara.

Hizo una pregunta sencilla y aterradora: «¿Pueden pensar las máquinas?» Para evitar enredarse en interminables debates filosóficos sobre el alma, propuso en su lugar una prueba práctica.

Lo llamamos el Test de Turing, o el Juego de la Imitación. Una máquina tiene éxito si un humano no puede determinar si está hablando con una máquina o con otro humano. Era una forma pragmática de definir la inteligencia.

Las primeras neuronas artificiales: McCulloch y Pitts

Rebobinemos aún más hasta 1943. Warren McCulloch, neurocientífico, se asoció con Walter Pitts, lógico. Su trabajo es la base absoluta de toda la corriente «conexionista» de la IA.

Crearon un modelo matemático de una neurona biológica. Demostraron que las redes de estas «neuronas artificiales» podían realizar funciones lógicas básicas como Y, O y NO. Era la primera vez que la lógica se encontraba con la biología.

Fue la primera vez que alguien estableció un vínculo formal entre la biología del cerebro y la lógica del cálculo.

De los antiguos mitos a las máquinas de calcular

La gente suele preguntar cuándo se inventó el ai, buscando una fecha concreta en un calendario. Debemos reconocer primero los antiguos mitos griegos de autómatas como Talos o los Golems.

Pero seamos claros: esos mitos eran historias, no ciencia. El verdadero trabajo conceptual empezó con filósofos como Leibniz y Pascal, que construyeron las primeras máquinas de calcular mecánicas. Convirtieron las matemáticas abstractas en engranajes físicos.

Estas máquinas demostraron que un proceso «mental» como el cálculo podía mecanizarse. Se trata de un paso conceptual fundamental necesario para imaginar la inteligencia artificial. Cambió nuestra perspectiva sobre lo que las máquinas podían hacer realmente.

SNARC: La primera máquina de redes neuronales

Luego llegó el SNARC (Stochastic Neural Analog Reinforcement Calculator), construido en 1951. Es la primera máquina física construida para simular una red neuronal. Era hardware, no sólo teoría.

Marvin Minsky y Dean Edmonds lo construyeron cuando aún eran estudiantes. El SNARC simulaba una rata aprendiendo a salir de un laberinto, utilizando 40 «neuronas» conectadas. Fue un experimento desordenado y brillante.

Era una prueba de concepto. Podíamos pasar de la teoría de las neuronas artificiales a una máquina real que aprende.

Los Años Dorados: Una época de optimismo desenfrenado (1956-1974)

Si indagas en cuándo se inventó el ai, la cronología se solidifica aquí. El arranque de Dartmouth liberó una energía loca. Durante casi veinte años, los investigadores de IA, armados con financiación y una confianza a prueba de balas, creyeron que todo era posible.

Resolver problemas como un humano… o eso creían

Los primeros pioneros apostaron la casa por el razonamiento simbólico. Supusieron que el pensamiento humano no era más que manipular símbolos, como el álgebra para la mente. Parecía lógico en aquella época.

Por ejemplo, el Solucionador General de Problemas (GPS) de Newell y Simon. Diseñaron esta bestia para resolver absolutamente cualquier problema formal.

El método era rudimentario: exploraba todas las soluciones posibles mediante una «búsqueda por fuerza bruta». Esto funcionaba bien para rompecabezas lógicos sencillos como las Torres de Hanoi. ¿Pero para problemas complicados del mundo real? Se topaba inmediatamente con un muro de ladrillos.

ELIZA: El chatbot que engañó a la gente

Luego llegó ELIZA, programado por Joseph Weizenbaum en 1966. Fue uno de los primeros intentos de procesamiento del lenguaje natural, básicamente un chatbot antes de que existiera el término.

ELIZA imitaba a un psicoterapeuta rogeriano. No entendía nada de contexto y se basaba exclusivamente en trucos de reconocimiento de palabras clave para reformular tus propias palabras. Si tecleabas «madre», te escupía una pregunta precocinada sobre tu familia para que siguieras hablando.

Sin embargo, los usuarios cayeron en la trampa. Lo llamamos el «efecto ELIZA»: la gentese vinculó emocionalmente con un guión que sabía que era falso.

Micromundos: Construir inteligencia en una caja

La vida real es caótica, así que los investigadores se refugiaron en «micromundos». Se trataba de entornos virtuales simplificados en los que las reglas eran estrictas y las variables limitadas. Era mucho más seguro construir inteligencia allí.

SHRDLU (1972) de Terry Winograd es el ejemplo clásico. Presentaba un brazo robótico virtual que manipulaba formas en un «mundo de bloques». Podías decirle que moviera un cono verde, y realmente entendía la física.

Era impresionante porque SHRDLU manejaba órdenes complejas de lenguaje natural. «Pon la pirámide azul en el bloque» funcionó de verdad. Parecía una integración masiva de visión y lógica.

El inminente problema de la escala

Pero un monstruo estaba esperando: la explosión combinatoria. Los métodos simbólicos de la época simplemente no se ampliaban. Lo que funcionaba en el laboratorio fracasaba estrepitosamente fuera de él.

Resolver un puzzle de 10 piezas es trivial. Pero inténtalo con un millón de piezas, y el número de combinaciones posibles se vuelve astronómico al instante.

El éxito en los «micromundos» resultó ser un espejismo. Las grandes promesas hechas a financiadores como DARPA empezaron a sonar huecas. El flujo de dinero se detuvo, preparando el escenario para una brutal prueba de realidad que congelaría el progreso durante años.

El Primer Invierno de la IA: Cuando se acabó el dinero (1974-1980)

Después de la fiesta, la resaca. El optimismo inicial se estrelló contra el muro de la realidad, y los financiadores empezaron a cerrar los grifos.

El Informe Lighthill: Un veredicto condenatorio

En 1973, el gobierno británico encargó el Informe Lighthill para ver si su inversión iba realmente a alguna parte. Se suponía que era una revisión rutinaria, pero se convirtió en una autopsia del estado actual de la investigación.

Sir James Lighthill no se anduvo con rodeos. Afirmó que la IA no había cumplido ni una sola de sus grandes promesas, reduciendo los «éxitos» de este campo a meros juguetes de laboratorio incapaces de resolver los problemas del mundo real. Criticó salvajemente el fracaso total de la ampliación.

Las consecuencias fueron brutales e inmediatas. El gobierno del Reino Unido recortó drásticamente los presupuestos para la investigación de la IA, acabando de hecho con la disciplina en el país.

DARPA se impacienta en EE.UU.

Al otro lado del Atlántico, la DARPA (Agencia de Proyectos de Investigación Avanzada de Defensa) era el principal monedero de la innovación estadounidense. Pero no dirigían una organización benéfica; tenían expectativas muy específicas y concretas para sus dólares.

La paciencia se agotó. La agencia se cansó de financiar proyectos académicos indefinidos que no ofrecían ninguna aplicación militar clara ni utilidad práctica en un futuro próximo.

Carnegie Mellon lo descubrió por las malas cuando se suprimió la financiación de su programa de reconocimiento de voz. DARPA tiró del enchufe, redirigiendo millones hacia objetivos específicos como los sistemas de gestión de batallas, dejando a muchos laboratorios generales de IA hambrientos de recursos.

La maldición de la complejidad computacional

Aquí está el asesino técnico: la «explosión combinatoria». Los primeros programas de IA eran matemáticamente intratables. Esto significa que añadir sólo un poco más de datos a un problema no sólo duplicaba el trabajo, sino que requería un aumento exponencial de la potencia de procesamiento.

Los pioneros se habían topado con un muro fundamental. Sus brillantes ideas eran sencillamente demasiado exigentes para los ordenadores de los años 70, que tenían menos potencia que una calculadora moderna.

El hardware simplemente no estaba preparado para la ambición. Los algoritmos estaban demasiado hambrientos, y los ordenadores eran demasiado lentos y caros. Era un callejón sin salida tecnológico.

Un campo en desorden

El ambiente se volvió tóxico.«Inteligencia Artificial» se convirtió en una frase tabú en los pasillos académicos. Si querías conseguir una subvención, no utilizabas el nombre; era un billete de ida al rechazo.

Para sobrevivir, los investigadores cambiaron el nombre del trabajo de su vida. De repente, eran expertos en «aprendizaje automático», «reconocimiento de patrones» o «sistemas basados en el conocimiento». Era un camuflaje necesario para mantener las luces encendidas.

Sin embargo, este duro invierno obligó a una limpieza. Empujó al campo… a ser más riguroso, matemático y menos dependiente de la narrativa de ciencia ficción.

El boom de los 80: la IA se pone un traje de negocios

Entra en los sistemas expertos

Hablemos de los Sistemas Expertos. A diferencia de los amplios sueños de ciencia ficción de los años 50, estos programas se diseñaron para imitar las capacidades específicas de toma de decisiones de un especialista humano en un carril muy estrecho.

He aquí el cambio: en lugar de intentar resolver todos los problemas bajo el sol, se centraron intensamente en una única tarea bien definida. No pensaron con amplitud, sino que ejecutaron con estrechez.

Bajo el capó, la arquitectura se apoyaba en dos pilares: una base de conocimientos llena de miles de reglas «si-entonces» codificadas por humanos, y un motor de inferencia, un programa que aplicaba esas reglas a los datos para llegar a una conclusión lógica.

Del laboratorio a la fábrica

Por fin se puso en marcha la aplicación en el mundo real. Vimos a MYCIN diagnosticar infecciones sanguíneas con una precisión impresionante, y a XCON configurar complejos pedidos informáticos para Digital Equipment Corporation sin sudar.

El dinero empezó a hablar. Al parecer, XCON ahorró a DEC millones de dólares anuales al reducir los errores de configuración. De repente, la IA no era sólo un experimento científico, sino un activo empresarial serio y generador de beneficios.

Este éxito desencadenó una oleada de inversiones masivas. Surgieron empresas de hardware especializadas, como Symbolics y Lisp Machines, que vendían costosas estaciones de trabajo sólo para ejecutar este tipo específico de código.

Historia de dos IAs: Una comparación

Para entender el cambio, observa cómo evolucionó el paradigma. Si preguntas cuándo se inventó el ai, la respuesta cambia según el método utilizado.

| Función | IA Simbólica (Época Dorada) | Sistemas Expertos (Boom de los 80) | Conexionismo (Era Moderna) |

|---|---|---|---|

| Idea central | La inteligencia como manipulación de símbolos. | Captura y reproduce el conocimiento experto humano. | La inteligencia surge de unidades simples e interconectadas (neuronas). |

| Método | Lógica, reglas y algoritmos de búsqueda (por ejemplo, GPS). | Bases de reglas «SI-ENTONCES» elaboradas a mano. | Aprendizaje a partir de datos (entrenamiento de redes neuronales). |

| Puntos fuertes | Bueno para problemas lógicos bien definidos (puzzles, juegos). | Alto rendimiento en un dominio muy limitado. | Excelente para el reconocimiento de patrones (imágenes, sonido, texto). |

| Debilidad clave | Frágil, falla con la incertidumbre, no escala. | La adquisición de conocimientos es un cuello de botella; no puede aprender. | Naturaleza de «caja negra», requiere cantidades masivas de datos. |

La fragilidad del conocimiento codificado a mano

Pero había un gran inconveniente: la fragilidad. Estos sistemas eran increíblemente frágiles. Si se encontraban con una situación que se saliera mínimamente de sus reglas preprogramadas, no sólo adivinaban, sino que fallaban por completo.

Piensa en un cocinero que sólo puede seguir una receta. Si les falta un ingrediente, se paralizan. No pueden improvisar, y estos sistemas rígidos tampoco.

Esto creó el «cuello de botella de la adquisición de conocimientos». El proceso de sentarse con expertos, extraer su intuición y traducirla en código era insoportablemente lento y caro, lo que en última instancia limitaba cuánto podían escalar realmente estos sistemas.

La segunda congelación y el regreso silencioso de las redes neuronales

La euforia en torno a los sistemas expertos no duró para siempre. El mercado acabó hundiéndose, pero mientras el mundo de la IA simbólica temblaba de frío, otro enfoque -más antiguo y resistente- se calentaba entre bastidores.

El colapso del mercado de las máquinas Lisp

Para entender la caída, tienes que fijarte en el hardware. Las máquinas Lisp eran los pesos pesados de la época: ordenadores especializados e increíblemente caros diseñados exclusivamente para ejecutar programas de IA escritos en Lisp.

¿Qué provocó su extinción hacia 1987? Fue simple economía. Los PC de uso general y las estaciones de trabajo de oficina de Apple e IBM se hicieron lo bastante potentes como para soportar la carga de trabajo, haciendo que esas máquinas especializadas y caras quedaran totalmente obsoletas.

El mercado de los sistemas expertos estaba ligado a ese hardware. Cuando las máquinas murieron, el mercado del software se desplomó, desencadenando el segundo invierno de la IA.

Por qué ha vuelto a bajar el bombo

¿Por qué se han vuelto a congelar los fondos? No era sólo un problema de hardware. La industria había hecho grandes promesas que no podía cumplir, lo que provocó un sentimiento generalizado de decepción entre los inversores.

He aquí exactamente por qué estalló la burbuja esta vez:

- El infierno del mantenimiento: Las bases de reglas de los sistemas expertos se volvieron imposibles de actualizar y mantener a medida que crecían.

- Costes elevados, retorno de la inversión poco claro: Construir y desplegar un sistema experto era extremadamente caro, y el rendimiento de la inversión era a menudo decepcionante.

- Alcance limitado: Los sistemas eran demasiado limitados. Una IA de diagnóstico médico ni siquiera podía entender qué era un «paciente» fuera de sus reglas específicas.

- El auge de las alternativas más baratas: Las soluciones de software más sencillas y convencionales a menudo hacían el trabajo lo suficientemente bien por una fracción del coste.

El silencioso retorno del conexionismo

Mientras el enfoque simbólico se estrellaba, una minoría obstinada seguía trabajando en las redes neuronales. Este enfoque, conocido como conexionismo, sobrevivía silenciosamente en un segundo plano a pesar de la falta de financiación.

Entonces se produjo un cambio teórico masivo a mediados de los 80: el redescubrimiento y la popularización del algoritmo de retropropagación. Fue la clave matemática que finalmente permitió a los científicos entrenar redes neuronales profundas de forma eficaz.

Puedes agradecérselo a figuras como Geoffrey Hinton, Yann LeCun y Yoshua Bengio, que defendieron este enfoque cuando no estaba de moda.

Preparando el camino para la Era Moderna

Aunque esta investigación ocurrió lejos de los focos, fue fundacional. Si te preguntas cuándo se inventó la ai en la forma en que la utilizamos hoy, éste es el verdadero punto de inflexión.

También vimos resultados concretos. Yann LeCun lo aplicó con éxito al reconocimiento de dígitos manuscritos, un sistema que ayudaba a los bancos a leer los cheques automáticamente.

El final del siglo XX terminó con una extraña divergencia. Mientras el bombo comercial de la IA estaba muerto, la investigación fundamental sobre el aprendizaje automático estaba sentando silenciosamente las bases para la dominación masiva de la IA.

Los enfrentamientos Hombre contra Máquina

Nada llama más la atención que una buena pelea. Si preguntas cuándo se inventó la IA, la respuesta académica apunta a 1956, pero para el público en general, la tecnología llegó realmente mucho más tarde. Con el cambio de siglo, la IA salió por fin de los laboratorios teóricos para desafiar a los mayores campeones humanos en su propio terreno.

1997: Deep Blue da jaque mate a Kasparov

El mundo se quedó boquiabierto cuando Deep Blue de IBM derrotó al actual campeón mundial de ajedrez, Garry Kasparov. No fue sólo una partida; fue el momento histórico en que el silicio superó por fin a un gran maestro humano.

Pero seamos sinceros. Esto no era «inteligencia» en el sentido humano. Era fuerza bruta masiva. La máquina utilizó chips personalizados para evaluar la asombrosa cifra de 200 millones de posiciones por segundo, aplastando a Kasparov con cálculos brutos.

Esta victoria marcó el punto álgido del enfoque simbólico. Fue un triunfo de la pura potencia de cálculo, efectivamente el canto del cisne de esa era específica del desarrollo de la IA.

La victoria simbólica y sus límites

Aquí está el truco. Muchos expertos en IA no estaban realmente impresionados. Consideraban que Deep Blue era una magnífica hazaña de ingeniería, pero no un verdadero avance en inteligencia.

¿Por qué el escepticismo? Porque el método de Deep Blue no era generalizable. Una IA construida únicamente para jugar al ajedrez es inútil para todo lo demás. Ni siquiera podría jugar a las damas sin ser reconstruida.

Sin embargo, el impacto psicológico fue innegable. Para el público, demostró que las máquinas podían por fin superar a los humanos en una tarea que considerábamos el pináculo absoluto del intelecto.

2016: AlphaGo y el «movimiento divino»

Avance rápido hasta el antiguo juego del Go. Es infinitamente más complejo que el ajedrez. El número de posiciones posibles en el tablero supera el número de átomos del universo, lo que hace que la fuerza bruta sea totalmente inútil.

Entra AlphaGo, desarrollado por DeepMind. En una partida seguida por millones de personas, aplastó a Lee Sedol, uno de los mejores jugadores del mundo. Ese fue el momento en que todo cambió.

El infame «movimiento 37» de la máquina fue tan inesperado, tan extraño, que los comentaristas pensaron al principio que se trataba de un error. Fue un movimiento nacido no de la fuerza bruta, sino de algo parecido a la intuición.

Por qué AlphaGo era diferente: Un nuevo tipo de inteligencia

Esto era fundamentalmente diferente de Deep Blue. AlphaGo no se limitó a calcular; combinó el aprendizaje profundo con el aprendizaje por refuerzo para comprender realmente el flujo del juego.

Primero, estudió miles de partidas humanas. Después, jugó millones de partidos contra sí mismo, refinando constantemente sus propias redes neuronales para mejorar.

He aquí la verdadera ruptura. AlphaGo no fue programado para jugar bien al Go. Aprendió a jugar. Desarrolló estrategias ajenas que siglos de estudio humano ni siquiera habían descubierto.

El tsunami del aprendizaje profundo: cómo los datos y la potencia lo cambiaron todo

La victoria de AlphaGo fue sólo la punta del iceberg. Detrás del telón, un enorme maremoto llamado aprendizaje profundo estaba remodelando por completo todo el campo.

La vieja idea que por fin encontró su momento

Las redes neuronales no son exactamente una tecnología nueva. De hecho, Warren McCulloch y Walter Pitts propusieron el concepto en 1943. La gente suele preguntar cuándo se inventó el ai, sin darse cuenta de que estas semillas se plantaron hace décadas, permaneciendo como una polvorienta curiosidad académica durante la mayor parte de un siglo.

Entonces, ¿por qué fracasaron durante tanto tiempo? Muy sencillo. Nos faltaba el combustible y el motor. Los investigadores no tenían suficientes datos para entrenarlos, y los ordenadores simplemente carecían de la potencia bruta para hacerlos funcionar con eficacia.

Luego llegó el cambio de principios del siglo XXI. La Ley de Moore siguió aumentando la velocidad de los procesadores, mientras la explosión de Internet generaba océanos de datos (Big Data). De repente, las matemáticas que parecían buenas sobre el papel empezaron a tener sentido en la realidad.

Los tres ingredientes de la receta del aprendizaje profundo

Este éxito no fue magia; fue ingeniería. El repentino auge del aprendizaje profundo se basa en la convergencia de tres elementos específicos. Es la receta exacta que accionó el interruptor.

La Santísima Trinidad del Aprendizaje Profundo:

- Conjuntos de datos masivos: Internet proporcionó enormes conjuntos de datos etiquetados, como ImageNet (millones de imágenes categorizadas), que sirvieron como material de entrenamiento perfecto para redes neuronales hambrientas que necesitaban ejemplos para aprender.

- Cálculo paralelo (GPU): Los ingenieros descubrieron que las Unidades de Procesamiento Gráfico (GPU), originalmente diseñadas para renderizar videojuegos, eran increíblemente eficientes en los cálculos matriciales paralelos necesarios para entrenar redes neuronales. Este descubrimiento fue la chispa que encendió la explosión.

- Mejoras algorítmicas: Los perfeccionamientos de algoritmos como la retropropagación y las nuevas arquitecturas de red hicieron posible entrenar modelos mucho más profundos (de ahí el aprendizaje «profundo») y complejos sin que fallaran o se atascaran.

2012: AlexNet y el momento ImageNet

Entra en el Desafío de Reconocimiento Visual a Gran Escala de ImageNet (ILSVRC). Considéralo como la Copa del Mundo de visión por ordenador. Los equipos compitieron para ver qué programa podía identificar objetos con la menor cantidad de vergüenza.

En 2012, el statu quo se hizo añicos. Una red neuronal profunda llamada AlexNet, construida por el equipo de Geoffrey Hinton, pulverizó a la competencia. Su tasa de error fue casi la mitad de la del segundo clasificado. Fue una masacre.

La conmoción fue instantánea. Los expertos en visión por ordenador, que antes se mostraban escépticos, abandonaron sus antiguos métodos y se pasaron al aprendizaje profundo prácticamente de la noche a la mañana.

De reconocer gatos a conducir coches

Esa victoria abrió la puerta de par en par. De repente, las técnicas de aprendizaje profundo no sólo servían para identificar razas de perros, sino que se aplicaban agresivamente a innumerables problemas sin resolver.

Mira tu teléfono. El reconocimiento de voz como Siri y Alexa, la traducción automática instantánea, e incluso el diagnóstico médico a partir de escáneres, todo se deriva de este cambio.

Pero la cosa va a más. Esta misma tecnología es el cerebro de los coches autoconducidos, que permite a los vehículos «ver» a los peatones e interpretar la carretera. La IA ha dejado de ser un truco de salón para entrar por fin en el mundo real con graves consecuencias.

La Nueva Frontera: La IA Generativa y la Era LLM

Entonces, todo se aceleró. Aunque la gente suele preguntarse cuándo se inventó la IA para encontrar una sola fecha en el pasado, la realidad es que acabamos de entrar en una línea temporal completamente nueva. La IA aprendió no sólo a reconocer patrones, sino a crearlos. Entramos en la era de la IA generativa y, sinceramente, el mundo nunca volverá a ser el mismo.

La Arquitectura Transformadora: «Atención es todo lo que necesitas»

En 2017, un equipo de Google publicó un documento de investigación que cambió silenciosamente todo el panorama tecnológico: «La atención es todo lo que necesitas». Este documento concreto introdujo la arquitectura Transformer, que sigue siendo la columna vertebral de la IA moderna.

He aquí el concepto central que debes comprender: el mecanismo de atención. Permite al modelo sopesar la importancia de las distintas palabras de una frase, independientemente de su distancia entre sí, para comprender plenamente el contexto.

A diferencia de los intentos anteriores, esta arquitectura era muy eficaz y paralelizable para procesar largas secuencias de texto, lo que allanó el camino a los modelos lingüísticos masivos.

BERT, GPT y el auge de los grandes modelos lingüísticos

Los primeros frutos reales de la arquitectura Transformer llegaron muy pronto. Vimos nacer BERT de Google en 2018 y el GPT original de OpenAI ese mismo año.

Es probable que hayas oído hablar del término Gran Modelo Lingüístico (LLM). Se trata básicamente de modelos Transformer gigantes, entrenados en casi todo Internet, diseñados para predecir la siguiente palabra de una secuencia con una precisión asombrosa.

De repente, aparecieron capacidades«emergentes«. Estos modelos empezaron a resumir, traducir e incluso razonar sin haber sido entrenados explícitamente para ello.

2020 y más allá: Cuando la IA se convirtió en la corriente dominante

El verdadero punto de inflexión llegó con el lanzamiento del GPT-3 en 2020. Su capacidad para generar texto que sonaba casi humano asombró a toda la comunidad tecnológica y nos hizo replantearnos lo que podían hacer las máquinas.

Pero el verdadero momento de no retorno para el público fue el lanzamiento de ChatGPT a finales de 2022. La IA se convirtió en una conversación cotidiana para todos.

Al mismo tiempo, asistimos a una explosión de modelos de generación de imágenes como DALL-E 2 y Midjourney. La IA ya no era sólo textual; se había vuelto visualmente creativa, difuminando las líneas entre arte y algoritmo.

¿Qué es realmente la IA Generativa?

Entonces, ¿qué es? La IA Generativa es simplemente una IA que crea nuevos contenidos en lugar de limitarse a analizar o clasificar los datos existentes.

- Es un Sintetizador: No «piensa» ni «entiende», sino que destaca en la concordancia de patrones y en la síntesis de contenidos plausibles basados en sus datos de entrenamiento.

- Es Probabilístico: Su resultado se basa en probabilidades. Genera la secuencia más probable de palabras o píxeles, por eso a veces puede «alucinar» o inventarse hechos.

- Es una Culminación: Esta era no es una nueva invención partiendo de cero. Es el resultado directo de décadas de progreso: la idea de las redes neuronales, el algoritmo de retropropagación, los datos masivos y la inmensa potencia informática.

Desde un esperanzador taller de verano en Dartmouth hasta los chatbots que escriben poesía, la IA ha recorrido realmente un largo camino. Ha sobrevivido a dos inviernos gélidos para convertirse en la tecnología que define nuestra era. El ambicioso sueño de 1956 por fin está vivo y coleando,aunque todavía alucine con algún que otro hecho.